参数的本质与意义

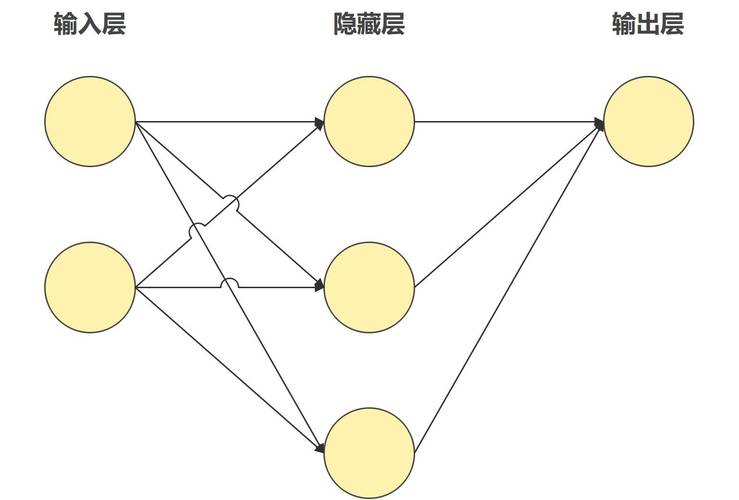

人工智能模型的核心能力,很大程度上由其参数决定,参数可以被视为模型内部存储的“知识库”,是算法通过大量数据学习后形成的数值化规则,每一个参数代表模型对某一特征或模式的认知强度,例如在图像识别任务中,某个参数可能对应“边缘检测”的敏感度,另一个参数可能决定“颜色对比”的权重。

参数的数量通常与模型的复杂程度直接相关,早期的神经网络仅有几百个参数,而现代的大语言模型(如GPT系列)参数规模可达千亿级别,参数越多,模型理论上能捕捉更细微的规律,但也可能带来计算成本上升与过拟合风险。

参数如何影响模型行为

在训练过程中,模型通过调整参数来优化预测结果,以监督学习为例,输入数据经过模型计算后,会得到一个预测值,将其与真实值对比产生误差,再通过反向传播算法将误差逐层反馈,最终更新参数以减小误差,这一过程反复迭代,参数逐渐收敛到使整体误差最小的状态。

在分类任务中,参数的调整直接影响模型区分不同类别的能力,假设一个参数控制“猫耳朵形状”的特征权重,若该参数值较高,模型会更关注图像中的耳朵特征来判断是否为猫;若参数值较低,则可能依赖其他特征(如胡须或尾巴)。

参数与模型性能的平衡

参数的数量并非越多越好,过大的参数量可能导致两个问题:

- 计算资源消耗:训练和推理需要更多内存与算力,对硬件要求更高;

- 过拟合风险:模型过度依赖训练数据中的噪声,导致泛化能力下降。

以自然语言处理为例,若模型参数过多,可能会“死记硬背”训练文本中的特定句式,而非真正理解语法规则,工程师需要在参数量与模型效率之间寻找平衡,常见方法包括剪枝(移除冗余参数)、量化(降低参数精度)或设计更高效的网络结构(如Transformer替代RNN)。

参数的可解释性挑战

尽管参数决定了模型行为,但其具体含义往往难以直观解释,深度学习的“黑箱”特性正源于此:单个参数可能对应抽象特征,而多个参数的组合效应则更加复杂,在人脸识别模型中,某一层参数可能共同表示“眼睛到鼻子的距离”,但这种关联性需通过可视化工具或归因分析才能揭示。

学术界正通过以下方向提升参数可解释性:

- 特征可视化:生成激活特定参数的输入样本,观察其对应的模式;

- 参数重要性分析:识别对输出影响最大的关键参数;

- 模块化设计:构建结构清晰的子网络,限制参数的交互范围。

参数调整的实践建议

对于开发者或企业用户,理解参数需结合实际场景:

- 明确任务需求:简单任务(如二分类)可能只需少量参数,复杂任务(如语义分割)则需要更深层的网络;

- 监控训练动态:通过损失曲线、准确率等指标判断参数是否收敛,避免欠拟合或过拟合;

- 利用预训练模型:基于公开的大规模参数模型(如BERT、ResNet)进行微调,可显著降低训练成本。

需特别注意的是,参数优化并非“一劳永逸”,随着数据分布变化(如用户偏好迁移),模型可能需重新训练以更新参数,适应新环境。

个人观点

参数是AI模型的灵魂,但其价值不在于数量,而在于如何有效组织与利用,当前技术趋势正从“堆参数”转向“参数效率优先”,例如通过稀疏化、动态路由等技术,让更少的参数发挥更大作用,随着神经科学与AI的交叉研究深入,或许我们能更直观地理解参数如何编码智能,进而设计出更强大、更可控的人工智能系统。