理解声音模型的基本原理

声音模型的核心目标是通过学习大量音频数据,模拟人类声音的波形特征、语调变化和情感表达,其技术基础通常基于深度学习框架,如循环神经网络(RNN)、卷积神经网络(CNN)或Transformer架构,以WaveNet、Tacotron等经典模型为例,它们通过分析音频信号的时域和频域特征,逐步生成接近真实人声的输出。

训练过程中,模型需要解决两个关键问题:

- 特征提取:将声音转化为频谱图或梅尔频谱等数学表示,便于算法处理;

- 序列建模:捕捉声音信号的时序依赖关系,例如音节的连贯性、语气的变化。

训练声音模型的关键步骤

数据收集与预处理

高质量的数据集是模型成功的基础,建议遵循以下原则:

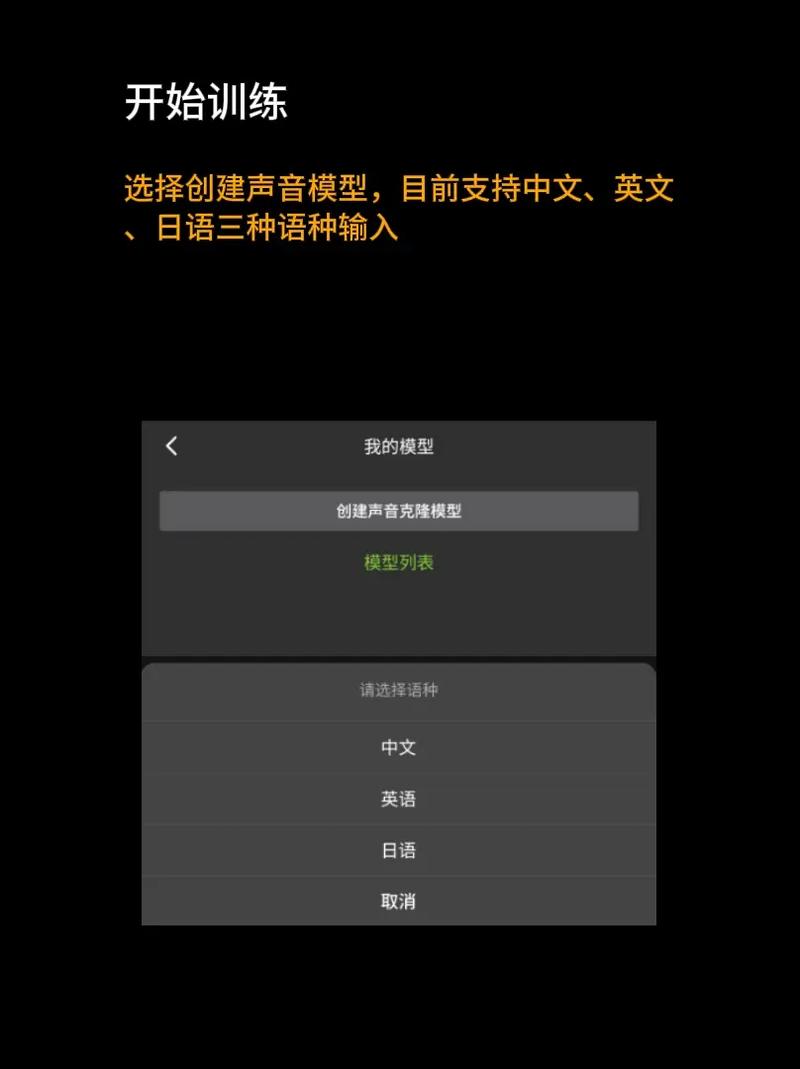

- 数据多样性:涵盖不同性别、年龄、口音的语音样本,增强模型的泛化能力;

- 标注准确性:为音频添加文本转录、情感标签(如喜悦、愤怒)或说话人身份信息;

- 噪声处理:使用降噪工具(如Audacity或Python的Librosa库)去除背景杂音,提升数据纯净度。

对于个人开发者,可考虑开源数据集(如LibriSpeech、VCTK),或通过录音工具自行采集数据,需注意,商业用途需确保数据版权合法。

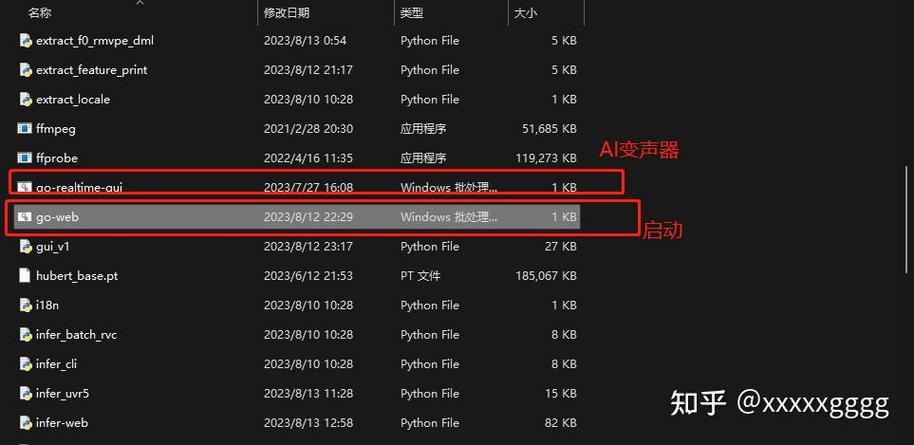

选择合适的算法框架

根据应用场景选择模型架构:

- 语音合成(TTS):Tacotron 2结合WaveGlow可生成自然流畅的语音;

- 声音克隆:使用Transfer Learning技术,在预训练模型(如YourTTS)基础上微调;

- 实时处理:轻量级模型(如LPCNet)更适合低延迟场景。

推荐工具包括TensorFlow、PyTorch及专用语音库ESPnet。

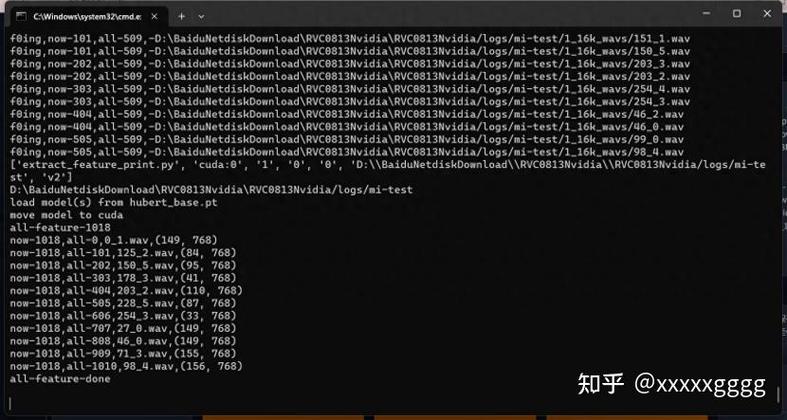

模型训练与调优

- 硬件配置:GPU加速必不可少,显存建议不低于8GB;

- 超参数设置:初始学习率设为0.001,批量大小根据显存调整(通常为8-16);

- 损失函数选择:梅尔谱损失(Mel-Spectrogram Loss)结合对抗训练(GAN)可提升音质;

- 过拟合应对:采用数据增强(如变速、变调)、Dropout或早停法(Early Stopping)。

训练过程中需持续监控验证集效果,避免模型仅“训练数据。

部署与效果评估

模型训练完成后,需通过量化或剪枝技术压缩体积,以便部署到终端设备,评估指标包括:

- 主观测试:邀请用户对合成语音的自然度、清晰度打分;

- 客观指标:计算梅尔倒谱失真(MCD)、语音相似度(如MOS评分)。

常见问题与解决方案

-

声音生硬或不连贯

- 检查训练数据是否包含足够的韵律信息;

- 尝试增加模型层数或引入注意力机制(Attention)。

-

训练时间过长

- 使用混合精度训练(AMP)减少显存占用;

- 采用分布式训练框架(如Horovod)。

-

生成语音存在杂音

- 检查预处理环节是否充分去噪;

- 在损失函数中加入频谱平坦度约束。

伦理与合规性考量

声音模型的滥用可能带来仿冒、隐私泄露等风险,开发过程中需注意:

- 明确告知用户声音的生成属性,避免误导;

- 获得数据提供者的合法授权,尤其涉及名人或特定个体声音时;

- 遵循《生成式人工智能服务管理暂行办法》等法规,建立内容审核机制。