在人工智能技术快速发展的当下,配置AI模型已成为许多开发者和企业实现智能化转型的关键步骤,本文将从基础环境搭建到高级参数调优,以通俗易懂的方式拆解配置流程,帮助不同技术背景的读者建立系统认知。

硬件与环境的基石搭建

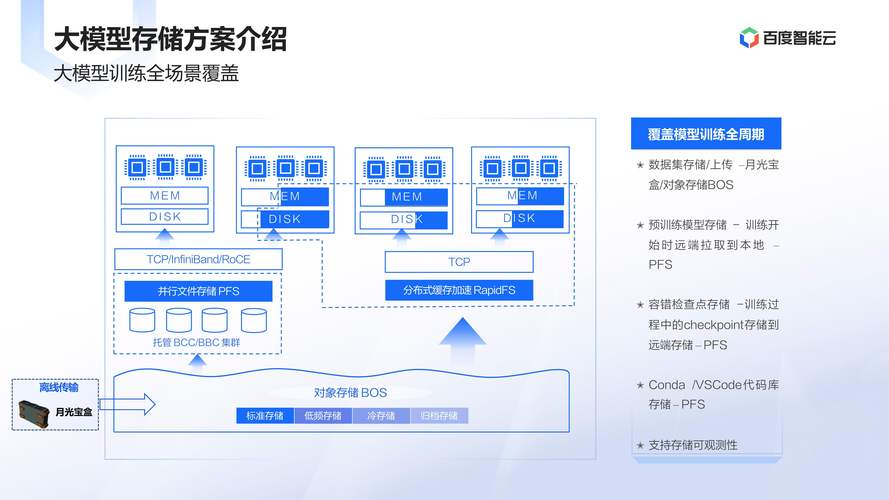

配置AI模型的第一步是选择适配的硬件设备,对于图像识别、自然语言处理等计算密集型任务,建议配备至少16GB显存的NVIDIA显卡(如RTX 3090/4090),若涉及大规模训练,可考虑云端服务(如AWS P4实例)或分布式计算集群,内存建议32GB起步,存储空间需预留原始数据量3倍以上的SSD硬盘。

软件环境建议采用Linux系统(Ubuntu 22.04 LTS为佳),通过Anaconda创建独立Python虚拟环境,以PyTorch框架为例,安装时应严格匹配CUDA版本(如CUDA 11.8对应Torch 2.0+),使用Docker容器化部署能有效避免依赖冲突,建议预先配置NVIDIA Container Toolkit。

模型架构的智慧选择

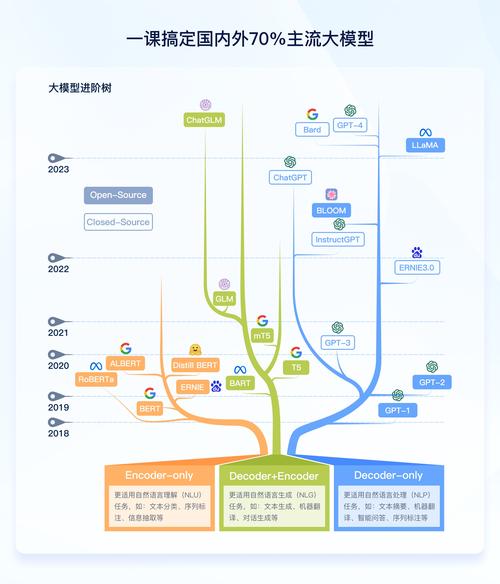

根据任务类型挑选模型框架:

- 计算机视觉:ResNet、YOLOv8、ViT

- 自然语言处理:BERT、GPT-3.5、Llama 2

- 时序预测:Transformer、TCN、N-BEATS

预训练模型的选择需权衡三个维度:

- 任务匹配度(如医疗影像诊断优先选择MedCLIP)

- 计算资源限制(MobileNet适合移动端部署)

- 数据特征(小样本数据建议选用Few-shot Learning模型)

参数配置的精细艺术

学习率设置推荐采用渐进式策略:

optimizer = AdamW(model.parameters(), lr=5e-5) scheduler = CosineAnnealingLR(optimizer, T_max=100)

批量大小(Batch Size)通常设为2的幂次方(32/64/128),内存不足时启用梯度累积技术,正则化参数建议初始值:

- L2权重衰减:1e-4

- Dropout概率:0.2-0.5

- 标签平滑:0.1

损失函数的选择需要与业务目标对齐:

- 类别不平衡问题使用Focal Loss

- 回归任务优先考虑Huber Loss

- 多任务学习采用动态权重调整

训练过程的动态优化

监控训练动态时,除了准确率/Loss曲线,更要关注:

- 梯度范数(保持在0.1-10之间)

- 权重分布直方图

- 特征可视化(使用TensorBoard或Weights & Biases)

早停机制(Early Stopping)应设置耐心值(patience)为5-10个epoch,当验证集损失连续3次未改善时自动降低学习率,混合精度训练可加速30%以上,但需注意:

scaler = GradScaler()

with autocast():

outputs = model(inputs)

loss = criterion(outputs, labels)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

部署落地的实战要点

模型转换阶段,ONNX格式能实现跨平台兼容,量化压缩推荐采用动态范围量化(Dynamic Quantization),在保持95%精度的前提下可将模型体积压缩4倍,服务化部署建议方案:

- 高并发场景:NVIDIA Triton推理服务器

- 边缘设备:TensorRT优化引擎

- Web服务:FastAPI+UVicorn异步框架

性能监控需建立多维指标体系:

- 吞吐量(QPS)与延迟(P99)

- 硬件利用率(GPU显存/算力)

- 数据偏移检测(PSI指数<0.1)

个人观点

配置AI模型如同指挥交响乐团,既要理解每个乐器的特性(硬件/框架),又要把握整体节奏(训练流程),实践中发现,成功的配置往往不是参数的最优解,而是在有限资源下达到的平衡态,建议建立配置决策矩阵,将业务需求、数据特征、资源约束量化为可比较的维度,这将显著提升配置方案的科学性,模型配置是迭代过程而非一次性任务,持续监控与渐进式优化才是保持模型生命力的核心。