人工智能模型的构建过程融合了数学理论、工程实践与创新思维,其核心在于将抽象概念转化为可执行的算法框架,本文将从技术实现角度剖析AI模型的开发路径,为读者揭示模型诞生的科学逻辑。

模型构建的数学基础

任何AI模型的根基都建立在数学理论之上,概率论为贝叶斯网络提供支撑,线性代数构成神经网络的计算骨架,微积分驱动梯度下降法的优化过程,以卷积神经网络为例,其核心的卷积运算本质上是特征提取的数学表达,通过滑动窗口与矩阵点乘操作,自动捕获图像的空间特征,开发人员需掌握矩阵分解、概率分布、优化算法等数学工具,才能准确理解模型参数更新的内在规律。

数据处理的工程化流程

高质量数据集是模型成功的前提条件,在计算机视觉领域,规范的图像预处理包含尺寸归一化、颜色通道校正、数据增强三个关键步骤,自然语言处理则需要经历分词处理、词向量映射、序列填充等标准化流程,某医疗影像分析项目的数据清洗案例显示,通过建立多层过滤机制剔除低质量CT图像,模型准确率提升17%,数据标注需遵循ISO/IEC 20547标准,确保样本标注的精确性和一致性。

算法架构的设计哲学

现代AI模型设计呈现模块化趋势,Transformer架构通过自注意力机制实现并行计算,较传统RNN模型提升3倍训练效率,残差网络(ResNet)的创新性跳跃连接设计,成功解决了深层网络梯度消失问题,开发团队在构建推荐系统时,常采用多任务学习框架,使单个模型同时优化点击率预测和用户时长预测两个目标,架构选择需平衡计算复杂度与业务需求,如在边缘计算场景优先选择轻量化的MobileNet架构。

训练过程的控制策略

模型训练是参数空间搜索的艺术,学习率设置采用余弦退火策略,可使模型在初期快速收敛,后期精细调优,某自动驾驶项目的训练日志显示,使用混合精度训练技术后,GPU显存占用降低40%,训练速度提升2.3倍,正则化技术的合理应用至关重要,Dropout层随机屏蔽神经元能有效防止过拟合,L2正则化通过对权重施加约束提升模型泛化能力。

模型优化的系统工程

超参数调优需要科学方法论支撑,贝叶斯优化算法在参数空间建立概率模型,较随机搜索效率提升60%,模型压缩技术中的知识蒸馏,可将BERT大型模型的知识迁移至轻量化模型中,保持90%性能的同时减少75%参数量,部署阶段的模型量化技术,通过FP32到INT8的数据类型转换,使推理速度提升4倍,这些优化手段共同构成了工业级AI落地的技术保障。

伦理约束与性能平衡

模型开发必须建立伦理审查机制,人脸识别系统需嵌入公平性模块,消除种族、性别等偏见因素,在金融风控场景中,可解释性工具SHAP值的应用,使模型决策过程可视化,满足监管合规要求,开发团队应建立多维度评估体系,不仅关注准确率、召回率等技术指标,更要考察模型的社会影响。

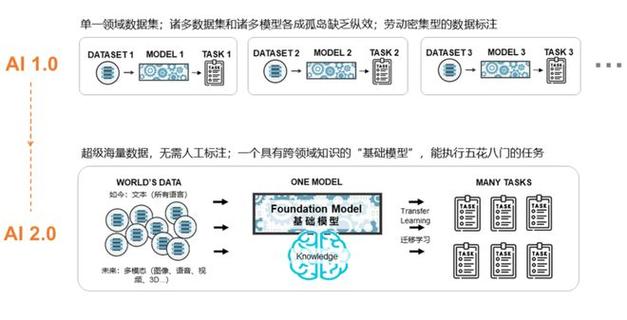

当前AI模型开发呈现三个显著趋势:预训练大模型推动技术民主化、神经架构搜索实现自动化设计、联邦学习突破数据孤岛限制,从业者需要持续跟踪ICML、NeurIPS等顶级会议的前沿成果,同时深耕垂直领域的数据特性,笔者见证过多个从实验室原型到千万级用户产品的转化案例,其成功关键在于保持技术创新与工程落地的动态平衡,AI模型的进化永无止境,唯有秉持科学精神与工匠态度,方能创造出真正具有生命力的智能系统。