华为大模型的技术架构与核心优势

华为自主研发的AI大模型以“盘古”系列为代表,基于昇腾AI处理器和MindSpore深度学习框架构建,其核心优势在于多模态融合能力、高效分布式训练架构以及低代码适配特性,盘古NLP大模型支持千亿级参数规模,可通过微调适配不同行业的语义理解需求;CV大模型则具备图像生成、视频分析等能力,这种模块化设计使得开发者无需从零开始训练模型,而是基于预训练模型快速迭代。

在底层硬件层面,华为提供昇腾910处理器与Atlas系列服务器,单卡算力可达256 TFLOPS(FP16),结合集群组网技术,可支撑超大规模模型的并行训练与推理,软件栈方面,ModelArts平台集成数据标注、模型开发、部署监控全流程工具链,显著降低技术门槛。

接入华为大模型的四种典型路径

华为云API调用

对于中小型企业或轻量化应用场景,直接调用华为云开放的API接口是最快捷的方式,用户需在华为云官网完成账号注册,进入“人工智能”服务板块,选择对应的大模型服务(如自然语言处理、图像识别等),创建API密钥后即可通过HTTP请求调用,使用Python语言调用文本生成接口的代码示例如下:

import requests

url = "https://nlp.cn-north-4.myhuaweicloud.com/v1/{project_id}/nlg/text-generation"

headers = {"X-Auth-Token": "your_token"}

data = {"text": "人工智能的未来趋势是", "max_length": 100}

response = requests.post(url, json=data, headers=headers)

print(response.json())

本地化部署方案

金融、政务等对数据安全性要求较高的行业,可采用华为Atlas硬件设备进行本地化部署,具体流程包括:

- 采购搭载昇腾处理器的服务器

- 通过ModelArts Edge模块下载预训练模型

- 使用MindSpore Lite进行模型轻量化压缩

- 部署至本地服务器并配置API网关

此方案需技术人员具备一定的容器化部署经验,华为提供专业技术支持团队协助完成环境配置。

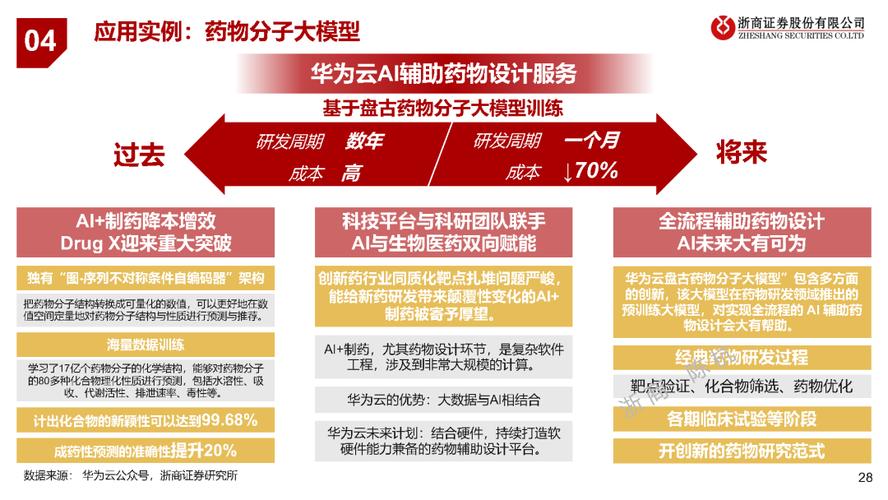

行业定制化开发

针对医疗、制造等垂直领域,华为提供大模型+行业知识库的联合训练服务,企业需准备符合规范的标注数据集(通常要求标注量在10万条以上),通过ModelArts平台上传数据并配置训练参数(如学习率、批次大小),训练完成后,系统自动生成模型评估报告,支持A/B测试验证效果。

生态合作伙伴接入

加入华为昇腾生态联盟的企业,可获取底层框架级支持,与华为达成战略合作的ISV(独立软件开发商),能够直接调用MindSpore的分布式训练接口,实现模型结构与训练策略的深度定制,这种方式适合具备较强AI研发能力的团队。

接入过程中的关键注意事项

- 算力资源评估:大模型推理对硬件资源消耗较高,需提前规划GPU/NPU配置,运行盘古NLP大模型的最小显存需求为32GB,推荐使用至少4卡Atlas 800服务器。

- 数据合规性审查:训练数据需符合《生成式人工智能服务管理暂行办法》,涉及个人信息的场景必须完成脱敏处理。

- 模型量化优化:通过剪枝、蒸馏等技术将模型体积压缩50%-70%,可大幅降低推理延迟,华为提供自动压缩工具AMCT,支持INT8量化且精度损失控制在2%以内。

- 监控体系建设:部署后需实时监控QPS、响应时间、错误率等指标,华为CloudEye服务可设置阈值告警,自动触发扩容操作。

典型场景落地案例

某省级三甲医院接入华为医疗大模型后,构建了智能辅助诊断系统,具体实施分为三个阶段:

- 数据准备:脱敏处理12万份电子病历、30万张医学影像,标注关键病理特征

- 模型微调:在盘古医疗大模型基础上,使用LoRA技术进行低秩适配训练,耗时48小时

- 系统集成:将模型封装为Docker镜像,与医院PACS系统对接,实现CT影像的自动病灶标注

上线后,放射科医生的工作效率提升40%,漏诊率下降15%,该项目验证了大模型在专业领域的实用价值。

华为AI大模型的接入并非简单的技术对接,而是需要结合业务目标、资源投入、合规要求进行系统化设计,从API快速试水到深度定制开发,不同路径对应不同的 ROI 曲线,对于多数企业,建议从云端API起步,逐步积累数据与经验后再向本地化部署过渡,在推进过程中,技术团队需要重点关注模型的可解释性——例如使用LIME工具可视化决策依据,这对医疗、法律等高风险场景尤为重要。

当前,大模型技术仍处于快速迭代期,华为已在研发多模态具身智能模型,未来接入方式可能进一步向自动化、低代码化演进,但无论如何变化,掌握“场景定义能力”比单纯追求技术参数更重要——找到大模型与业务痛点的精准结合点,才是智能化转型的真正突破口。