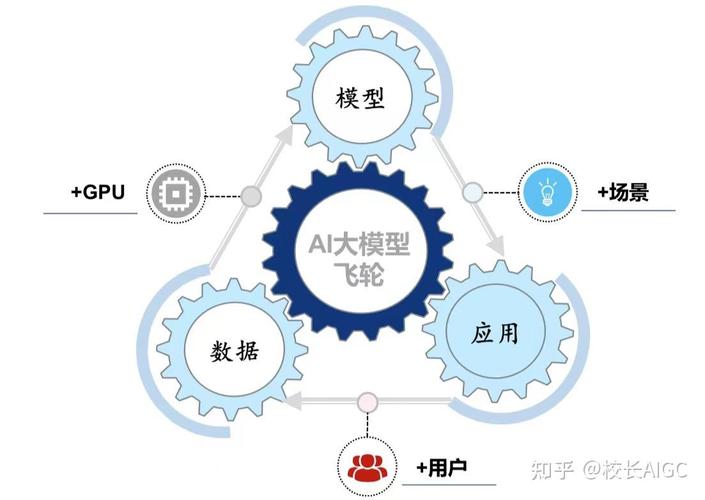

动手训练AI大模型:从数据到智能的自主探索

在人工智能技术快速发展的今天,AI大模型已成为推动行业变革的核心工具,无论是生成文本、分析数据,还是辅助决策,大模型的潜力有目共睹,但对于普通用户或中小型团队来说,如何绕过技术壁垒,独立完成AI大模型的训练?本文将提供一套实用指南,帮助你在资源有限的情况下,逐步实现自主喂养AI模型的目标。

明确目标:从需求出发选择模型类型

训练AI大模型的第一步并非直接处理数据,而是明确“模型要解决什么问题”,若目标是生成创意文案,需优先选择自然语言处理(NLP)类模型;若需处理图像识别,则需聚焦计算机视觉框架。

关键建议:

- 聚焦垂直场景:避免追求“全能型”模型,优先在细分领域积累数据与经验。

- 选择开源框架:如Hugging Face的Transformers库、TensorFlow或PyTorch,可降低开发门槛。

- 评估算力资源:根据硬件条件选择模型规模,例如7B参数的模型对算力要求较低,适合入门。

数据收集:高质量输入决定模型上限

数据是AI大模型的“养料”,但并非所有数据都适合直接投喂,需围绕目标场景构建结构化、多样化、高相关性的数据集。

数据来源推荐:

- 公开数据集:如Common Crawl(网页文本)、ImageNet(图像分类)、Kaggle(行业数据)。

- 自有数据:企业内部的用户行为日志、产品文档、客服对话记录等。

- 合成数据:利用工具生成模拟数据,弥补真实数据的不足(需注意数据偏差风险)。

处理要点:

- 清洗与标注:去除重复、低质内容,对非结构化数据(如图片、音频)进行标签分类。

- 平衡分布:确保数据涵盖不同类别或场景,避免模型偏向某类结果。

- 隐私合规:匿名化处理涉及个人信息的数据,遵守《个人信息保护法》等法规。

模型训练:从基础到优化的全流程

预训练与微调

若资源有限,可直接基于开源预训练模型(如Llama、BERT)进行微调,这种方式能利用已有知识,减少训练时间。

操作步骤:

- 加载预训练权重:通过框架API调用模型参数。

- 调整模型结构:根据任务增减层数、修改输出维度。

- 设置超参数:学习率、批次大小(Batch Size)、训练轮次(Epoch)需反复调试。

分布式训练与硬件适配

- GPU/TPU选择:单卡训练适用于小规模模型;多卡并行或云服务(如AWS、Google Colab)可加速大规模训练。

- 混合精度训练:利用FP16或BF16格式减少显存占用,提升速度。

防止过拟合

- 交叉验证:将数据分为训练集、验证集和测试集,监控模型泛化能力。

- 正则化技术:如Dropout、权重衰减(Weight Decay)。

- 早停法(Early Stopping):当验证集损失不再下降时终止训练。

模型评估:量化性能与持续迭代

训练完成后,需通过多维指标验证模型效果:

- 任务相关指标:如文本生成可用BLEU、ROUGE分数;分类任务用准确率、F1值。

- 资源消耗:推理速度、内存占用需符合实际应用场景需求。

- 人工校验:组织小范围测试,收集用户反馈,发现逻辑错误或偏见问题。

迭代策略:

- 增量训练:定期用新数据更新模型,保持其时效性。

- A/B测试:对比新旧模型效果,逐步优化。

伦理与法律:不可忽视的隐形门槛

自主训练大模型不仅是技术挑战,更需承担社会责任:

- 版权风险:避免使用未经授权的书籍、论文或代码数据。

- 偏见控制:定期检测模型输出是否包含性别、种族歧视内容。

- 透明性:若模型用于商业场景,需向用户说明AI的决策逻辑边界。

个人观点:开源社区是个人开发者的关键机会

当前,AI大模型的训练已不再是科技巨头的专利,随着Meta、Mistral等公司开源模型的发布,个人开发者完全可以通过合理利用工具链、参与社区协作,在有限资源下实现突破,但需注意,技术的平民化也意味着竞争加剧——唯有持续深耕垂直领域,构建独特的数据壁垒,才能在AI浪潮中站稳脚跟。