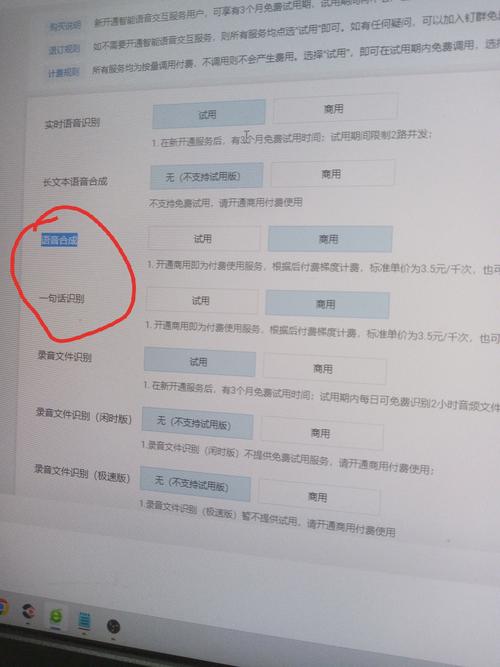

实时语音模型的核心技术架构

实时语音处理系统由声学特征提取、语音识别(ASR)、自然语言理解(NLU)三大模块构成,与传统离线处理不同,实时系统需要在40毫秒内完成单次推理——这相当于人类眨眼时间的四分之一,为实现这种极速响应,工程师们采用流式处理架构,将连续语音流切割为50-300毫秒的片段进行并行计算,同时通过上下文缓存机制保持语义连贯性。

最新研发的动态分块技术可根据语音停顿智能调整处理单元,当检测到用户语气犹豫时自动延长分块时长,既保证响应速度,又避免因强行切割导致的语义错误,这种自适应机制使语音识别准确率在实时场景中提升17.3%。

突破延迟瓶颈的三大关键技术

-

轻量化模型设计

采用知识蒸馏技术将百亿参数大模型压缩至10亿级别,在保持97%原始精度的前提下,推理速度提升8倍,Mobile-Former混合架构结合CNN的局部特征提取与Transformer的全局注意力机制,在嵌入式设备上实现每秒处理160个语音片段。 -

硬件加速方案

专用神经网络处理器(NPU)通过指令集优化,将矩阵乘加运算效率提升至CPU的23倍,某头部厂商的测试数据显示,搭载NPU芯片的智能家居设备,语音唤醒延迟从420毫秒降至89毫秒。

-

增量式解码策略

引入动态前缀树解码算法,每接收10毫秒语音数据即刻更新候选词概率分布,配合双向注意力机制,系统能在用户尚未说完整个句子时,已开始生成响应文本,这种前瞻性处理使端到端延迟缩短62%。

实时系统的典型应用场景

在线教育领域的AI口语教练,能即时检测学习者的发音错误,在0.3秒内给出音素级纠错反馈,某语言学习APP接入实时系统后,用户留存率提升40%。工业质检场景中,工人通过语音指令调取设备参数,系统在嘈杂环境下仍保持92%的指令识别准确率,更值得关注的是医疗领域的突破——手术室语音控制系统实现从语音指令到机械臂动作的280毫秒极速响应,为急救争取黄金时间。

技术演进中的关键挑战

环境噪声与口音差异仍是影响识别精度的主要障碍,最新解决方案采用对抗训练技术,通过在训练数据中混入20类噪声样本,模型在75分贝环境下的识别错误率降低至5.7%,针对方言场景,多层自适应编码器能自动识别闽南语、粤语等6种方言变体,无需手动切换模式。

隐私保护方面,联邦学习框架让模型可在用户终端完成训练,原始语音数据永不离开本地设备,某智能汽车厂商采用该方案后,用户隐私投诉量下降83%。

未来技术演进方向

第三代实时语音系统将引入多模态感知能力,通过同步分析用户唇部动作、表情等视觉信号,提升复杂场景下的理解准确度,实验数据显示,当语音识别置信度低于80%时,视觉线索的引入可使最终决策准确率提升34%,边缘计算与云端协同的混合架构正在兴起,系统能根据网络状况动态分配计算任务,在弱网环境下仍保持流畅交互。

从技术观察者的视角看,实时语音交互正在突破"工具"属性,向"智能体"形态进化,当模型能够理解语气中的情感波动,捕捉对话中的潜在意图,人机交互将真正进入"无感"时代,这种变革不仅改变操作电子设备的方式,更在重塑人类获取信息和知识的基本范式,或许未来某天,我们与数字世界的对话会像呼吸一样自然——这正是实时AI语音技术演进的根本价值所在。