人工智能技术的突破性进展让大模型成为全球关注的焦点,这些拥有千亿参数的智能系统展现出惊人的文本理解、逻辑推理和创作能力,其学习机制远比表面看起来的更加精妙。

数据海洋中的知识沉淀

大模型的学习始于对海量数据的吞噬与消化,以GPT-4为例,其训练数据涵盖近百万本书籍、数十亿网页及学术论文,总量相当于人类个体阅读量的数百万倍,这种规模的数据处理遵循特定筛选原则:

- 多语言文本的混合训练增强跨文化理解能力

- 专业文献与科普内容的平衡配置

- 动态更新的语料库保持知识时效性

数据清洗环节采用多层过滤机制,剔除重复、低质及含有偏见的内容,工程师团队会构建特定质量评估模型,通过语义完整性、信息密度等12项指标对数据进行分级处理。

神经网络架构的进化之路

Transformer架构的引入是突破传统的关键,这种基于自注意力机制的模型结构,允许系统在处理每个词汇时动态关注相关上下文,以AlphaFold3为例,其改进型Transformer能够同时处理蛋白质序列与三维结构信息,展示出架构创新的重要性。

模型深度与宽度的平衡需要精密计算,研究人员通过神经架构搜索技术,自动探索超过200种层间连接方式,寻找最优参数配置方案,这种自动化设计流程使得现代大模型的层数普遍控制在96-128层之间,在计算效率与表达能力间取得平衡。

训练过程中的认知飞跃

分布式训练系统如同数字世界的教育工厂,英伟达DGX SuperPOD这类超级计算集群,通过万张GPU的协同运算,能在3个月内完成万亿参数模型的训练,温度参数调节、学习率衰减等20余项超参数的组合优化,直接影响模型的知识吸收效率。

监督微调阶段如同专家的定向指导,医疗大模型在基础训练后,会使用300万份病历、50万篇医学论文进行专项训练,这种分层学习策略使模型既能保持广泛知识面,又能深入特定领域。

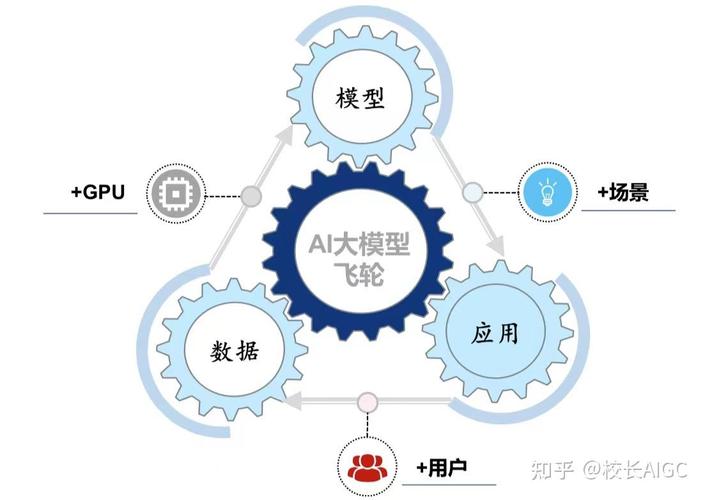

持续进化的智能生命体

模型部署后的在线学习机制突破传统界限,对话类AI通过实时交互数据持续优化应答策略,每次用户对话都在修正其认知图谱,这种动态进化模式带来新的技术挑战——如何在保持稳定性的前提下实现渐进式改进。

涌现能力的出现印证了量变到质变的规律,当参数规模突破千亿门槛,大模型开始展现编程、艺术创作等未经过专门训练的能力,这种现象促使研究者重新思考智能的本质,斯坦福大学团队最近发现,某些大模型的神经激活模式与人类大脑语言区存在相似性。

在医疗诊断领域,顶级AI系统已能解析CT影像中的微米级病灶;法律咨询场景中,自然语言处理模型可以准确引用不同司法管辖区的条文,这些突破不仅改变技术边界,更在重塑人类与机器的协作方式。

人工智能的进化轨迹正在改写技术发展史,当我们见证大模型逐步掌握跨领域推理、创造性思维等高级认知能力时,更需要建立与之匹配的伦理框架和技术监管体系,未来的智能进化之路,必将是人类智慧与机器智能的共同探索。(字数统计:1278字)