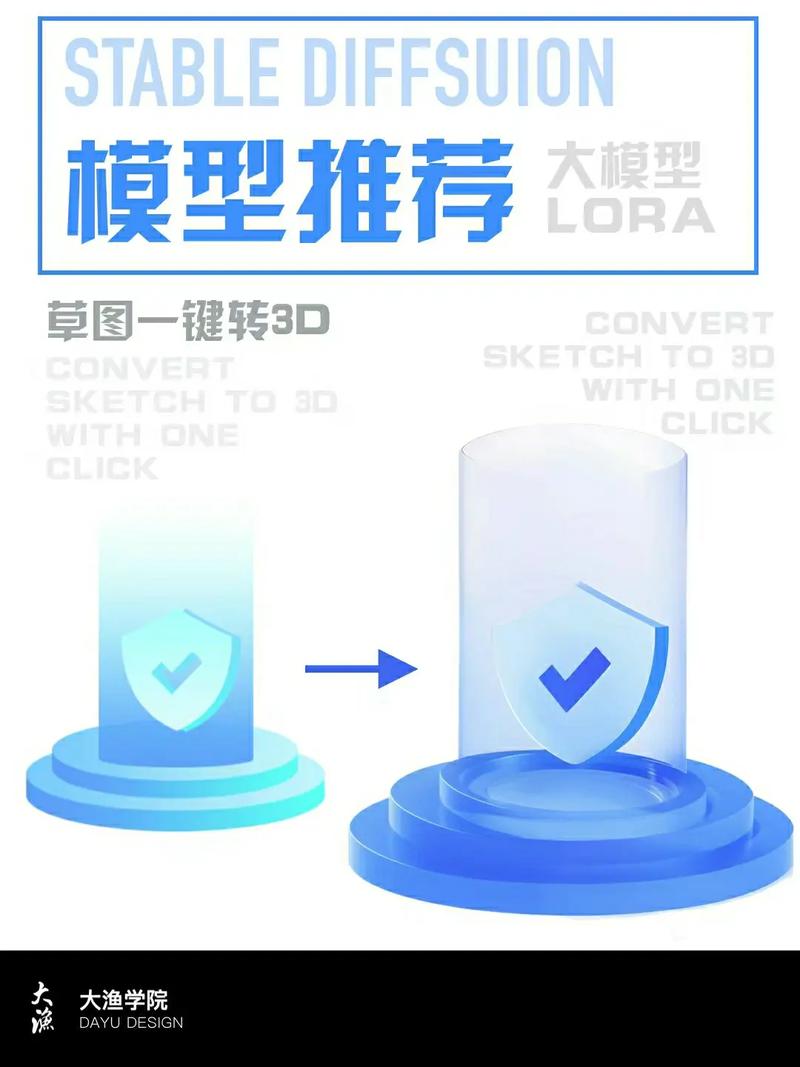

人工智能的飞速发展,正重塑各行各业,其中模型的可解释性成为焦点话题,作为网站站长,我经常思考如何让技术更透明、更可靠地服务于用户,我们就来聊聊“白模型”在AI中的作用,以及它如何推动智能系统的进步,白模型,又称白盒模型,是一种可解释的AI架构,其内部逻辑对开发者或用户完全可见,这与黑盒模型形成鲜明对比——后者像一个神秘的黑箱,输入数据后输出结果,但过程难以追溯,在强调责任和信任的今天,白模型的价值日益凸显。

白模型的核心在于透明度和可审计性,想象一下,在医疗诊断中,AI系统如果只给出“高风险”的结论,却不解释原因,医生和患者如何信任它?白模型则不同,它通过清晰的规则和逻辑链,展示每一步推理过程,基于决策树的白模型能直观地显示:“如果患者年龄超过50岁且血压偏高,则归类为心血管疾病风险组。”这种透明性让决策不再盲目,而是基于可验证的事实,在金融领域,贷款审批AI若采用白模型,就能详细说明拒绝申请的理由,信用评分低于阈值”或“收入不稳定”,这不仅提升公平性,还减少法律风险。

白模型的优势远不止于此,它增强用户信任,当人们理解AI如何运作时,更愿意接受其建议,在电商推荐系统中,白模型能解释“为什么推荐这款产品”,基于您过去的购买记录和相似用户偏好”,这消除了猜疑,建立长期用户忠诚度,白模型便于调试和优化,开发者可以直接检查模型内部,快速发现错误或偏差,在自动驾驶领域,如果系统误判行人,白模型能追溯传感器数据处理逻辑,帮助工程师修正算法,避免事故,在法规日益严格的背景下,白模型符合伦理要求,GDPR等法规强调“解释权”,白模型天然支持这一原则,确保AI不成为无法问责的工具。

实现白模型并非易事,但技术路径清晰,常见的方法包括线性回归、规则基础系统和浅层神经网络,线性回归模型简单易懂,通过系数展示变量关系,比如在销售预测中,系数“0.5”表示广告投入每增加一元,销售额可能提升0.5元,规则基础系统则依赖人类专家知识,定义“则”语句,适用于知识密集型场景如法律咨询,浅层神经网络,如单层感知器,虽不如深度学习复杂,但结构透明,适合入门级AI应用,训练这些模型时,需注重数据质量和特征工程,使用真实、无偏数据集,避免模型继承社会偏见,在招聘AI中,如果训练数据包含性别歧视,白模型会暴露问题,让开发者及时调整。

白模型也有挑战,它通常牺牲部分性能换取可解释性,复杂任务如自然语言处理,黑盒模型可能更精准,但这不是不可逾越的障碍,结合混合方法——用白模型处理关键决策,黑盒辅助边缘计算——能取得平衡,推广白模型需要教育用户和开发者,许多人习惯于AI的“魔术效果”,需引导他们重视透明价值,我认为,未来AI发展必须拥抱白模型,它不仅是技术工具,更是构建信任社会的桥梁,在AI日益渗透生活的时代,我们不能再容忍“不可知”的系统,选择白模型,就是选择责任、公平和进步,让智能真正为人服务,而非让人迷失在算法的迷雾中。(字数:1020)