在数字艺术的世界里,AI生成动漫模型正迅速成为创作者的热门工具,它让任何人都能快速设计出风格鲜明的动漫角色,从萌系少女到热血英雄,全都唾手可得,作为一名长期关注AI技术的从业者,我亲眼见证了这项技术如何从实验室走向主流,我就来详细聊聊AI生成动漫模型的具体过程,帮助大家理解其核心原理和应用价值。

要理解AI如何生成动漫模型,首先得明确什么是动漫模型,简单说,它是一种基于深度学习的系统,专门训练来产生动漫风格的图像,动漫风格通常以夸张的大眼睛、流畅的线条和鲜明色彩为特征,比如日本动漫或欧美卡通,AI模型通过学习大量现有动漫图片,捕捉这些视觉元素,然后生成全新的原创作品,整个过程依赖强大的算法,而不是简单复制现有内容。

核心的技术基础是生成对抗网络(GANs)和扩散模型,GANs由两个神经网络组成:一个生成器负责创造图像,另一个判别器负责评估图像的真实性,两者相互竞争,推动生成器不断改进输出,生成器可能先产生模糊的草图,判别器则指出它与真实动漫的差距;经过数万次迭代,生成器学会输出精细的角色设计,扩散模型则更先进,它通过逐步添加和去除噪声来构建图像,模型从随机噪声开始,一步步“去噪”,最终形成清晰的动漫画面,这类模型在处理复杂细节上表现优异,比如渲染头发纹理或光影效果。

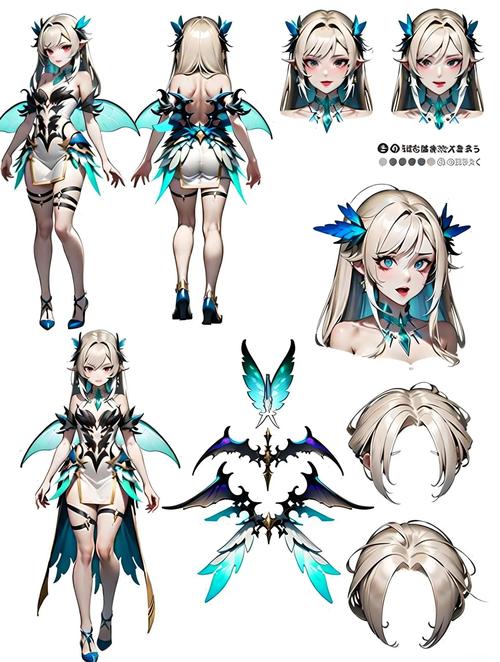

生成动漫模型的具体过程可分为三个阶段:数据准备、模型训练和图像生成,数据准备是关键起点,开发者需要收集大量高质量的动漫图像数据集,通常来自公开资源如动漫作品截图或艺术社区分享,数据集必须多样化,涵盖不同风格、角色和场景,以确保模型学习到丰富特征,数据清洗也很重要,去除低质量或重复图像,避免训练偏差,接下来是模型训练阶段,这里使用框架如TensorFlow或PyTorch,将数据输入算法,训练通常在GPU集群上进行,耗时数天甚至数周,模型通过反向传播调整参数,目标是让输出尽可能接近真实动漫,最后是图像生成阶段,用户输入文字提示,穿着校服的少女,樱花背景”,模型基于训练知识快速合成图像,整个过程自动化,但创作者可以微调参数,如调整颜色饱和度或线条粗细,获得个性化结果。

实际应用中,工具有多种选择,开源平台如Stable Diffusion专为动漫优化,允许用户自定义风格;商业软件如MidJourney则提供更友好的界面,这些工具降低了技术门槛,非专业人士也能轻松上手,挑战依然存在,数据偏见是常见问题:如果训练集缺乏多样性,模型可能产出刻板化角色,比如过度强调特定性别或种族,版权争议也不容忽视,AI生成的内容常基于现有作品,可能侵犯原作者权益,建议创作者使用合规数据集,并添加原创元素,另一个限制是计算资源需求:高质量生成需要强大硬件,普通用户可能依赖云服务,但这会增加成本。

展望未来,AI生成动漫模型将深刻改变创意产业,它赋予艺术家新工具,加速原型设计,甚至推动交互式叙事,但技术永远只是辅助,核心创造力仍来自人类,作为从业者,我认为平衡创新与伦理至关重要,开发者应优先透明训练过程,确保公平性;用户则需尊重原创,避免滥用,AI不是替代艺术家,而是放大想象力的伙伴,它将动漫艺术推向新高度,让每个人都能成为自己故事的导演。