AI大模型如何处理数据:从原始信息到智能涌现

在人工智能领域,大型语言模型展现出的惊人能力——流畅对话、精准创作、复杂推理——其核心驱动力并非凭空而来,而是源于对海量数据的系统性、多阶段处理,理解这一数据处理流程,是洞悉其能力边界与局限性的关键。

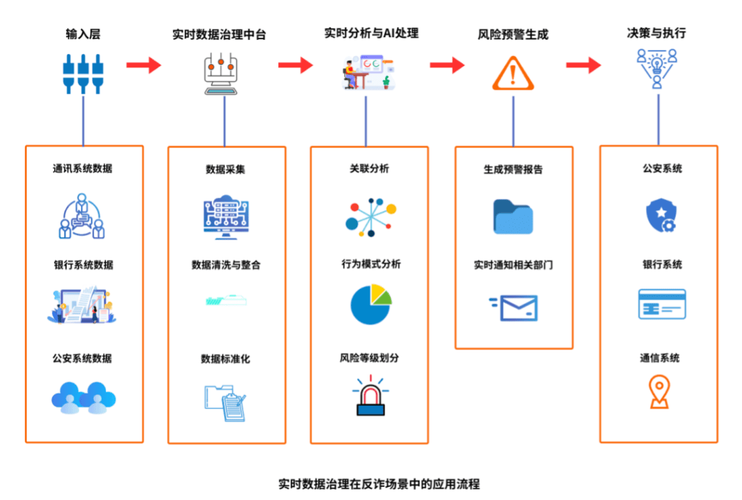

第一阶段:数据采集与广泛清洗

模型的智慧始于数据的广度与质量,研发团队会从极其多元的渠道汇集文本与代码:

- 开放网络资源: 海量的网页内容、百科知识、论坛讨论、新闻资讯构成了知识主干。

- 出版文献与书籍: 经过授权的电子书籍、学术论文提供深度知识与规范语言范例。

- 特定领域语料: 如医学文献、法律条文、编程代码库(如GitHub公开项目),用于提升专业领域能力。

- 许可对话数据: 部分经严格合规审查的对话记录,助力模型理解自然交互。

面对如此庞杂的原始数据,深度清洗至关重要:

- 去重与过滤: 剔除重复内容、机器生成的垃圾信息、明显包含恶意攻击或极端观点的文本。

- 格式标准化: 统一文本编码(如UTF-8)、清除无关HTML标签、修复破损字符。

- 敏感信息处理: 应用自动化工具结合人工审查,识别并遮盖或移除个人身份信息(PII)。

- 质量分级: 初步评估内容可信度与价值,为后续训练采样提供依据。

第二阶段:数据预处理与特征工程

清洗后的数据需转化为模型可“消化”的结构化形式:

- 标记化: 将连续文本分割成基本单元(词、子词或字符),人工智能”可能被拆分为“人工”和“智能”两个子词标记。

- 构建词汇表: 创建包含所有唯一标记及其对应数字ID的映射词典,模型只“认识”这些数字。

- 上下文表征: 应用先进技术(如位置编码、注意力机制),使模型理解单词在句子中的顺序和相互关系。

- 数据增强(可选): 通过回译(中译英再译回中)、同义词替换、小范围句子重组等方式,在可控范围内增加数据多样性,提升模型鲁棒性。

第三阶段:模型训练与知识内化

这是算力与算法密集的核心阶段:

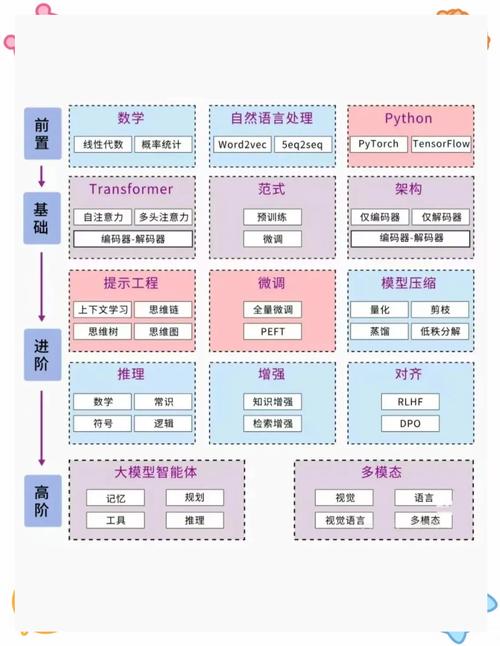

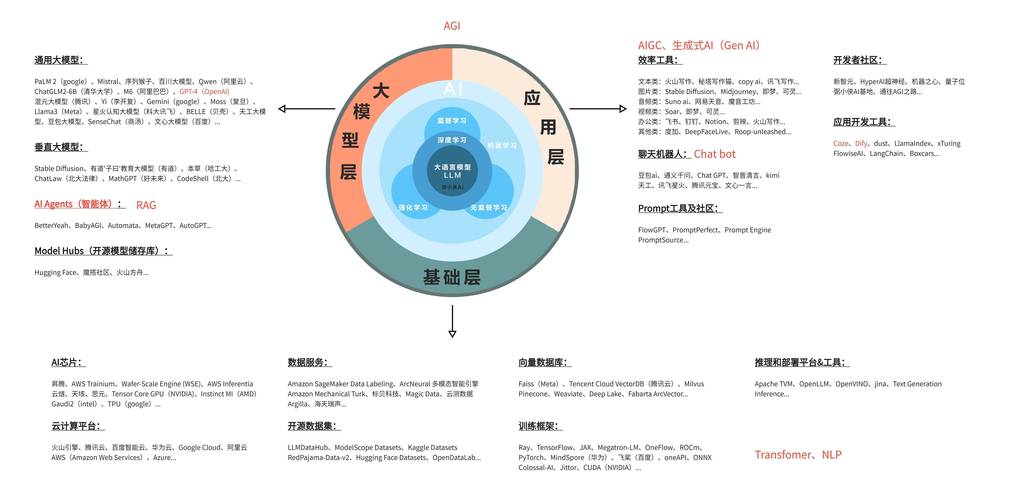

- 架构选择: 采用Transformer架构,其自注意力机制能高效捕捉文本长距离依赖关系。

- 预训练任务: 主要通过“掩码语言建模”(随机遮盖句子中的词,让模型预测被遮盖词)和“下一句预测”(判断两个句子是否连续)等自监督任务,让模型学习语言统计规律和世界知识。

- 海量计算投入: 在配备数千张高性能GPU的集群上,模型反复遍历处理后的海量数据批次,通过梯度下降算法调整内部数万亿参数(以GPT-4为例),逐渐拟合数据分布。

- 损失函数驱动: 模型预测结果与实际数据差异(损失)被持续计算并反馈,指导参数优化方向。

第四阶段:精调与推理应用

预训练模型具备广泛知识后,还需针对性优化:

- 指令精调: 使用人工精心编写的指令-回复对数据集,训练模型理解并遵循人类指令。

- 基于人类反馈的强化学习: 引入人类对模型多个输出结果的偏好排序,训练奖励模型,进而通过强化学习大幅提升输出质量、安全性和有用性。

- 领域适配: 在特定垂直领域(如医疗、金融),使用专业语料进行额外训练,提升任务表现。

- 推理部署: 模型训练完成后,部署到服务器或云端,处理用户输入时,同样经历标记化、转换为向量、多层神经网络计算,最终生成概率最高的下一个词序列。

数据处理的深远影响与挑战

数据处理的质量直接决定了模型能力的上限与下限,低质量、有偏见的数据必然导致模型输出偏见甚至错误,训练数据中若充斥性别刻板印象,模型对话也可能无意间强化偏见;若医疗数据存在误报,模型诊断建议便可能失准,持续优化数据来源的多样性、代表性和清洁度,是提升模型性能与可信度的永恒课题,处理过程中的隐私保护、版权合规、能源消耗等问题,也需技术与伦理的双重审视。

数据如同大模型呼吸的空气与汲取的养分,其处理流程的精密性、严谨性与规模,共同塑造了模型的理解力、创造力与可靠性,在追求更强大智能的道路上,对数据的敬畏与持续优化是根基所在。

个人观点: 数据处理的严谨程度,往往比模型架构的微小改进更能决定一个AI项目的成败,高质量、无偏见、广覆盖的数据是大模型真正具备实用价值和社会信任的基石,忽视数据治理,再先进的算法也只是空中楼阁,未来AI的竞争,本质上是数据获取、清洗与运用能力的竞争。