如何亲手打造专属的AI宠物明星视频?

想让家中毛茸茸的伙伴成为屏幕主角,演绎一段奇幻故事或学会“说话”?AI宠物模型视频技术让这一切触手可及,只需几步,你就能创造出独一无二、充满创意的宠物视频内容。

第一步:明确目标与选择趁手工具

- 创意构思: 宠物是扮演超级英雄、讲述故事,还是与虚拟环境互动?清晰目标决定后续技术选择。

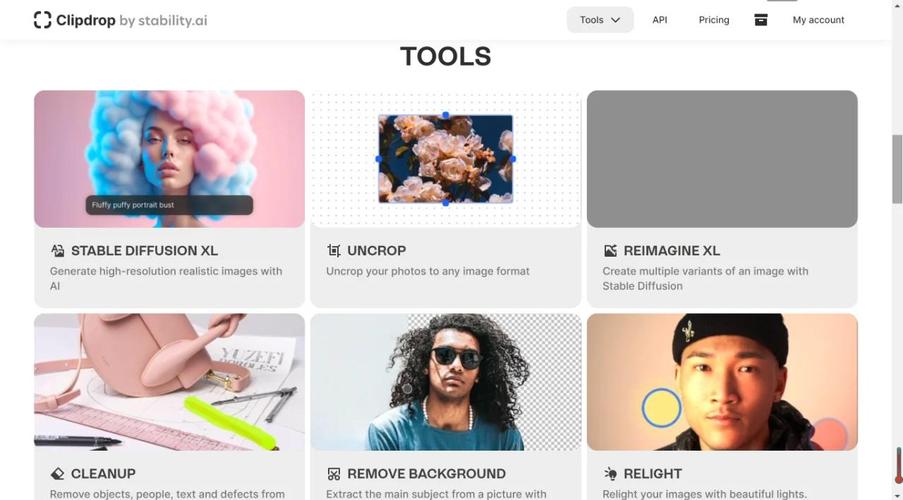

- 工具筛选:

- Runway ML (Gen-2): 强大文本生成视频功能,输入描述如“金毛犬在火星漫步”,即可获得初步动态画面,擅长创意场景构建。

- Pika Labs / Kaiber: 同样支持文生视频,操作直观,适合快速将想法视觉化。

- HeyGen / D-ID: 若想实现宠物“开口说话”,这两款工具能精准驱动口型同步,赋予宠物生动“语言能力”。

- 专业级选择: 对动态效果有极致追求?考虑结合Stable Diffusion生成关键帧,再利用EbSynth生成流畅动画。

第二步:高质量素材——成功的基石

- 海量清晰影像: 收集宠物不同角度(正面、侧面、抬头、低头)、丰富表情(开心、警觉、困倦)、多样动作(跑、跳、坐、躺)的照片和视频,目标:至少20-30张高清照片,10-20分钟高清视频片段。

- 突出特征捕捉: 特殊斑纹、耳朵形状、尾巴姿态等细节务必清晰呈现,这直接决定AI模型的还原度。

- 背景简洁为王: 拍摄时选择纯色或简单背景,减少干扰,让AI更易聚焦主体。

第三步:训练你的专属宠物AI模型

- 平台选择:

- Midjourney / Leonardo.ai: 上传宠物照片,训练自定义模型(需订阅),输入“@YourPetModelName 戴着牛仔帽弹吉他”等指令,生成风格化图像。

- Stable Diffusion (搭配LoRA): 技术进阶选择,在Automatic1111等平台,利用宠物照片集训练轻量高效的LoRA模型,实现高度可控的图像生成。

- 训练要诀: 图片标注精准(如“golden_retriever_max_closeup”),确保数据质量,耐心调整训练参数,避免过拟合(模型只能复现训练图)或欠拟合(无法抓住特征)。

第四步:生成与精修你的视频杰作

- 动态化处理:

- 静态图转视频: 在Runway、Pika或Kaiber中上传AI生成的宠物图片,添加动态提示(如“微风轻拂毛发”、“尾巴缓缓摇摆”)。

- 口型同步魔法: 在HeyGen或D-ID上传宠物正面清晰图片或视频,输入台词,AI自动生成逼真口型动画。

- 后期打磨: 将生成的视频片段导入剪映、CapCut或DaVinci Resolve,进行专业剪辑:

- 剪辑拼接: 调整节奏,串联不同镜头。

- 音效氛围: 添加背景音乐、环境音(如鸟鸣、铃声)和音效(如脚步声)。

- 调色与特效: 统一画面色调,增加光影特效提升质感。

- 字幕与转场: 添加说明性字幕,运用自然转场使视频流畅。

关键考量:E-A-T原则与注意事项

- 专业可信: 推荐成熟可靠工具(如Runway、Pika、HeyGen),阐明技术原理(如“利用扩散模型生成”、“基于深度学习驱动口型”),明确说明当前技术限制(如复杂动作生成可能不够完美)。

- 责任与伦理: 严格遵守平台版权规定,训练数据仅使用自己拥有版权的宠物素材,生成内容避免误导或不当使用,尊重动物形象。

- 用户体验: 提供具体、可操作的步骤(如“准备10-20分钟高清视频片段”、“标注格式:breed_petname_description”),强调高质量输入的重要性。

进阶提示:

- 混合工具: 结合不同工具优势(如用Stable Diffusion + LoRA生成高精度图像,再用Runway制作动画)。

- 社群力量: 积极参与Runway、Stable Diffusion等平台社区,学习最新技巧和参数设置。

- 持续迭代: AI技术日新月异,保持对新工具(如Sora开放后)的关注和学习。

看着亲手训练的AI宠物模型在屏幕里奔跑、说话甚至翱翔天际,这种创造的喜悦难以言喻,技术不再是冰冷的代码,它成为我们记录爱宠、释放想象力的延伸,与其等待完美工具出现,不如现在就开始尝试,每一次训练和生成都是与未来娱乐方式的对话——这过程本身,或许比最终的视频更值得回味。