理解AI模型的核心特点:洞悉智能工具的运作本质

当我们谈论人工智能时,谈论的核心往往是AI模型,这些看不见摸不着的数学构造,正深刻改变着信息处理、决策制定甚至创意表达的边界,要有效利用这项技术,理解其根本特点至关重要,以下是其核心特性的剖析:

-

数据驱动与高度依赖:学习的基石 AI模型并非天生具备知识,其能力完全源于学习过程,如同人类通过经验积累认知,模型通过海量、高质量的数据进行训练,这些数据是模型认识世界、发现规律、构建预测能力的唯一原料,数据的规模、多样性、代表性和清洁度直接决定了模型最终表现的优劣,一个旨在识别医学影像的模型,若训练数据缺乏某些罕见病症的样本,其在该病症上的判断力将显著受限,数据是模型能力的源泉,也是其局限性的起点。

-

模式识别而非本质理解:强大的关联能力 当前主流的AI模型(尤其是深度学习模型)最擅长的是在庞杂数据中发现统计关联、模式和相关性,它们能精准识别图像中的猫、流畅翻译语言、预测用户可能喜欢的商品,其核心能力在于模式匹配与泛化,这种能力与人类的“理解”有本质区别,模型并不真正“懂得”猫的生物特性、语言的深层含义或商品的社会价值;它只是基于历史数据,学习到哪些特征组合(像素模式、词汇序列、用户行为)最可能对应某个结果(“猫”、“法语翻译”、“购买意愿”),这是一种强大的、基于概率的模式识别引擎。

-

概率性输出与不确定性:非确定性决策 绝大多数AI模型的预测或生成结果是概率性的,它们并非给出一个绝对确定的答案,而是计算并输出不同结果的可能性,一个图像分类模型可能判定一张图片有85%的概率是“狗”,10%的概率是“狼”,5%的概率是其他,这种内在的不确定性是其基于统计学习本质的必然体现,理解这一点对于正确解读模型输出、评估其可信度(例如通过置信度分数)和设计容错机制(如人工审核关键决策)非常关键,模型是在表达可能性,而非宣布真理。

-

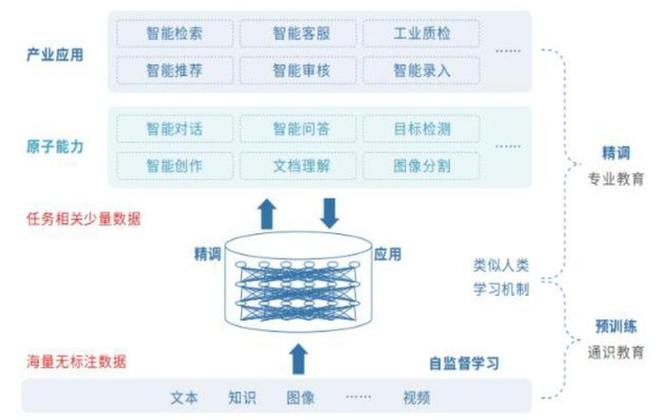

可迁移性与微调潜力:知识的复用 一个在通用领域(如互联网文本)上训练的大型基础模型(如GPT系列、BERT、Stable Diffusion),其学习到的通用表示能力(如语言结构、视觉特征)具有惊人的可迁移性,通过相对少量的特定领域数据(如法律合同、医疗报告、特定艺术风格)对模型进行微调,就能使其快速适应新的专门任务,这大大降低了开发高度专业化AI应用的门槛和成本,体现了模型知识的可塑性和复用价值,OpenAI的GPT系列模型正是这一特点的杰出代表,其强大的通用能力为无数垂直应用提供了基础。

-

持续进化与迭代优化:动态的生命周期 AI模型并非一成不变的静态产物,其性能会随着新数据的引入、算法的改进、超参数的调整(模型训练中的配置选项)以及计算资源的增强而不断提升,模型部署上线后,需要持续的监控其表现(如准确率下降、出现新类型错误),并根据反馈数据进行迭代更新和再训练,以保持其有效性和适应性,这是一个动态的、持续优化的生命周期,谷歌的搜索排名算法或推荐系统模型,都在经历着不间断的细微调整与升级。

对AI模型特点的认知,是驾驭智能时代的起点,它们作为强大的数据驱动工具,以概率方式识别和生成模式,其价值在于可迁移、可优化,我们必须清醒认识到:模型是工具,其输出需要人类智慧的审慎评估与应用。 正是人类对目标的确立、边界的设定、伦理的坚守以及对模型局限性的深刻洞察,才使得AI从冰冷的计算跃升为服务于人类福祉的智慧伙伴,在技术飞速迭代的浪潮中,人类的判断力与价值观始终是把握方向的罗盘。