用AI设计模型建模:从入门到落地的实用指南

人工智能已成为建模领域的革命性力量,它能处理海量数据、识别复杂模式,显著提升建模效率与精度,掌握AI建模的核心流程,已成为工程师、分析师和决策者的必备技能。

第一步:精准定义目标与获取高质量数据

- 明确核心问题: 模型究竟要解决什么问题?是预测销售额、识别图像中的物体、分析用户情感倾向,还是优化生产流程?清晰的目标是建模成功的基石。

- 数据:模型的根基: AI模型的效果极大程度依赖于输入数据的质量,需收集与问题高度相关的数据。

- 来源广泛化: 数据库、传感器、日志文件、公开数据集、API接口等均可作为数据来源。

- 数据预处理:关键中的关键: 此步骤常耗费大量时间,但对最终模型效果至关重要。

- 清洗: 处理缺失值(填充或删除)、修正错误、消除异常值干扰。

- 转换: 将类别数据编码为数值(如独热编码),对数值型数据进行标准化或归一化(如将年龄缩放到0-1范围)。

- 特征工程:发挥创造力: 基于业务理解创造新特征,在电商预测中,可从“购买日期”衍生出“是否周末”、“是否促销季”等更具预测力的特征。

- 探索性分析: 通过统计图表深入理解数据分布、特征间关系及与目标变量的关联,这一步能揭示隐藏规律。

第二步:选择最适合的AI模型

- 匹配问题类型:

- 预测数值结果? 如房价、销量 → 回归模型(线性回归、决策树回归、梯度提升树如XGBoost)。

- 预测分类标签? 如邮件是否垃圾、图像类别 → 分类模型(逻辑回归、支持向量机SVM、随机森林、神经网络)。

- 发现数据内在结构? 如客户细分 → 聚类模型(K-Means、DBSCAN)。

- 处理序列数据? 如文本、语音、时间序列预测 → 循环神经网络RNN、长短期记忆网络LSTM、Transformer。

- 生成新数据或决策? 如创作图像、游戏AI → 生成对抗网络GAN、强化学习模型。

- 考量数据特性与资源: 数据规模、特征维度、可用的计算资源(CPU/GPU/TPU)及训练时间限制都会影响模型选择。

第三步:模型训练与精细调优

- 划分数据集:避免自欺欺人:

- 训练集: 用于模型学习(通常占60-80%)。

- 验证集: 用于在训练过程中调整超参数、选择最佳模型、监控是否过拟合(通常占10-20%)。

- 测试集: 仅在最终评估模型在未知数据上的真实泛化能力时使用一次(通常占10-20%)。千万别跳过这一步!

- 训练:模型的学习过程: 将训练数据输入模型,模型通过特定算法(如梯度下降)不断调整内部参数,以最小化预测值与真实值之间的误差(损失函数)。

- 超参数调优:提升模型上限: 超参数是模型结构或训练过程的设定值(如学习率、树的深度、神经网络层数),不由数据学习得到,常用方法:

- 网格搜索: 遍历指定参数组合。

- 随机搜索: 在参数空间中随机采样。

- 贝叶斯优化: 更智能地选择下一个待评估参数点。

- 核心评估指标:

- 分类任务: 准确率、精确率、召回率、F1分数、AUC-ROC曲线。

- 回归任务: 均方误差、平均绝对误差、决定系数。

- 务必在验证集和测试集上评估! 训练集上的优异表现可能只是过拟合的假象。

第四步:模型部署与持续生命管理

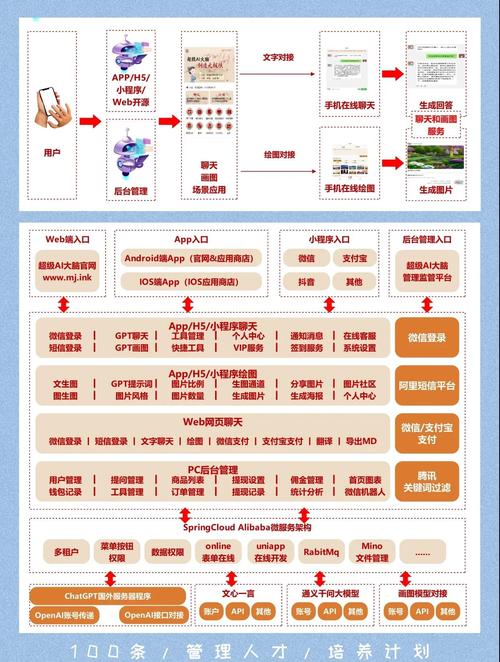

- 部署上线:模型投入实际应用:

- 将训练好的模型封装为API服务、集成到应用程序或嵌入到边缘设备中。

- 常用工具:TensorFlow Serving、TorchServe、ONNX Runtime、云平台AI服务(AWS SageMaker, Google AI Platform, Azure ML)。

- 持续监控与维护:模型不是一劳永逸:

- 性能监控: 实时跟踪模型在生产环境中的预测准确性、延迟等指标。

- 数据漂移检测: 监控输入数据的分布是否随时间发生显著变化,导致模型失效。

- 模型再训练与更新: 当性能下降或数据发生显著漂移时,需使用新数据重新训练或更新模型版本,建立自动化流水线是关键。

关键挑战与应对之道

- 数据质量与数量: “垃圾进,垃圾出”,投入资源确保数据清洁、相关且充足,数据不足时可考虑数据增强或迁移学习。

- 过拟合与欠拟合:

- 过拟合: 模型在训练集上表现极好,但在新数据上表现糟糕(死记硬背),对策:增加数据量、简化模型复杂度、加入正则化、使用Dropout、早停法。

- 欠拟合: 模型在训练集和新数据上都表现不佳(学习能力不足),对策:增加模型复杂度、添加更多有效特征、减少正则化强度、延长训练时间。

- 模型可解释性: 某些复杂模型(如深度神经网络)常被视为“黑箱”,在医疗、金融等高风险领域,模型决策的透明性至关重要,可尝试使用SHAP、LIME等解释工具,或优先选择可解释性强的模型(如决策树)。

- 计算资源需求: 训练大型模型需强大算力,合理利用GPU/TPU加速、云平台资源、模型压缩技术(如剪枝、量化)。

- 伦理与偏见: AI模型可能无意中放大训练数据中的偏见,需主动检测和缓解偏见,确保模型应用的公平性、透明性和问责制。

提升建模效率的AI工具

- 自动化机器学习: Google AutoML、H2O.ai Driverless AI、Azure AutoML 能自动化特征工程、模型选择和调优过程,大幅降低门槛。

- 低代码/无代码平台: DataRobot、Akkio 提供可视化界面,使业务分析师也能构建基础模型。

- 强大开发框架: TensorFlow、PyTorch 是构建和训练定制化模型的首选工具库。

- 集成开发环境: Jupyter Notebook、VS Code 提供交互式编程和数据可视化支持。

- 云平台: AWS、GCP、Azure 提供从数据存储、处理到模型训练、部署、监控的一站式服务。

成功的核心:人机协作

AI是强大的工具,但无法替代人的智慧,领域专家的知识对于理解业务问题、定义目标、解读数据、设计有效特征、评估结果意义至关重要,数据科学家和工程师则负责技术实现与优化,AI建模的卓越成果,源于业务理解、数据洞察与先进技术的深度融合,模型建立后,持续的评估、迭代优化,以及对模型在生产环境中实际表现的监控,决定了其长期价值。

AI设计模型建模是一个迭代探索的过程,需要实践、耐心和对细节的关注,理解基本原理,善用强大工具,结合领域专长,你将能有效利用AI构建出解决实际难题、创造真正价值的智能模型,技术服务于人,深刻理解业务场景和用户需求,才是建模工作的真正起点与归宿。

---由网站站长基于多年技术实践与行业观察撰写,力求提供实用、可靠的方法论指引,文中涉及的流程与工具均经过实际项目验证,旨在帮助读者规避常见陷阱,提升建模效率与效果。