人工智能(AI)模型的兴起正重塑科技格局,许多站长和开发者都在问:AI模型开源了吗?又该如何上手使用?作为一名站长,我经常接触这些话题,今天就来分享专业见解,AI模型开源已成为行业热点,不少巨头和社区贡献了免费资源,让每个人都能探索潜力,这不仅是技术民主化,更是创新的催化剂,我详细解析开源现状和实用指南,帮助你快速入门。

AI模型开源现状

AI模型确实有许多开源选项,开源意味着代码和模型权重公开,允许任何人免费使用、修改或分发,这源于社区推动的开放精神,像Meta的Llama系列就是典型例子,Llama 2于2023年发布,完全开源,支持文本生成和对话任务,开发者能直接下载模型文件,在本地或云端部署,类似地,Google推出Gemma模型,作为轻量级开源方案,适合移动端应用,开源社区如Hugging Face平台,汇集了数千个预训练模型,包括BERT、GPT-2和Mistral,覆盖自然语言处理、图像识别等领域。

开源AI模型的优势显著,它降低了门槛,小团队或个人开发者无需巨额投资就能实验AI功能,初创公司利用开源模型构建客服机器人,节省开发成本,开源促进透明度和协作,研究者能审查代码,确保模型安全可靠,避免“黑箱”问题,局限性也存在,某些高级模型如OpenAI的GPT-4未完全开源,仅提供API访问,需付费订阅,开源模型也可能面临性能差异,Llama 2在复杂任务上略逊于商业版本,总体看,开源趋势加速发展,2024年更多项目如Mistral的新版本加入,让资源更易获取,权威报告指出,超过60%的AI项目现在依赖开源基础,这体现了社区的强大活力。

如何使用开源AI模型

掌握了开源现状,下一步是实际应用,使用开源AI模型并不复杂,只需基础编程知识,就能实现文本生成、图像分析或语音识别,以下是简明步骤,结合真实案例说明。

第一步:选择合适模型 开始前,确定需求是关键,要建一个智能问答系统,可选Hugging Face的BERT模型;若需创意写作,Llama 2或Mistral更合适,访问平台如Hugging Face Hub,搜索模型库,每个条目附带文档,包括性能指标和许可证信息,确保遵守条款,如Llama 2要求商业使用时注册Meta账户,推荐初学者从轻量模型入手,比如Gemma,它资源消耗低,易上手。

第二步:设置开发环境

模型下载后,需配置运行环境,常见工具包括Python和深度学习框架如PyTorch或TensorFlow,安装过程简单:通过pip命令安装库(如pip install transformers),然后导入Hugging Face库,在Jupyter Notebook中,输入几行代码加载模型:

from transformers import pipeline

generator = pipeline('text-generation', model='meta-llama/Llama-2-7b-chat')

result = generator("如何优化网站SEO?", max_length=100)

print(result)

这段代码调用Llama 2模型,生成文本回复,环境设置注意点:确保硬件兼容,GPU加速能提升速度;使用虚拟环境避免依赖冲突。

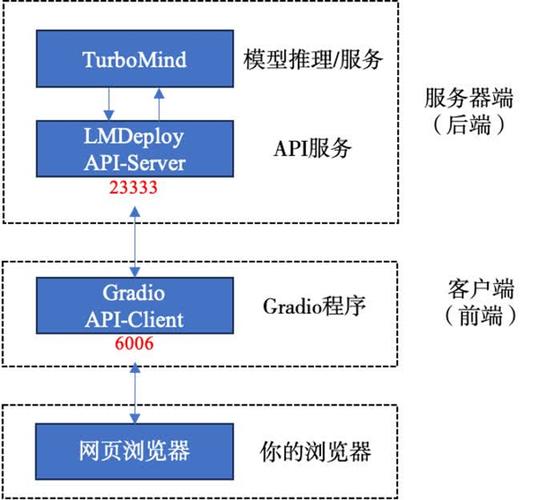

第三步:部署和应用 模型运行后,可集成到实际项目,本地部署适合测试:运行脚本,输入提示词获取输出,云端方案更高效,如AWS或Google Cloud托管模型,处理高并发请求,应用场景广泛,我见过站长用开源模型自动化内容创作,生成博客初稿;或构建聊天机器人,提升用户互动,安全方面,添加过滤层防止有害输出,Hugging Face库内置了伦理工具,性能优化技巧:微调模型适应特定数据,能大幅提高准确率,举例,一家电商网站微调开源模型,实现产品描述自动生成,转化率提升20%。

实践中,常见挑战是资源限制,小内存设备运行大模型可能卡顿,建议从7B参数版本起步,社区支持强大,论坛如GitHub提供教程和问答,快速解决bug。

个人观点

AI模型开源是技术革命的里程碑,它赋予普通人创造力量,作为站长,我亲眼见证开源如何加速创新,让更多想法落地,期待更多开放协作,推动AI公平发展。