在数字化浪潮席卷全球的今天,人工智能语言模型已不再是遥不可及的黑科技,而是逐步融入日常生活的实用工具,尤其本地AI语言模型,它直接在个人电脑或设备上运行,无需依赖云端服务器,为用户带来隐私保护、数据安全和高可控性,作为网站站长,我亲身体验过这类模型的强大潜力,并目睹其如何帮助用户提升工作效率、激发创意,本文将以专业视角,一步步引导你掌握本地AI语言模型的使用方法,强调其实际应用和潜在价值,掌握这项技术的关键在于实践——多试多用,才能发掘其真正威力。

理解本地AI语言模型的核心概念至关重要,它本质上是一种在本地设备上部署的AI系统,基于大型语言模型(如GPT系列或开源替代品),通过本地计算处理用户输入,生成文本输出,与云端模型不同,它完全运行于你的硬件中,数据不出设备,避免了隐私泄露风险,这种设计特别适合处理敏感信息,比如企业机密或个人日记,要开始使用,你需要满足基本硬件条件:一台性能较好的计算机,配备至少8GB RAM和一块支持CUDA的NVIDIA显卡(如RTX系列),以高效处理模型计算,软件方面,开源框架如Hugging Face的Transformers库或Ollama平台是理想起点,它们提供预训练模型和简化安装流程。

进入安装和设置阶段,这个过程相对直接,但需细心操作,第一步,下载模型文件:访问可信源如Hugging Face Hub,选择适合的模型(Meta的Llama 2或Mistral的开源版本),确保模型大小匹配你的设备存储(通常5-20GB),安装必要环境:使用Python包管理器pip安装库,如transformers和torch,在命令行中运行简单指令,即可完成配置,以Windows系统为例,打开命令提示符,输入“pip install transformers torch”,再加载模型脚本,初次运行时,模型会下载权重文件,这可能需要几分钟到几小时,取决于网速,完成后,你就能在本地环境中启动模型——输入一个Python脚本,调用API发送提示,瞬间获得响应,一个基础脚本示例:导入库,定义模型,输入“帮我写一封商务邮件”,模型便输出专业草稿,整个设置过程强调自主控制,无需注册外部服务,大大降低门槛。

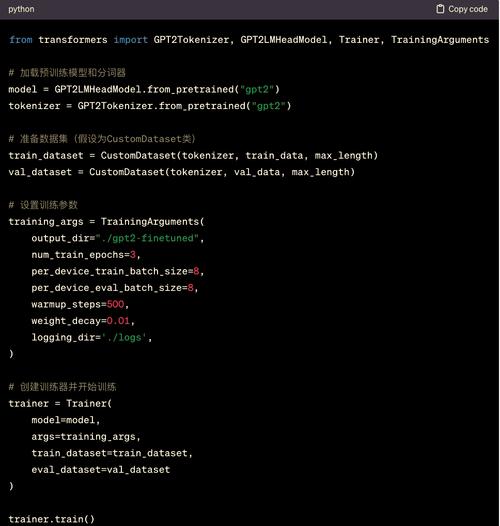

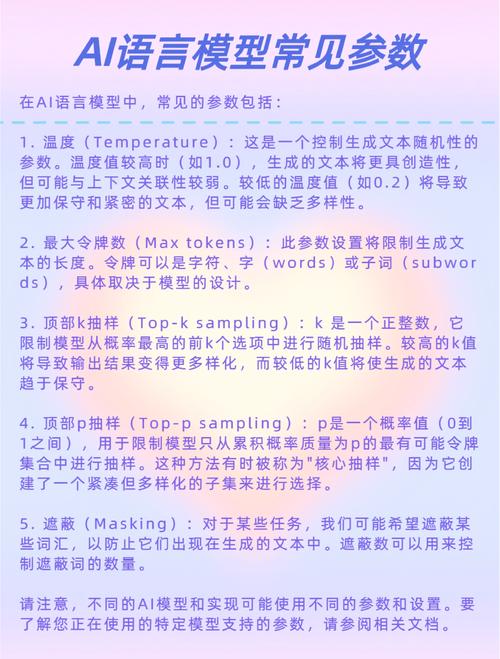

掌握了基础,如何高效使用本地AI模型?关键在于“提示工程”——设计清晰、具体的输入指令,模型输出质量高度依赖提示的精准度,起步时,从简单任务入手:比如写作辅助,输入“生成一篇关于环保的短文,字数200字”,模型会输出流畅内容;或用于编程,输入“用Python写一个计算器函数”,代码立刻生成,进阶用法包括微调模型:如果你有特定数据集(如公司文档),可通过本地工具进行微调,让模型更贴合需求,这涉及训练脚本调整,但开源社区教程丰富,容易上手,实际应用中,本地模型展现出广泛场景:内容创作者用它起草文章、优化SEO;开发者调试代码、生成文档;学生辅助学习、快速查询知识点,我曾在个人项目中用它分析数据集,节省数小时手动劳动——这种效率提升是革命性的。

安全性考量不可忽视,本地模型的优势在于数据本地化,但需注意设备防护,确保操作系统更新,安装防病毒软件,避免模型文件被恶意修改,模型输出有时可能偏差,使用时需人工审核,生成内容要验证事实准确性,防止误导,开源社区提供资源帮助你优化模型行为,如添加伦理约束,从长远看,本地AI模型代表技术民主化趋势,赋予用户更大掌控力,而非依赖外部巨头。

展望未来,本地AI语言模型将加速普及,硬件进步如更高效的芯片会降低门槛,让更多人受益,我认为,这不仅是工具进化,更是个人赋能的机会——学会使用它,你就能在AI时代占据主动,释放无限创意,拥抱变化,开始你的本地AI之旅吧。(字数约1050字)