谷歌AI画图模型导入指南:释放创意潜能的钥匙

在人工智能驱动创作的时代,谷歌推出的先进AI画图模型(如Imagen、Parti等)正成为设计师、艺术家和创意工作者的强大伙伴,这些模型能将简单的文字描述转化为令人惊叹的视觉图像,掌握如何导入并运行这些模型,意味着您手中握有一把开启无限创意可能的钥匙,本文将提供清晰、实用的导入操作指南。

核心前提:环境搭建与资源准备

成功导入谷歌AI画图模型,首先需要奠定坚实的技术基础:

-

强大的计算环境:

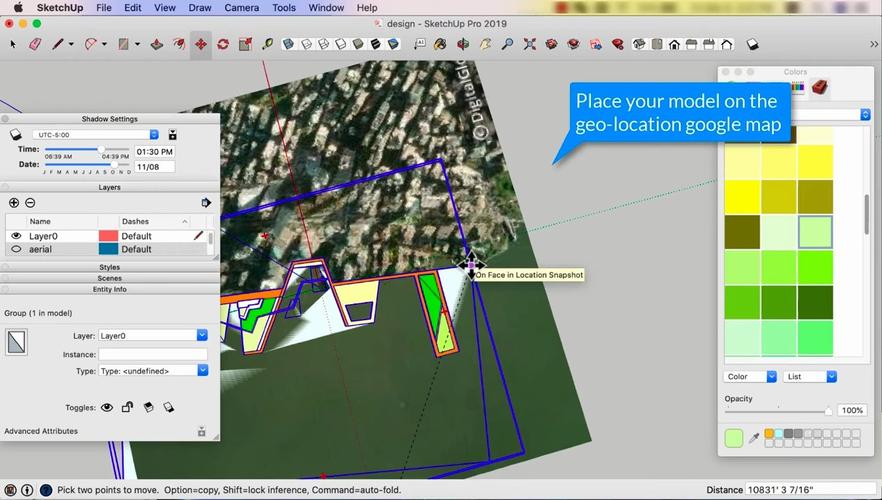

- GPU是关键: 模型训练与推理极度依赖高性能GPU,NVIDIA显卡(如RTX 3090、A100等)并安装最新CUDA驱动是主流选择,云平台(Google Colab Pro, AWS, GCP)提供按需GPU租赁是灵活方案。

- 充足显存: 大型模型运行时需要大量显存(通常8GB以上是基础,16GB或更高更佳),务必确认硬件或云实例满足要求。

- 操作系统: Linux(如Ubuntu)是首选,Windows(配合WSL)或macOS(M系列芯片性能优异)也可行。

-

软件栈安装:

- Python环境: 安装Python 3.8+,强烈建议使用

conda或venv创建独立虚拟环境避免依赖冲突。 - 深度学习框架: 谷歌模型通常基于JAX或TensorFlow,通过

pip install jax jaxlib(根据CUDA/cuDNN版本选择jaxlib)或pip install tensorflow安装。 - 必备库: 安装

numpy,pillow(图像处理),transformers(Hugging Face模型库),flax(常与JAX搭配) 等常用库。

- Python环境: 安装Python 3.8+,强烈建议使用

-

模型获取:

- 官方途径(首选):

- TensorFlow Hub: 部分谷歌模型(如早期Imagen变体)发布于此,查找模型页面获取使用代码片段。

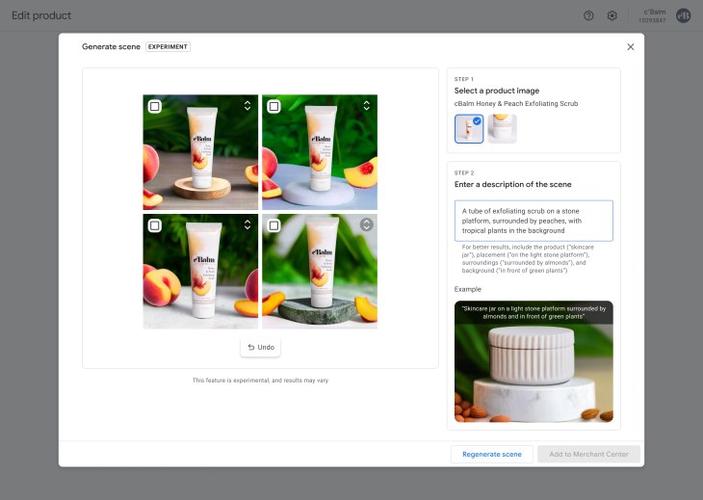

- Hugging Face Model Hub: 成为模型分发的核心平台,搜索模型名称(如“google/imagen”, “google/parti”)获取模型卡片、代码示例和下载链接。

- GitHub代码库: 关注谷歌AI或DeepMind官方GitHub仓库(如

google-research组织下项目),获取最新模型代码、权重和详细文档。

- 重要提示: 务必遵守模型发布的许可证协议(如Apache 2.0, CC-BY等),明确商用、修改等权限限制。

- 官方途径(首选):

分步导入:让模型运转起来

假设我们通过Hugging Face Hub获取一个谷歌图像生成模型(以概念性流程为例):

-

安装Hugging Face库:

pip install transformers diffusers # diffusers库常用于扩散模型

-

导入必要模块:

from transformers import pipeline # 或具体模型类(如AutoModelForXXX, AutoTokenizer) from diffusers import StableDiffusionPipeline # 假设是扩散模型 import torch # 如果底层是PyTorch

-

加载模型与组件:

# 示例1:使用Hugging Face pipeline (若模型支持) # 替换 "google/model-name" 为实际模型ID image_generator = pipeline("text-to-image", model="google/model-name", device=0) # device=0 指定使用GPU # 示例2:使用diffusers库 (适用于Imagen类扩散模型) # 可能需要特定谷歌模型适配器 pipe = StableDiffusionPipeline.from_pretrained( "google/model-name", revision="fp16", # 可选,使用半精度节省显存 torch_dtype=torch.float16, use_auth_token=True # 如果模型需要认证(如gated model) ) pipe = pipe.to("cuda") # 移动到GPU -

执行推理(生成图像):

# 使用pipeline示例 prompt = "一幅宁静的山水画,远处有雪山,近处有湖泊和松树,中国风,水墨效果" generated_images = image_generator(prompt, num_images=2) # 生成2张图 # 使用diffusers pipeline示例 image = pipe(prompt, height=512, width=768, num_inference_steps=50).images[0] # 指定尺寸和生成步数 image.save("generated_landscape.png")

关键注意事项与优化技巧

- 版本兼容性: 严格对照模型文档要求的库版本(transformers, diffusers, tensorflow/jax, torch等),版本不匹配是常见错误源头。

- 显存管理: 大模型极易耗尽显存,可尝试:

- 降低生成图像分辨率 (

height,width)。 - 使用半精度 (

torch.float16/fp16)。 - 启用梯度检查点 (

model.enable_gradient_checkpointing())。 - 减少单次生成图像数量 (

num_images/batch_size)。

- 降低生成图像分辨率 (

- 模型理解: 研究模型特性,不同模型对提示词(Prompt)格式、长度、风格词的响应差异巨大,学习优秀提示词工程技巧能显著提升生成质量。

- 安全与伦理: 生成内容需符合法律法规与伦理道德,避免生成侵权、有害或歧视性内容,谷歌模型通常内置安全过滤器,但用户仍需负责。

- 性能监控: 使用工具(如

nvidia-smi)监控GPU使用率、温度和显存占用,及时调整参数。 - 云平台利用: 本地资源不足时,Google Colab(免费或Pro)提供预装环境的Jupyter Notebook和GPU资源,是极佳起点,云服务商(AWS SageMaker, GCP AI Platform)提供更强大稳定的托管环境。

个人观点

谷歌AI画图模型代表了文本到图像合成领域的前沿水平,成功导入并运行它们,只是探索旅程的第一步,这个过程本身——从环境搭建到参数调试——需要技术耐心和不断尝试的精神,真正的价值在于我们如何运用这些工具,将脑海中的想象转化为视觉现实,突破传统创作的边界,技术始终服务于人,当艺术家与工程师共同探索AI画板的可能性时,最激动人心的作品往往诞生于人与智能的深度协作中,开放模型资源的价值,正在于让更多人能接触并参与到这场创意革命之中。

具体模型名称(如google/imagen)和导入代码需根据您实际选择的、谷歌公开发布并允许访问的模型进行调整,操作前务必查阅该模型官方文档获取最准确指导。