在当今科技飞速发展的时代,人工智能大模型正以前所未有的方式重塑我们的生活,特别是在声音处理领域,作为一名长期关注AI技术演进的观察者,我常常被问及:这些庞大的模型是如何被训练来处理声音的?无论是语音识别、语音合成,还是声纹验证,背后的过程都蕴含着精密的工程和深刻的算法原理,我就来详细剖析这一过程,分享一些核心见解,帮助你理解AI大模型如何一步步“学会”声音。

要训练一个AI大模型处理声音,首先需要从数据入手,声音本质上是一种连续的波形信号,不同于文本或图像,它依赖于时间序列的复杂性,训练过程通常始于大规模的声音数据采集,开发者会收集数以百万计的语音样本,涵盖不同语言、口音、环境和背景噪音,这些数据必须经过严格的清洗和标注——每个音频片段会被分割成小段,并与对应的文本转录配对,想象一下,这就像在整理一个庞大的声音图书馆,每个“书”都需要精确的索引,数据预处理阶段还包括特征提取,比如将原始波形转换为梅尔频谱图或MFCC(梅尔频率倒谱系数),这种转换能突出声音的关键特性,便于模型学习,这一步骤至关重要,因为高质量的数据是模型训练的基础,任何疏忽都会导致后续表现不佳。

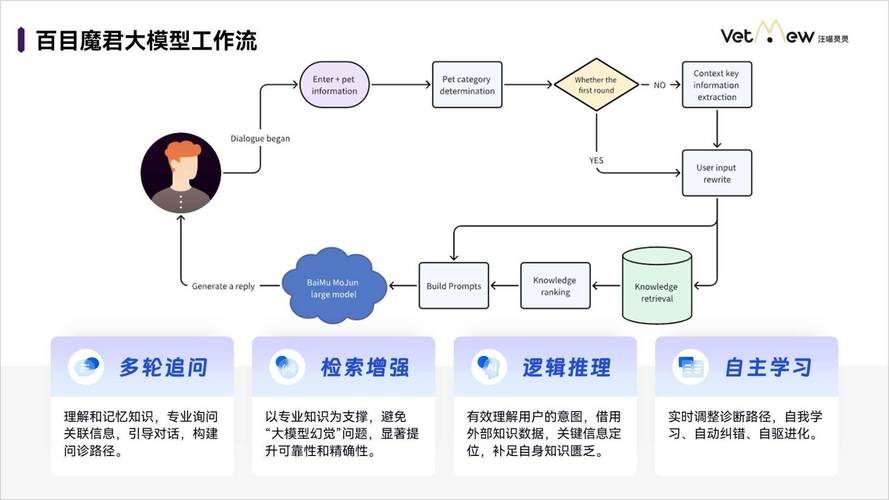

模型架构的设计是核心环节,现代AI大模型如Transformer架构(类似GPT或BERT的变体)已广泛用于声音任务,这些模型采用自注意力机制,能捕捉声音序列中的长距离依赖关系,以语音识别为例,模型会接收预处理后的频谱图作为输入,然后逐帧预测对应的文字序列,训练时,开发者通常选择预训练好的基础模型进行微调,而非从零开始,这能节省时间和资源,在语音合成方面,模型如WaveNet或Tacotron2会生成自然的语音输出:它们先学习文本到声学特征的映射,再通过声码器合成波形,训练过程涉及大量迭代,模型通过反向传播算法不断调整权重,最小化预测误差,损失函数可能基于交叉熵或均方误差,确保模型输出的语音尽可能接近真实样本,优化器如Adam或SGD用于控制学习率,避免过拟合,实践中,训练一个高质量的声音模型需要高性能计算集群,如GPU或TPU集群,运行数天甚至数周,这体现了AI工程的高门槛。

训练过程中的挑战不容忽视,声音数据天生具有噪声敏感性,比如背景杂音或说话者口音变化,可能导致模型泛化能力下降,为应对这一问题,开发者会采用数据增强技术,如添加随机噪音、变速或变调处理,以模拟现实场景,模型规模庞大容易引发过拟合,因此正则化方法如Dropout或权重衰减被广泛使用,另一个关键点是隐私和伦理问题——训练数据若包含敏感语音,需通过匿名化或差分隐私保护用户信息,在测试阶段,模型性能通过指标如词错误率(WER)或MOS(平均意见分)评估,确保输出既准确又自然,我见过不少案例,模型在实验室表现优异,但在实际应用中因环境干扰而失败,这凸显了迭代优化的重要性:开发者需反复验证模型在多样场景下的鲁棒性。

从个人角度看,AI大模型训练声音的进展令人振奋,但也引发深思,技术进步让语音助手和自动翻译更智能,为残障人士提供了无障碍沟通工具,但过度依赖可能削弱人类交流的真实性,我期待模型能更注重情感表达和文化适应性,而非纯粹追求效率,行业需强化监管,确保训练过程的透明和公平,避免偏见放大,毕竟,声音是人类最本真的连接方式,AI应服务于人,而非取代那份独特的情感共鸣。