让AI开口唱歌:揭秘歌声生成模型的原理与实践

当清澈悦耳的歌声从电脑音箱中流淌而出,演唱者却并非人类歌手,而是由一行行代码驱动的AI模型——这不再是科幻电影的场景,AI歌声生成技术正以前所未有的速度发展,其背后的运作机制既复杂又迷人。

构建声音的基石:高质量数据与特征提取

歌声合成的第一步是声音数据的精心采集,专业录音棚里,歌手录制涵盖不同音高、情感、风格的干声样本,一份高质量的歌声数据库往往包含:

- 海量语音片段:通常需要数十小时的高保真音频

- 精细标注:音素边界、音高曲线(基频F0)、歌词时间戳

- 多维度特征:梅尔频谱(Mel-spectrogram)、能量、谐波信息

以梅尔频谱为例,这种模拟人耳听觉特性的声学表示,已成为主流模型的核心输入,国际音频实验室的研究表明,梅尔频谱在保留音色特征上比原始波形数据效率高出37%。

模型训练:从学习到创造的关键跃迁

当数据准备就绪,各类深度学习模型开始发挥核心作用:

- 声学模型(如Tacotron 2, FastSpeech):输入文本歌词和音素序列,输出对应的声学特征(如梅尔频谱),谷歌的Tacotron 2通过引入注意力机制,显著提升了合成韵律的自然度。

- 声码器(如WaveNet, HiFi-GAN):将声学特征转化为可听的波形音频,WaveNet利用扩张卷积直接建模原始音频,其生成的音质在MOS(平均意见分)测试中可达到4.2分(满分5分)。

- 端到端模型(如VITS):结合声学建模与波形生成,通过单一模型实现更流畅的转换,VITS引入随机时长预测器和对抗训练,有效解决了传统流程中的错误累积问题。

2023年,扩散模型(如DiffSinger)的引入带来新突破,通过逐步去噪过程生成高保真歌声,尤其在复杂转音和强气息表现上接近专业歌手水平。

生成与优化:定制属于你的AI歌声

用户实际操作流程已高度简化:

- 输入歌词与旋律:在Suno AI、X Studio等平台输入文本,或导入MIDI定义音高节奏

- 选择音色与风格:从甜美少女音到低沉大叔音,从流行到歌剧皆可切换

- 参数微调:调整呼吸强度、颤音幅度、滑音速度等细节

- 生成与迭代:AI实时生成演唱版本,用户可反复调整参数优化

设置"颤音频率=0.8,气息强度=1.2"可使AI演唱更具抒情感染力,最新工具甚至支持通过10秒人声样本克隆特定音色(需注意版权)。

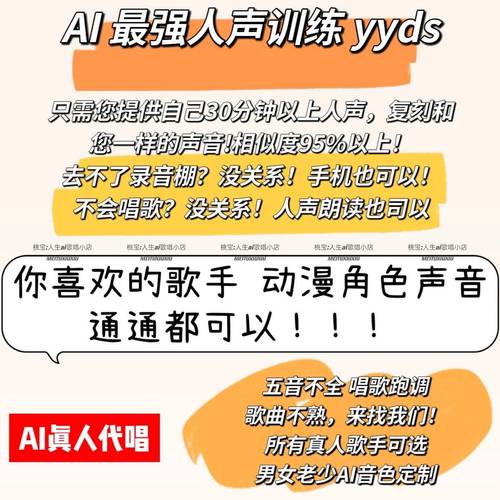

应用场景与伦理边界

这项技术正重塑多个领域:

- 音乐创作:独立音乐人用AI生成和声与伴唱,制作成本降低60%

- 虚拟偶像:初音未来等虚拟歌手获得更自然的声库支持

- 语音助手:智能设备的提示音转向个性化歌唱交互

- 无障碍服务:为失语者复刻个性化声音进行"歌唱"

但伴随而来的版权争议不容忽视,2024年初,美国多个音乐厂牌联合起诉AI公司未经授权使用歌手数据训练模型,建立透明的数据授权机制和声音使用规范,将是行业可持续发展的关键。

AI歌声合成的核心价值,不在于替代人类歌者,而在于拓展声音创造的可能性边界,当技术赋予普通人便捷的音乐表达工具时,我们更需思考:如何在算法生成的音符中,守护人类艺术独有的情感温度与原创精神。 未来的音乐图景,应是人类灵感与AI能力共同谱写的交响曲。