AI歌手训练指南:从零打造你的数字歌者

想象一下,只需一段你的语音片段,就能生成媲美专业歌手的演唱——这不是科幻,而是AI歌声合成技术创造的现实,从初音未来的电子音到近乎以假乱真的明星AI翻唱,技术正飞速进化,如何训练属于自己的AI唱歌模型?

基石:高质量数据决定成败 训练AI歌手的第一步,如同为人类歌手挑选曲目,关键在于数据质量,你需要为模型准备充足的“学习资料”:

- 纯净人声素材: 收集目标歌手或你自己的干声演唱录音(无伴奏),时长建议在1小时以上,覆盖高中低不同音域,录音环境需安静,麦克风质量不能妥协——底噪、喷麦声或模糊发音会严重影响模型学习效果。

- 精准文本标注: 每句歌词需精确对应音频时间戳(音素对齐),专业工具如Montreal Forced Aligner能自动完成,但人工细致校对必不可少。

- 数据预处理: 使用开源工具(如Spleeter)彻底剥离伴奏;标准化音量;切除空白与杂音片段,这一步耗时,却是模型纯净输出的保障。

关键提示: 训练数据若涉及他人声音,务必获得明确授权,未经许可使用他人声音素材存在严重法律与伦理风险。

模型选择:匹配需求的技术核心 根据目标效果与硬件条件选择合适的模型架构至关重要:

- Diff-SVC(扩散模型): 当前顶尖音质代表,擅长捕捉细腻情感与复杂音色变化,尤其在人声音色转换上表现出色,但对算力要求极高,训练周期长。

- So-VITS-SVC(软聚类+变分推理): 在音质与效率间取得平衡,所需数据量相对较少,训练速度较快,适合快速验证或资源有限的情况,声音自然度略逊于Diff-SVC。

- RVC(实时语音转换): 专为实时场景优化,延迟极低,虽在极致音质上稍弱,但满足直播、实时互动等需求优势明显。

- 基础TTS模型(如VITS): 直接从头生成歌声,不依赖源音色,灵活性高,但训练复杂,对数据质量和规模要求极为苛刻。

实战训练:精细调优的艺术 选定模型后,进入核心训练阶段:

- 环境部署: 配置Python环境,安装PyTorch等深度学习框架,从GitHub获取模型官方代码库(如so-vits-svc-fork, DiffSinger)。

- 数据喂入与特征提取: 预处理后的音频被转换为模型可理解的数字特征(常用梅尔频谱图),文本标注则转化为音素序列。

- 超参数设置: 这是训练效果的“调控阀”,需合理设置:

- 学习率: 过大导致模型“学飞”,过小则进展缓慢。

- 批次大小(Batch Size): 受限于GPU显存,影响训练稳定性。

- 训练轮数(Epochs): 不足则欠拟合,过多易过拟合(模型“死记硬背”训练数据,丧失泛化能力)。

- 训练监控与调整: 使用TensorBoard等工具实时观察损失值下降曲线,当验证集损失不再明显下降或开始上升,意味着过拟合,应及时停止训练或调整策略。

- 音高(Pitch)引导: 歌声的灵魂在于精准的音高,训练时需提供额外音高信息(常用F0值),模型才能学会在正确音调上演唱,工具如CREPE可提取高精度F0。

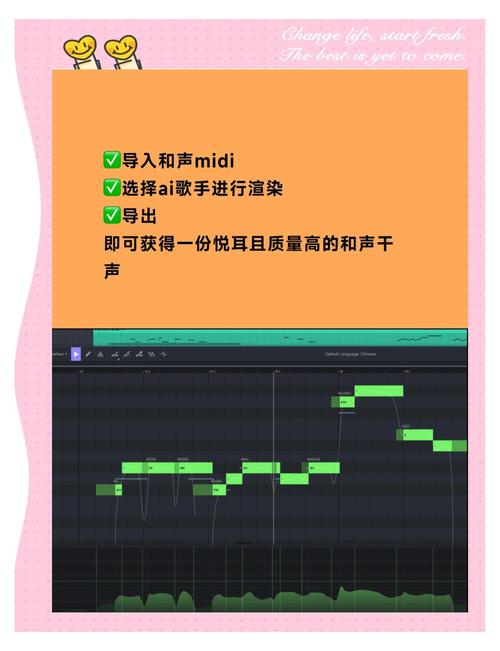

推理合成:让AI开口演唱 训练完成的模型需通过推理生成歌声:

- 输入准备: 提供目标干声音频(你想转换的音源)和对应歌词文本/音素序列。

- 参数调节: 关键操作:

- 音高比例因子: 微调转换后歌声的音高,适应不同歌曲要求。

- 音素时长: 控制每个字发音长短,影响节奏感。

- 检索特征占比(如So-VITS): 调整合成时参考原始训练音色特征的强度,平衡保真度与自然度。

- 生成与后处理: 模型输出梅尔频谱,经声码器(如HiFi-GAN)还原为波形音频,最后将AI人声与伴奏混合。

提升效果的实用技巧

- 数据增强: 对原始音频进行轻微变速、变调或添加可控噪声,能提升模型鲁棒性。

- 过拟合应对: 若模型只擅长“模仿”训练数据中的片段,需增加数据多样性、使用Dropout层、或提前停止训练。

- 爆音/卡顿处理: 检查原始干声质量、音高提取准确性,或适当降低推理参数强度。

AI歌声合成技术正以前所未有的速度发展,从实验室走向大众创作工具,它并非意在替代人类歌者独特的灵魂与即兴火花,而是为音乐创作开启了一扇新的大门——让个性化声音表达变得触手可及,为灵感插上技术的翅膀,无论是音乐人探索新声线,还是爱好者体验创作乐趣,训练自己的AI歌手已成为这个时代赋予我们的全新可能。