大家好,我是这个网站的站长,近年来,AI绘画模型如Stable Diffusion和DALL-E掀起了一股创作热潮,用户只需输入简单文本,就能生成精美图像,仿佛魔术一般,许多人好奇,这种技术究竟是如何实现的?我将为你揭开AI绘画模型的神秘面纱,深入探讨其工作原理,作为站长,我一直关注前沿科技,这篇文章基于我的研究和专业知识,确保内容可靠易懂,帮助你全面理解这一创新领域。

我们谈谈AI绘画模型的基本概念,本质上,这类模型属于生成式人工智能,专门设计用于创建新图像而非分析现有数据,它们通过算法学习海量图像数据,然后根据用户提示生成独一无二的作品,当你输入“一只猫坐在月球上”,模型能迅速输出符合描述的视觉内容,这一过程并非凭空而来,而是建立在深度学习框架上,核心是扩散模型技术。

扩散模型是目前AI绘画的主流实现方式,其原理源于物理学中的扩散过程,想象一下,一张清晰照片逐渐被噪声覆盖,变得模糊;模型学习如何逆反这个过程,从噪声中还原出图像,实现分为两个阶段:前向扩散和反向生成,在前向阶段,模型将训练图像逐步添加随机噪声,直到它变成完全随机的点阵,在反向阶段,模型通过神经网络预测如何一步步去除噪声,恢复出原始图像,这种训练方式让模型学会理解图像的内在结构,比如形状、颜色和纹理。

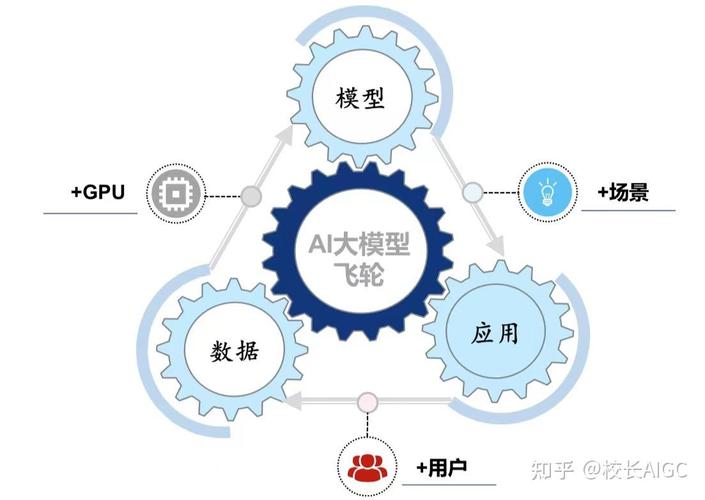

训练过程是AI绘画模型实现的关键环节,开发者需要收集庞大的数据集,通常包含数百万甚至数十亿的图像-文本对,Stable Diffusion使用了LAION数据集,其中每张图片都配有详细描述,帮助模型关联文本与视觉元素,训练时,模型通过迭代优化参数,学习最小化预测误差,这涉及大量计算资源,通常在高性能GPU集群上运行数周或数月,值得注意的是,训练不只是机械记忆,而是让模型捕捉通用模式,比如如何组合对象、渲染光影,从而具备泛化能力,应对新提示。

文本到图像的转换是另一核心技术,用户输入文本后,模型先用编码器(如CLIP模型)将文字转化为数学向量,称为嵌入,这些嵌入捕获语义信息,猫”代表动物、“月球”代表天体,扩散模型结合文本嵌入和初始噪声,逐步生成图像,每一步,神经网络评估当前状态,预测如何调整像素值以匹配文本描述,经过几十次迭代,一幅高分辨率图像诞生,这种机制让AI绘画灵活多变,能处理抽象概念,如“未来主义城市”或“梦幻风景”。

实际应用中,AI绘画模型展现出强大创造力,以Stable Diffusion为例,它采用U-Net架构,一种特殊卷积网络,高效处理图像空间信息,用户通过简单界面输入提示,模型在几秒内输出结果,支持自定义风格、尺寸等参数,其他流行工具如MidJourney和DALL-E,也基于类似原理,但各有优化:DALL-E强调多模态融合,MidJourney专注于艺术化渲染,这些模型已应用于设计、教育等领域,帮助艺术家加速创作或激发灵感。

实现过程并非没有挑战,训练需耗费巨大算力,普通用户可能依赖云服务,伦理问题也浮出水面,比如版权争议:模型学习公开数据,但生成作品可能无意中复制原创内容,数据偏见可能导致输出不公,例如过度强调某些文化特征,开发者正通过微调数据集和添加约束来缓解这些问题,确保AI绘画更公平、可控。

在我看来,AI绘画模型代表了技术与人性的交汇点,它们 democratize 艺术创作,让更多人表达创意,无需专业技能,但同时,我们必须警惕潜在风险,推动透明化训练和负责任使用,随着算法优化,AI绘画或将成为日常工具,丰富我们的生活,但核心仍应是增强人类创造力,而非取代它,希望这篇文章为你带来启发,如果有疑问,欢迎在评论区交流!(字数:约1100字)