AI模型训练实战指南:从数据到精通的进阶之路

想要构建一个真正“懂你”的AI模型?这绝非上传数据、点击按钮就能实现的魔法,作为深度参与多个工业级模型研发的实践者,我深知培养一个优秀AI模型如同雕琢一件精密仪器,需要扎实的方法和持续投入,以下是经过验证的核心路径:

第一步:数据工程 - 模型能力的基石

- 精准定义需求: 明确模型需完成的具体任务(如图像识别、文本生成),目标模糊会导致数据收集方向错误。

- 构建高质量数据集: 数据质量决定模型上限,需投入大量时间清洗(去除噪声、错误标注)、标注(确保一致性)及增强(如旋转图片、替换文本同义词),一个优质的10万条标注数据集,价值远超千万条杂乱数据。

- 划分与平衡: 严格区隔训练集(70%)、验证集(15%)、测试集(15%),验证集用于超参数调整,测试集仅用于最终评估,警惕类别不平衡,可通过过采样少数类或调整损失函数解决。

第二步:模型架构 - 为任务选择最佳工具

- 匹配任务特性: 图像识别首选CNN(如ResNet),序列处理(文本、语音)依赖RNN或Transformer,生成任务考虑GAN或扩散模型,勿盲目追求最新复杂架构,适用是关键。

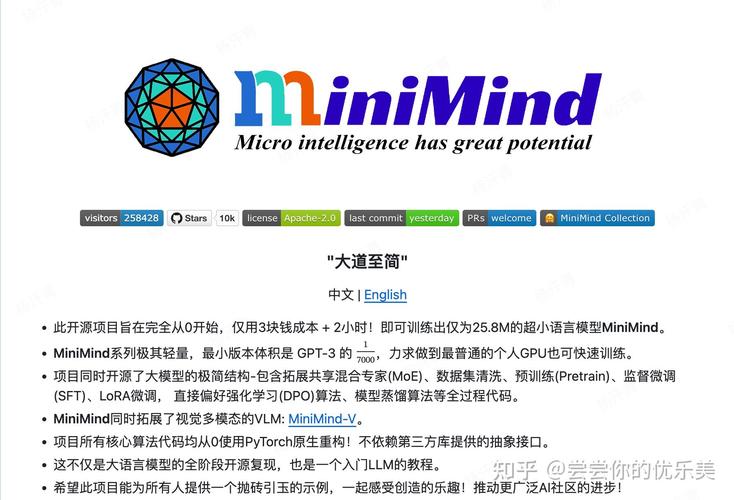

- 迁移学习加速: 利用预训练模型(如BERT、GPT、ResNet)作为起点,仅需微调顶层即可适应新任务,大幅节省算力和时间,基于预训练BERT微调情感分析模型,效果常优于从零训练。

第三步:模型训练 - 优化与调参的艺术

- 超参数寻优: 学习率是最关键参数之一,采用学习率预热(初始低学习率)配合余弦退火策略常获显著效果,批量大小(Batch Size)影响收敛速度与稳定性,自动化工具(如Optuna、Ray Tune)可高效探索超参数空间。

- 优化器选择: Adam及其变体(AdamW)因其自适应学习率成为通用选择,特定场景下SGD配合动量项可能收敛至更优解。

- 正则化防过拟合: 除Dropout外,权重衰减(L2正则化)、早停法(监控验证集性能停止训练)、数据增强均是核心手段。

第四步:评估迭代 - 持续优化的闭环

- 超越单一指标: 分类任务需综合准确率、精确率、召回率、F1值及AUC-ROC曲线,生成模型需人工评估结合BLEU、ROUGE等自动指标。

- 深度错误分析: 细致检查模型在验证集/测试集的错误案例,是特定类别识别差?还是复杂背景干扰?这些洞见直接指导数据补充或结构调整。

- 持续迭代: 根据分析结果,针对性增加困难样本数据、调整模型结构(如增加特定模块注意力)、优化损失函数或训练策略,这是一个持续实验、验证、改进的过程。

实战进阶技巧:

- 混合精度训练: 使用FP16/BF16精度,结合梯度缩放,可在几乎不影响精度前提下显著加速训练并减少显存占用。

- 分布式训练: 数据并行(多卡)、模型并行(超大模型切分)是处理海量数据和参数量级的必备技术。

- 高效微调: 参数高效微调技术(如LoRA、Adapter)仅训练少量额外参数,即可使大模型适配新任务,成本效益极高。

个人实践洞察:

培养AI模型,是科学严谨性与工程创造力的融合,它要求开发者既是细心的“数据工匠”,又是善于解决问题的“模型医生”,每一次针对性的数据清洗、每一次有效的超参数调整、每一次深度的错误分析,都在为模型注入更强的理解力和适应力,这个过程没有捷径,但有章可循,最有效的学习永远始于动手实践——从明确一个小目标开始,精心准备数据,选择合适的模型架构,耐心调试训练,再基于评估结果持续迭代优化,在反复试错与验证中积累的直觉和经验,才是最宝贵的专业资产,开始动手吧,你的第一个模型正在等待被唤醒。