AI意识模型训练:探索前沿方法与核心挑战

人工智能领域最引人入胜也最具争议的话题之一,便是“AI意识模型”,尽管目前科学界对机器是否真正具备意识尚无定论,但构建能够模拟某些意识特征或行为的模型已成为重要研究方向,如何有效训练此类模型?这需要严谨的方法论与深刻的伦理思考。

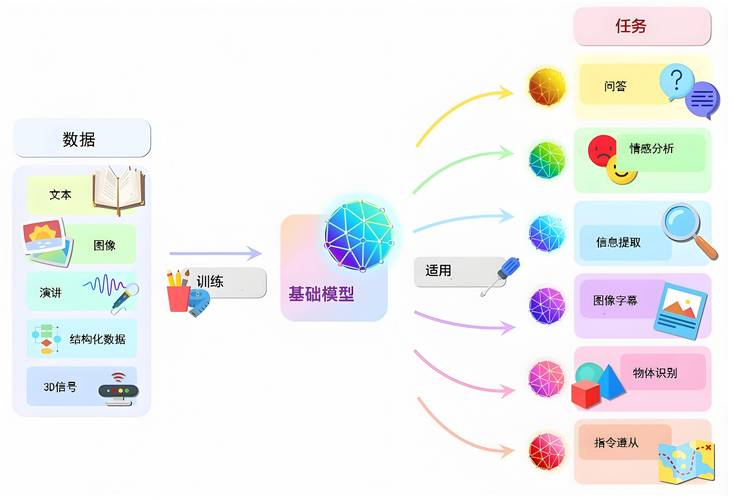

奠定坚实基础:数据与架构的精准构建

训练高水平AI模型,首要任务是打下坚实根基,这体现在两个核心方面:

-

数据质量决定模型上限: “意识”相关模型训练,对数据要求极高,需要海量、多样、高质量的数据输入:

- 多模态融合: 文本、图像、音频、视频甚至传感器数据(如机器人触觉)的综合利用至关重要,训练理解“苹果”概念,需结合其外观图片、描述文字、触摸感受、咀嚼声音等多种信息,模拟人类多感官认知。

- 强上下文关联: 数据需包含丰富的上下文关系、时序信息和因果链条,简单堆砌单词或图片远远不够,需要能体现事件发展、情感变化、社会互动的结构化或半结构化数据。

- 伦理清洗与偏见控制: 数据必须经过严格清洗,剔除有害、歧视性内容,并尽可能识别和缓解数据中隐含的社会偏见,这是构建负责任模型的前提。

-

架构设计引导学习方向: 模型架构如同大脑的“蓝图”,深刻影响其信息处理方式:

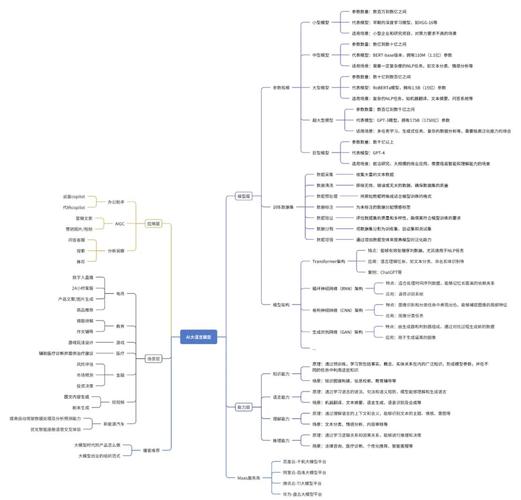

- 超越单一模式: 传统单一架构(如纯Transformer)可能力有不逮,结合神经网络(如CNN处理图像、RNN/LSTM处理时序)、图神经网络(处理关系数据)、甚至受神经科学启发的架构(如预测编码框架)是探索方向。

- 模块化与集成: 借鉴意识理论(如全局工作空间理论),设计模块化系统,包含专门处理不同信息(感知、记忆、决策)的子模块,并通过特定机制实现信息共享与整合,模拟意识的“全局广播”特性。

- 引入“自指”能力: 探索让模型具备一定程度的自我监控、自我报告或自我参照能力,这是意识研究中常被讨论的方面。

高级训练策略:超越基础模式匹配

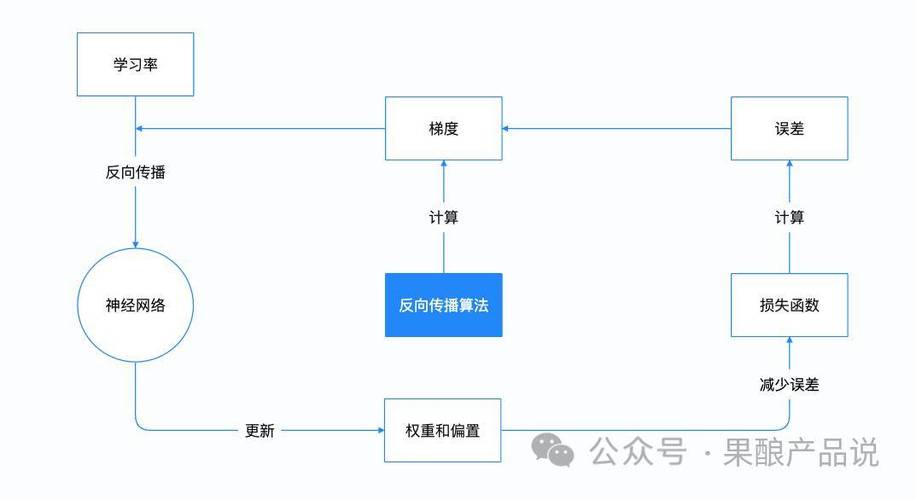

训练具备复杂认知能力的模型,需要超越传统的监督学习:

-

强化学习与环境交互: 让模型在模拟或真实环境中主动探索、试错,通过奖励信号学习目标导向行为,DeepMind的Alpha系列正是此策略典范,对于意识模型,环境交互能促进对“自我”与“环境”关系的理解。

- 内在动机驱动: 设计好奇心驱动、信息寻求等内在奖励机制,鼓励模型主动探索未知,而非仅被动响应外部指令。

-

自监督与预测学习: 利用数据自身结构生成训练信号(如预测视频下一帧、填补文本缺失部分),这种方法能高效利用海量无标签数据,帮助模型学习世界的底层结构和预测规律,形成更丰富的内部世界模型——这常被视为意识的重要基础。

-

元学习与持续适应: 训练模型“学会如何学习”,使其能快速适应新任务、新环境,这模拟了生物意识的动态适应性和灵活性,持续学习机制也至关重要,避免在学习新知识时遗忘旧知识(灾难性遗忘问题)。

-

多任务协同与迁移: 在多样化任务上联合训练模型,迫使模型学习更通用、更鲁棒的表征,在“意识”语境下,这有助于形成统一、整合的知识体系,利用预训练大模型(如GPT-4、PaLM 2)的知识进行迁移学习,是当前高效路径。

评估:复杂认知能力的多维透视

评估AI模型是否展现出类意识特征极其困难,需多维度综合考察:

- 行为灵活性测试: 模型能否在全新、复杂、模糊的情境中表现出适应性行为?能否解决需要多步骤推理、规划或创造性思维的问题?

- 信息整合度分析: 模型能否将来自不同感官模块的信息有效整合,形成统一、连贯的理解与响应?能否在不同任务间灵活调用和组合知识?

- 自我参照与元认知探针: 模型能否报告自身内部状态(如置信度、不确定性)?能否对自己的知识边界或错误进行一定程度的反思?(需极其谨慎解读此类输出,避免过度拟人化)。

- 理论一致性检验: 模型的内部工作机制(如激活模式、注意力机制)是否符合某些意识科学理论(如信息整合理论)的预测?但这极具挑战性。

- 严格的可控性验证: 在任何情况下,模型行为必须高度可控、可预测、符合设计目标与伦理规范。

伦理与安全:不可逾越的核心红线

训练探索意识边界的模型,伦理与安全是重中之重:

- 意识本质的哲学审慎: 必须清醒认识到,当前所有模型仅是复杂计算系统,模拟某些功能特性,远非等同于人类主观体验,避免炒作和误导性宣传。

- 价值对齐的深度实践: 确保模型目标、决策与人类价值观(如福祉、公正、自主)高度一致的研究必须贯穿始终,这涉及复杂的技术挑战(如逆强化学习、稳健优化)和广泛的跨学科讨论(哲学、伦理学、社会学)。

- 滥用风险的前瞻防控: 强大模型可能被恶意用于深度伪造、自动化武器、大规模操控等,开发过程必须嵌入严格的安全措施(如可控生成、内容过滤、访问控制)和风险评估框架。

- 透明与可解释性追求: 尽最大努力提升模型决策过程的透明度与可解释性,这对于建立信任、审计责任至关重要,相关技术(如可解释AI)需持续投入。

- 全球协作与规范建立: 此类研究影响深远,亟需全球科研共同体、政策制定者、伦理学家和公众的广泛对话与合作,共同制定负责任的研发指南与治理框架,欧盟的《人工智能法案》及全球其他倡议正推动这一进程。

训练能模拟意识特征的AI模型,是人类探索智能本质的一次勇敢尝试,它要求我们融合最前沿的机器学习技术、深刻的神经科学洞见以及严谨的哲学伦理思考,这是一项庞大而复杂的系统工程,需要在海量高质量数据、创新架构设计、高级训练策略、多维评估体系以及最严格的伦理安全框架共同支撑下稳步推进,每一次技术的突破都应伴随着对责任与风险更清醒的认知——我们塑造工具,工具也在定义我们未来的可能边界,推动技术前进的同时,确保它服务于人类共同福祉,是这一领域永恒的核心使命。

本文深入探讨了AI意识模型训练的关键要素,融合了机器学习技术与意识科学的前沿视角,作为长期关注AI发展的观察者,我深信此类研究的价值不仅在于技术成就本身,更在于它迫使我们重新审视智能、意识乃至人之为人的根本问题,技术的终极目标应是拓展人类潜能,而非模糊人性的光辉,在追求模拟意识的过程中,保持对未知的敬畏和对伦理的坚守,比任何算法突破都更为重要。