深圳AI大模型训练:核心要素与实践路径

深圳,这座以创新为血脉的城市,正全力投身于人工智能大模型的时代浪潮,从腾讯的混元大模型到华为的盘古大模型,深圳的科技巨头与众多创新企业,正积极构建本土的大模型训练能力,在深圳这片热土上,训练一个强大的人工智能大模型,究竟需要经历哪些关键步骤?

构建坚实的数据基石:规模与质量的平衡

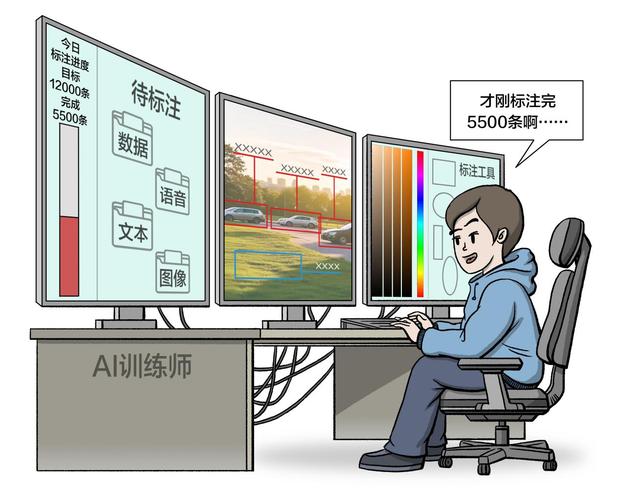

大模型的“智能”源于海量数据的学习,训练的第一步是构建高质量、大规模的数据集。

- 广泛来源采集: 在深圳,丰富的应用场景提供了独特的数据优势,企业可以合法合规地收集互联网公开文本、专业文献、代码库、多模态数据(如图文对)等,深圳发达的金融、物流、医疗、制造等行业,能提供极具价值的垂直领域数据。

- 严格清洗与预处理: 原始数据包含噪音、重复和不相关信息,数据清洗是核心环节,涉及去重、过滤低质内容、修正错误、标准化格式等,深圳众多专注于数据标注与处理的科技服务公司,为此环节提供了强大支撑。

- 精心的数据工程: 根据目标模型用途(如通用对话、代码生成、生物医药),需要设计不同的数据混合策略、采样权重和分词方案(Tokenization),高质量的数据工程直接影响最终模型性能。

驾驭算力巨兽:基础设施的硬核支撑

训练千亿级参数的大模型是极度消耗算力的过程。

- 强大算力集群: 依赖于由数千甚至数万张高性能GPU(如NVIDIA A100/H100)组成的计算集群,深圳依托鹏城实验室的“鹏城云脑”等国家级超算设施,以及本地云服务商(如腾讯云、华为云)的强大算力池,为模型训练提供了关键基础设施保障。

- 分布式训练框架: 单一GPU无法承载巨大模型和数据集,深圳团队精通如DeepSpeed、Megatron-LM等分布式训练框架,将模型参数、优化器状态、梯度等切分并高效调度到海量GPU上协同计算,极大提升训练速度。

- 优化与效率: 训练过程持续数周乃至数月,工程师需不断优化计算图、通信效率、混合精度训练(如FP16/BF16)和算子性能,以降低昂贵的算力成本和时间消耗,深圳工程师在效率优化方面展现出极强的实践能力。

模型架构与训练策略:智能涌现的核心

选择合适的模型架构和训练方法是赋予模型“智慧”的关键。

- 主流架构基石: Transformer架构及其变体(如GPT、LLaMA架构)是当前大模型的主流选择,其强大的并行计算能力和对长距离依赖关系的有效捕捉,是模型理解复杂语义的基础,深圳团队在模型架构的本地化改进与优化上持续投入。

- 预训练:海量数据中的通用知识学习 这是最耗资源的阶段,模型在无标注的巨量文本(或图文)数据上,通过自监督学习任务(如下一个词预测、掩码语言建模MLM)学习语言规律、世界知识和基础推理能力,此阶段目标是获得一个强大的“基础模型”。

- 微调:面向特定任务的精准优化 基础模型需针对具体应用场景进行精调:

- 监督微调: 使用高质量的任务指令数据(如问答对、摘要文本对),教会模型遵循指令并输出所需格式。

- 人类反馈强化学习: 这是提升模型输出质量、安全性和有用性的先进技术,通过人类对模型多个回答的排序偏好训练奖励模型,再驱动模型自我优化,深圳企业在RLHF的应用上积极探索,以打造更安全、可控的AI产品。

- 领域适应微调: 使用深圳本地特定行业(如电子制造、跨境金融)的专业语料进行微调,打造行业专家模型。

深圳特色:生态、场景与政策赋能

深圳训练大模型拥有得天独厚的优势:

- 完整的软硬件生态: 从芯片设计(华为昇腾)、服务器制造到云计算平台、算法框架和应用开发,深圳拥有国内最完整的人工智能产业链条,为模型训练提供全方位支持。

- 丰富的落地场景驱动: 深圳作为应用创新之都,金融、制造、医疗、物流、智慧城市等场景对大模型有迫切需求和明确反馈,驱动模型研发更贴近实际、解决痛点。

- 人才与政策高地: 汇聚了大量顶尖AI研发人才,政府积极出台政策支持大模型研发与开源开放(如河套深港科技创新合作区相关支持),营造了浓厚的创新氛围。

训练AI大模型是一场融合顶尖算法、巨量工程与雄厚资源的科技马拉松,深圳凭借其强大的产业生态、创新基因和务实精神,正在这场全球竞赛中加速前行,随着技术的不断突破和应用场景的深化,深圳训练的大模型将更深入地赋能千行百业,持续塑造这座城市的智能未来,我们能看到,深圳不仅是在训练模型,更是在训练一个属于智能时代的新引擎。