在人工智能项目开发过程中,将地图数据有效导入模型是一个常见且关键的技术环节,无论是用于路径规划、区域分析,还是空间预测等任务,正确的地图数据处理方法直接影响模型的准确性与实用性,以下将系统介绍常用的地图数据导入方法及注意事项,帮助开发者和研究者更高效地完成这一过程。

地图数据通常以矢量或栅格格式存在,常见矢量格式包括 Shapefile(.shp)、GeoJSON、KML 等,它们以点、线、面的形式存储地理要素;栅格数据则如 TIFF、GeoTIFF 等,以像素矩阵记录地表信息,在选择数据时,需明确项目需求:是分析道路网络、建筑物分布,还是处理卫星影像?清晰的目标有助于选择合适的原始数据。

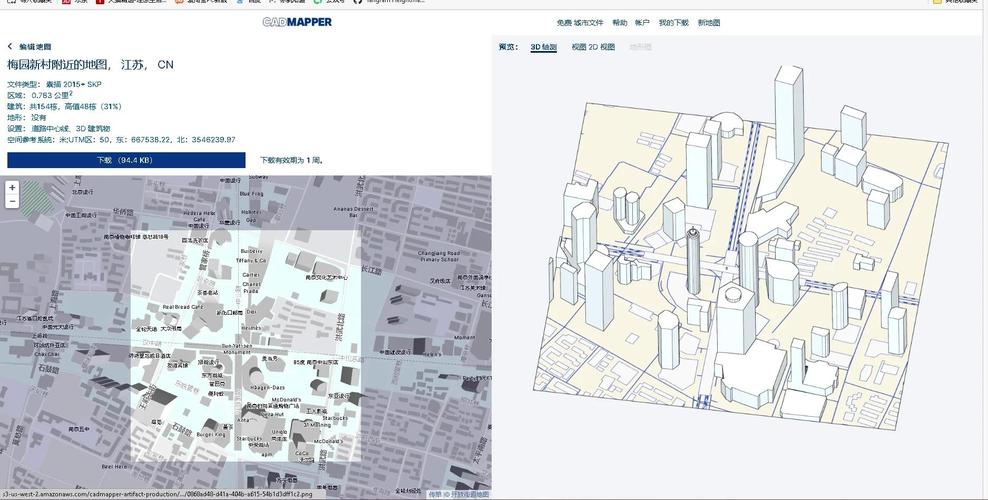

数据预处理是导入前的必要步骤,原始地图数据往往包含冗余信息或不符合模型输入要求,需进行清洗、转换和统一坐标系统,使用 QGIS、ArcGIS 等工具可过滤无关属性、修复几何错误,或将数据转换为模型支持的格式,若数据来源多样,还需进行坐标系统一(如转换为 WGS84 或 UTM),避免空间错位。

对于矢量数据,一种常见方法是通过编程库直接读取并转换为模型可处理的结构,在 Python 环境中,Geopandas 库可高效加载 Shapefile 或 GeoJSON,并将其转换为 DataFrame 形式,便于后续特征提取,Shapely 库可处理几何操作,如计算面积、长度或空间关系,若模型需输入拓扑网络(如路网),可使用 OSMnx 工具从 OpenStreetMap 获取数据,并转换为网络图结构(如 NetworkX 对象),进而用于图神经网络或路径分析模型。

栅格数据的处理则侧重像素级操作,借助 Rasterio 或 GDAL 库,可读取 GeoTIFF 等文件,提取像素值及地理元数据(如分辨率、边界坐标),对于深度学习任务,常将栅格数据裁剪为固定尺寸的切片,并转换为 NumPy 数组或 Tensor 格式,需注意保留地理参考信息,以确保输出结果可映射回实际空间。

导入过程中,数据标准化与增强同样重要,地图数据可能具有不同的数值范围(如高程值、像素亮度),需进行归一化以提升模型训练稳定性,通过旋转、平移或色彩调整等方式增强数据,可提升模型的泛化能力,但需确保增强操作不破坏空间关系。

空间索引技术能显著提升大数据量下的处理效率,使用 R-tree 索引加速空间查询,或借助空间数据库(如 PostGIS)管理数据,按需加载区域子集,这对处理高分辨率卫星影像或大规模矢量数据尤为关键。

验证导入结果也不可忽视,可通过可视化对比原始数据与模型输入,检查坐标对齐、属性完整性及几何准确性,常见工具如 Matplotlib、Folium 等可快速生成预览图,帮助发现异常。

在实践时,还需考虑计算资源与模型兼容性,大规模地图数据可能占用大量内存,需采用分块加载或流式处理策略,不同深度学习框架(如 TensorFlow、PyTorch)对地理数据处理的支持度各异,有时需自定义数据加载逻辑。

从技术演进角度看,地图数据与AI模型的融合正变得更加紧密,新兴工具如 PyTorch Geometric 已支持直接处理图结构空间数据,而云端地理平台(如 Google Earth Engine)也提供了与AI工作流集成的接口,这些进展正逐步降低技术门槛,但核心原则不变:理解数据本质、确保空间一致性、保持迭代验证。

个人认为,成功导入地图数据的关键在于细致的前期设计和持续调试,每个项目的数据基础和目标均有差异,盲目套用流程往往导致效果不佳,开发者应深入理解地理信息系统的基本原理,结合模型需求灵活调整方法,方能在复杂场景中取得可靠成果。