在人工智能技术快速发展的今天,越来越多的人开始尝试训练自己的AI模型,无论是用于图像识别、风格迁移还是生成艺术,一个常见且关键的环节,就是如何正确地为模型导入图片数据,这一步骤虽然基础,却直接影响最终模型的性能与效果。

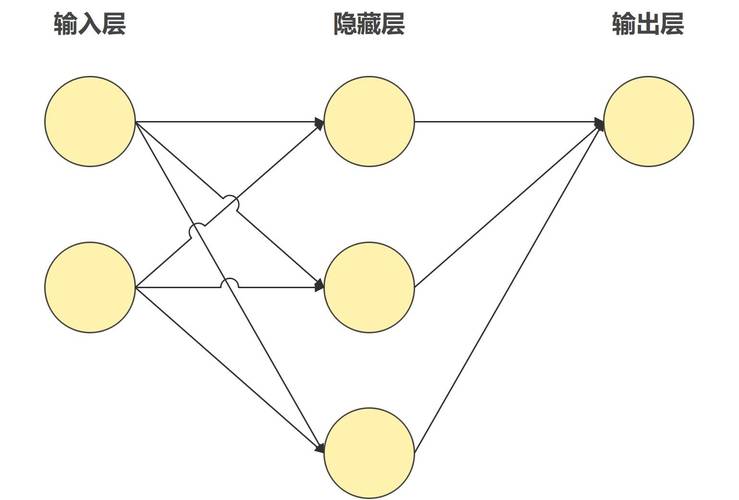

首先需要明确,AI模型并不直接“看懂”图片,它们处理的是数值,每一张图片在计算机中都是以像素矩阵的形式存储的,对于模型而言,这就是一个多维的数字数组,所谓“导入模型图片”,实质上是将图片文件读取、转换为规范化的数值张量,并送入模型进行推理或训练的过程。

第一步:数据准备与目录结构

在开始导入之前,良好的数据组织是成功的一半,我们会将图片数据划分为几个集合,最常见的是“训练集”和“验证集”,训练集用于模型学习,验证集用于在训练过程中评估模型性能,防止过拟合。

一个清晰规范的目录结构至关重要,你可以这样组织你的图像数据:

project/

├── data/

│ ├── train/

│ │ ├── class_1/

│ │ │ ├── image1.jpg

│ │ │ └── image2.jpg

│ │ └── class_2/

│ │ ├── image1.jpg

│ │ └── image2.jpg

│ └── validation/

│ ├── class_1/

│ └── class_2/这种按类别分文件夹存放的方式,被许多现代深度学习框架(如TensorFlow的ImageDataGenerator)所支持,能极大简化数据导入流程。

第二步:选择工具与库

根据你使用的深度学习框架,导入图像的方法略有不同,但核心原理相通,以下是一些主流工具的处理方式:

-

TensorFlow / Keras: 对于入门者和快速开发,Keras提供了极其便捷的工具,你可以使用

tf.keras.preprocessing.image.ImageDataGenerator类及其flow_from_directory方法,这个方法能自动从上述结构的目录中读取图片,并进行实时数据增强(如旋转、缩放)、归一化(将像素值缩放到0-1之间)和批次生成。 示例代码核心思想:train_datagen = ImageDataGenerator(rescale=1./255) train_generator = train_datagen.flow_from_directory( 'data/train', target_size=(150, 150), # 统一图像尺寸 batch_size=32, class_mode='binary' # 根据任务选择 )之后,你可以直接将

train_generator传递给模型的fit方法。 -

PyTorch: PyTorch提供了更灵活的数据处理模块

torchvision,你需要自定义一个数据集类,通常继承自torch.utils.data.Dataset,并在其中实现__len__和__getitem__方法,在__getitem__方法中,你会使用PIL.Image.open()或torchvision.io.read_image来读取图片,然后进行必要的转换(Transform)。 转换过程通常使用torchvision.transforms.Compose将多个步骤串联起来,例如调整大小、转换为张量、归一化等。 示例代码核心思想:from torchvision import transforms transform = transforms.Compose([ transforms.Resize(256), transforms.CenterCrop(224), transforms.ToTensor(), transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]), ]) # 在自定义Dataset的__getitem__方法中: image = Image.open(path) image = transform(image) return image, label使用

DataLoader来打包数据并生成批次。 -

其他库(如OpenCV): 如果你使用OpenCV等进行推理,流程类似:使用

cv2.imread()读取图片,它会返回一个NumPy数组(BGR格式),然后你需要手动进行尺寸调整、颜色通道转换(BGR to RGB)、归一化等预处理操作,最终将其转换为模型需要的输入维度。

第三步:关键的预处理操作

无论使用哪种工具,以下几个预处理步骤几乎必不可少:

- 调整尺寸(Resizing): 模型的全连接层或卷积层通常要求输入固定尺寸的图片(如224x224),必须将所有输入图像统一调整到这个尺寸。

- 归一化(Normalization): 将像素值从0-255的整数范围缩放到一个较小的区间,通常是[0, 1]或[-1, 1],有时也会使用数据集的均值和标准差进行标准化,这一步能加速模型收敛,提升训练稳定性。

- 数据增强(Data Augmentation): 特别是在训练数据不足时,通过对训练集图片进行随机旋转、翻转、裁剪、亮度调整等操作,可以凭空创造更多的“新”数据,有效提升模型的泛化能力,防止过拟合,验证集通常不进行数据增强。

需要注意的常见问题

- 颜色通道: 不同库读取图片的默认颜色通道顺序可能不同(OpenCV是BGR,PIL和Matplotlib是RGB),务必确保输入模型的张量通道顺序与模型训练时一致,否则会导致严重的性能下降。

- 数据格式: 确保张量的维度顺序符合框架要求,例如PyTorch通常是

[Batch, Channels, Height, Width],而TensorFlow有时是[Batch, Height, Width, Channels]。 - 内存管理: 对于非常大的数据集,一次性将所有图片读入内存是不可行的,应使用上述生成器或迭代器的方式,按需批量加载数据,这是高效训练大规模模型的关键。

为AI模型导入图片是一个将现实世界的视觉信息转化为模型可理解数值的桥梁,这个过程要求严谨和细致,从数据源的规范整理,到预处理管道的有序构建,每一步都需认真对待,一个高质量、流程清晰的数据输入 pipeline,是模型最终能否达到预期效果的重要基石,值得投入时间和精力去精心设计和优化。