在人工智能技术不断渗透到各个领域的今天,AI自瞄作为计算机视觉与实时决策结合的典型应用,受到广泛关注,其核心在于通过机器学习模型实现对目标的自动识别与追踪,而实现这一功能的关键步骤,正是模型的高效训练与部署运行。

理解AI自瞄的工作原理,首先需从模型构建的基本流程入手,整个过程大致分为数据准备、模型选择与训练、优化部署及实时推理几个阶段。

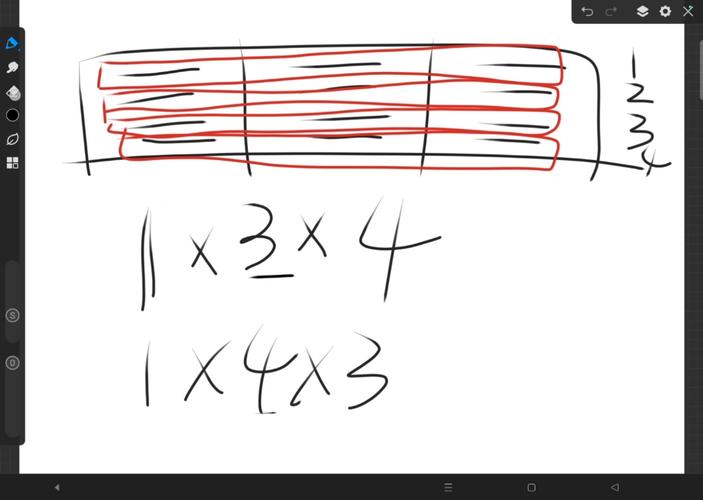

数据准备是模型训练的基石,针对自瞄任务,需要大量包含各类目标的图像或视频数据,例如在游戏场景中,可能是不同角色、武器、姿态和环境光照下的截图,这些数据必须经过精确标注,通常使用边界框标出目标位置,标注质量直接决定模型上限,需保证标注一致性和高精度,数据增强技术也常被应用——通过旋转、缩放、调整亮度等方式扩展数据集规模,提升模型泛化能力。

接下来是模型选择,当前主流采用基于卷积神经网络(CNN)的目标检测架构,例如YOLO(You Only Look Once)或SSD(Single Shot MultiBox Detector),这类单阶段检测器在速度与精度之间取得较好平衡,适合实时要求高的场景,选定模型结构后,需在标注好的数据上进行训练,训练过程中,通过反向传播算法不断调整网络权重,使模型输出逐步逼近真实标注,损失函数的选择至关重要,常用于目标检测的包括交叉熵损失与定位误差的结合。

训练阶段需消耗大量计算资源,通常依托GPU集群进行,迭代次数、学习率、批大小等超参数需反复调试,以避免过拟合或欠拟合,训练完成后,模型在验证集上评估性能,常用指标包括mAP(平均精度均值),若效果未达预期,需回溯调整数据或模型结构,重新训练。

模型优化与部署是将其投入实际应用的关键环节,训练好的模型往往存在参数量大、推理速度慢的问题,难以直接用于实时自瞄,需通过模型剪枝、量化、知识蒸馏等技术进行压缩优化,在尽量保持精度前提下降低计算开销,之后,将模型转换为适合高效推理的格式,如ONNX或TensorRT,并部署到终端设备上。

最终环节是实时推理,在运行环境中,模型接收来自摄像头的视频流,逐帧处理图像,输出目标位置信息,并结合自瞄策略完成自动瞄准,这一过程要求极低的延迟与高稳定性,任何性能抖动都可能影响用户体验。

从技术角度看,跑通一个AI自瞄模型是一项系统工程,涵盖数据处理、模型构建、训练优化及落地部署多个环节,每个环节都需要扎实的机器学习知识和工程实践经验,值得注意的是,自瞄技术本身具有争议性,尤其在游戏等竞技场景中,可能涉及公平性与合规性问题,相关开发与使用必须严格遵守法律法规与平台规则,避免用于破坏公平秩序的场景。

技术的进步始终伴随责任,作为开发者或技术爱好者,我们更应关注如何将这类能力用于正途,例如安防监控、辅助医疗或自动化生产,真正为社会创造价值。