面对市场上层出不穷的AI大模型,许多个人开发者和企业都希望将其部署到自己的环境中,以构建独特的应用或进行内部研究,设置过程可能涉及多个环节,对非专业人士构成一定门槛,本文将为您梳理设置AI大模型的核心步骤与关键考量。

第一步:明确目标与需求

在开始任何技术操作之前,清晰的定义是成功的基石,您需要问自己几个问题:我打算用这个模型做什么?是进行文本生成、代码编写、图片识别还是语音合成?我的用户群体是谁?预期的响应速度(延迟)和并发处理能力是多少?对这些问题的回答,将直接决定您后续在模型选择、硬件配置和部署策略上的决策。

第二步:选择合适的模型

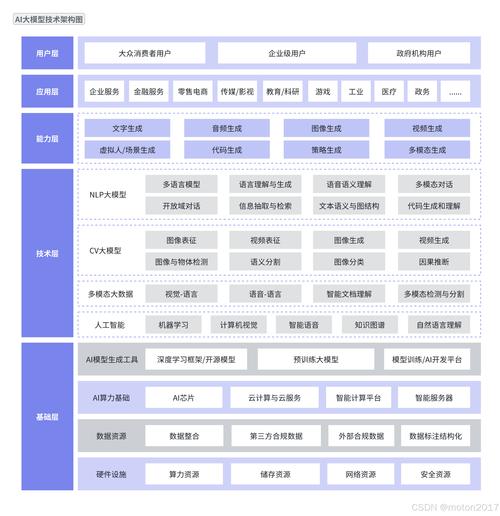

当前,AI模型生态极为丰富,有开源与闭源之分,也有通用与专用之别。

- 开源模型:如 Llama、ChatGLM、Bloom 等,选择开源模型的优势在于拥有完全的掌控权,可以自行修改、微调并在任何环境中部署,数据隐私和安全有保障,但这对技术能力和计算资源有较高要求。

- 闭源API:如通过接口调用 OpenAI、Google Gemini 等公司提供的服务,其优势是简单快捷,无需关心底层基础设施,模型由服务商持续维护和升级,劣势是数据需要传输到第三方,可能存在隐私和政策风险,且长期使用成本可能较高,功能定制性受限。

对于大多数寻求数据控制和深度定制的站长而言,选择优秀的开源模型并进行自部署,是一个平衡能力与自主性的方案。

第三步:准备计算资源

AI大模型对计算资源,尤其是GPU,有着巨大需求,您需要评估:

- GPU(图形处理器):这是运行大模型的核心硬件,您需要根据模型的大小(参数量)来选择合适显存的GPU,一个70亿参数的模型,至少需要16GB以上显存的GPU(如NVIDIA RTX 4090、A100等)才能流畅运行,对于更大的模型,可能需要多卡并联。

- CPU、内存与存储:强大的CPU和充足的内存(RAM)是数据预处理和模型加载的保障,高速的固态硬盘(SSD)则能显著加快模型加载速度。

部署方式上,您可以选择本地服务器、云服务商(如AWS、Google Cloud、阿里云等)的GPU实例,或是一些新兴的GPU租赁服务。

第四步:搭建软件环境

硬件就绪后,需要配置相应的软件栈。

- 操作系统:Linux(如Ubuntu)是首选,因其在服务器领域的稳定性和对AI工具链的良好支持。

- 驱动与底层库:安装NVIDIA的GPU驱动、CUDA工具包和cuDNN库,这是让模型能够在GPU上加速运行的基础。

- Python环境:使用

conda或venv创建一个独立的Python环境,避免包版本冲突。 - 深度学习框架:安装PyTorch或TensorFlow,这是构建和运行模型的核心框架。

- 模型库与工具:使用 Hugging Face 的

Transformers库、vLLM或FastChat等工具,它们提供了大量预训练模型的接口和高效的推理部署方案,能极大简化加载和使用模型的过程。

第五步:获取与加载模型

如果您选择了开源模型,可以从 Hugging Face Hub 或模型的官方仓库下载模型权重文件,使用上一步中安装的工具(如 Transformers),只需几行代码即可加载模型。

使用 Transformers 库:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("模型名称")

model = AutoModelForCausalLM.from_pretrained("模型名称", torch_dtype=torch.float16, device_map="auto")

这段代码会下载并加载模型到可用的设备(GPU)上。

第六步:部署与集成

将加载好的模型封装成API服务,以便其他应用程序调用,可以使用 FastAPI、Flask 或专为模型部署设计的 Triton Inference Server 等工具。

一个简单的 FastAPI 示例:

from fastapi import FastAPI

from pydantic import BaseModel

app = FastAPI()

class Request(BaseModel):

prompt: str

@app.post("/generate/")

async def generate_text(request: Request):

inputs = tokenizer(request.prompt, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_length=100)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

return {"response": response}

运行此服务后,您的应用程序就可以通过发送HTTP请求到 /generate/ 端点来获取模型的生成结果。

第七步:性能优化与持续维护

部署成功后,工作并未结束。

- 性能优化:您可以尝试量化技术,将模型精度从FP32降低到INT8或INT4,这能大幅减少显存占用并提升推理速度,且对质量损失影响很小,使用更高效的推理引擎(如TensorRT)也能带来性能提升。

- 持续维护:关注模型社区的动态,及时更新以获取性能提升和安全补丁,建立监控机制,关注服务的稳定性、资源利用率和响应延迟。

安全与伦理的考量

在部署AI模型时,必须将安全与伦理置于重要位置,需要采取措施防止模型被恶意利用,生成有害、有偏见或违法信息,确保用户数据在传输和处理过程中的安全与隐私,遵守相关法律法规。

设置并部署一个AI大模型是一个系统工程,它要求我们不仅具备技术执行力,更要有清晰的规划和对细节的掌控,从选择适合的模型到最终的上线运维,每一步都考验着部署者的综合能力,随着技术的不断进步,相关的工具链正变得越来越友好,门槛也在逐步降低,拥抱这个过程,您将能真正驾驭这项变革性的技术,为您的业务或项目创造独特的价值。