在当今技术飞速发展的时代,人工智能模型已经成为许多领域的重要工具,对于个人用户而言,部署AI模型不再是遥不可及的梦想,而是可以通过简单步骤实现的现实,无论你是开发者、学生还是爱好者,掌握如何个人部署AI模型,能帮助你更好地探索AI的潜力,应用于日常项目或学习中,本文将一步步引导你完成这个过程,强调实用性和可操作性,确保你能轻松上手。

选择适合的AI模型

你需要确定要部署的AI模型类型,市场上存在多种预训练模型,例如自然语言处理领域的GPT系列或计算机视觉中的YOLO模型,个人部署时,建议从轻量级模型入手,比如TensorFlow Hub或Hugging Face提供的开源模型,这些模型通常文档齐全,社区支持丰富,便于初学者快速上手,考虑你的硬件资源:如果只有普通笔记本电脑,选择参数较少的模型会更合适;若有GPU支持,可以尝试更复杂的架构,模型的选择直接影响部署的难度和性能,务必根据自身需求权衡。

准备部署环境

部署AI模型前,环境配置是关键一步,硬件方面,确保你的设备具备足够的内存和存储空间,对于大多数个人用户,一台配备8GB RAM和SSD硬盘的计算机已足够运行基础模型,如果需要处理大规模数据,考虑使用云服务如Google Colab,它提供免费的GPU资源,软件环境则依赖于模型框架:常见的有TensorFlow、PyTorch或ONNX,安装Python作为编程语言,并利用pip工具安装必要的库,例如transformers用于NLP模型,或OpenCV用于图像处理,创建一个虚拟环境可以避免依赖冲突,使用conda或venv工具轻松管理,检查操作系统兼容性;Windows、macOS和Linux均支持主流框架,但Linux在服务器部署中更常见。

下载和配置模型

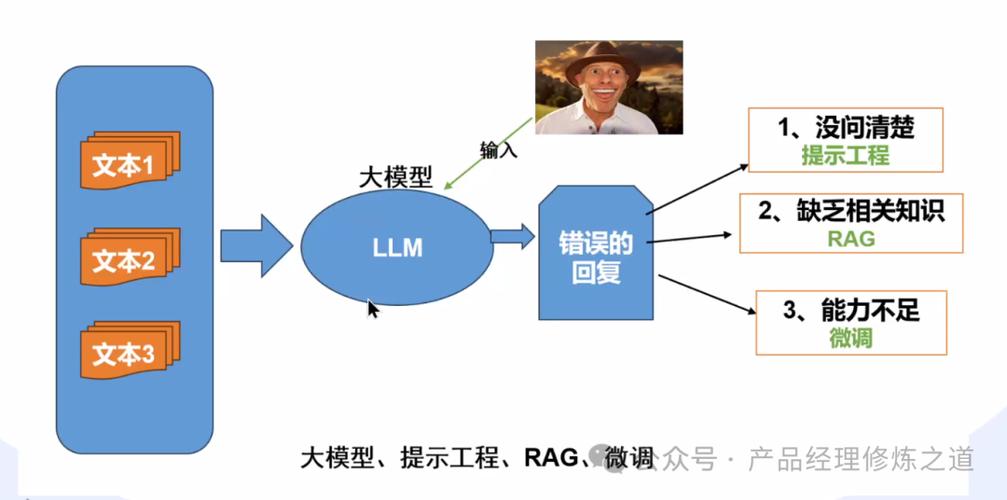

一旦环境就绪,下一步是获取模型文件,许多开源平台提供预训练模型的下载,例如从Hugging Face模型库直接导入,使用Python脚本,你可以通过几行代码加载模型,对于文本生成模型,调用transformers库的Pipeline功能即可快速启动,配置模型时,注意参数设置:批量大小、学习率和输入尺寸需根据你的硬件调整,如果模型需要自定义,可以使用迁移学习技术,在预训练基础上微调以适应特定任务,这个过程可能涉及数据预处理,确保输入格式符合模型要求,图像模型可能需要调整分辨率,而文本模型则需分词处理,保存配置文件和模型权重,便于后续重用。

运行和测试模型

部署的核心是让模型正常运行,编写一个简单的脚本或使用Jupyter Notebook来执行推理过程,加载模型后,输入样本数据观察输出结果,监控资源使用情况,如CPU/GPU占用率,以避免系统崩溃,测试阶段至关重要:使用验证数据集评估模型性能,计算准确率或损失值,如果遇到错误,查阅文档或社区论坛寻求帮助;常见问题包括版本不匹配或内存不足,为了提高效率,可以优化代码,例如使用多线程处理或缓存机制,对于Web应用集成,考虑使用Flask或FastAPI构建API接口,但这属于进阶内容,个人部署可先从本地运行开始。

处理常见挑战

个人部署AI模型时,可能会遇到各种挑战,资源限制是普遍问题:如果模型运行缓慢,尝试量化技术减少模型大小,或使用蒸馏方法简化架构,兼容性问题也常见,确保所有库版本一致,定期更新依赖,安全方面,注意模型和数据隐私,避免在公共网络中暴露敏感信息,模型更新和维护需要时间;设定定期检查点,备份重要文件,遇到技术瓶颈时,不要气馁;参与在线课程或阅读相关书籍能提升技能,实践是学习的最佳途径,每一次尝试都会积累经验。

优化和扩展部署

完成基础部署后,你可以进一步优化模型性能,使用工具如TensorBoard可视化训练过程,识别瓶颈并调整超参数,如果计划长期使用,考虑容器化技术,例如Docker,它能简化环境部署并提高可移植性,对于移动设备部署,TensorFlow Lite或PyTorch Mobile提供轻量级解决方案,扩展应用场景:将模型集成到智能家居项目或数据分析工具中,发挥创意,个人部署的魅力在于灵活性,你可以根据兴趣调整方向,例如结合AI与物联网开发个性化助手。

通过以上步骤,个人部署AI模型变得简单可行,这不仅是技术能力的提升,更是拥抱未来智能时代的一种方式,从我自己的经验来看,起步时可能会觉得复杂,但只要耐心尝试,你会发现其中的乐趣和成就感,AI模型部署就像解锁一扇新的大门,让你亲手打造智能解决方案,为生活和工作增添无限可能,坚持下去,你会看到自己的成长和进步。