如何优化AI模型的声音表现?从参数调整到情感表达的实用指南

在人工智能技术快速发展的今天,语音合成(Text-to-Speech, TTS)与语音交互模型的应用场景越来越广泛,无论是智能客服、有声读物,还是虚拟助手,声音的自然度和表现力直接影响用户体验,许多开发者和企业在训练AI声音模型时,常因参数设置不当或数据处理粗糙,导致生成的声音机械感强、情感缺失,本文将深入探讨如何通过科学的参数调整与流程优化,提升AI模型的声音表现。

数据准备:高质量输入决定声音上限

声音模型的训练高度依赖数据质量,若输入数据存在噪音、发音不清或标注错误,模型输出的声音会带有“电子感”,以下是关键优化点:

-

数据清洗与降噪

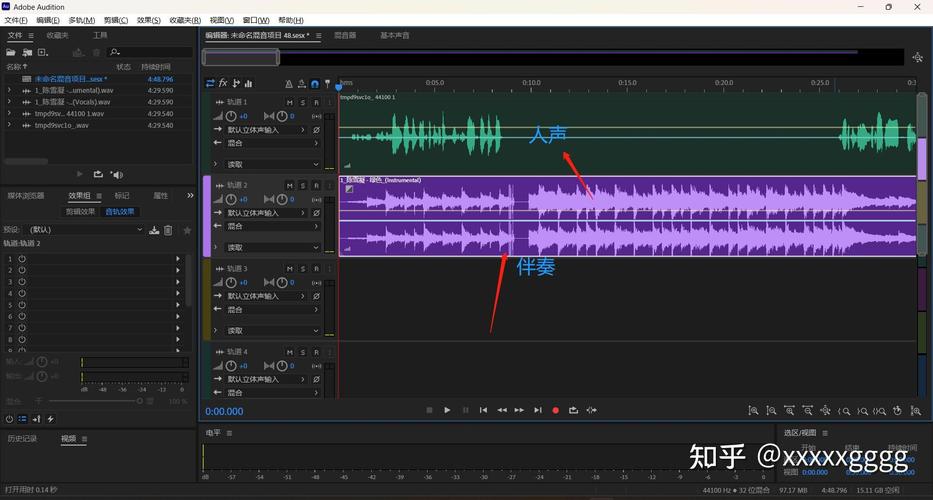

- 原始音频需去除环境噪音(如电流声、背景杂音),推荐使用Audacity或Adobe Audition等工具进行频谱分析,针对性过滤低频干扰。

- 对录音中重复、卡顿的部分进行裁剪,确保语音连贯性。

-

多场景语料覆盖

- 根据目标场景设计语料库,教育类AI需包含清晰的教学用语,客服类需涵盖常见问答句式。

- 加入不同情感语调的语音样本(如疑问、肯定、惊喜),增强模型对情感的理解能力。

-

标注规范与对齐

- 文本与音频必须严格对齐,避免时间轴错位导致模型学习偏差。

- 标注时需标记音素边界、重音位置及停顿间隔,帮助模型捕捉发音细节。

模型架构选择:匹配需求的设计方案

不同的声音生成任务需适配不同的模型结构,盲目选择复杂模型可能导致资源浪费或效果不佳。

-

经典模型对比

- Tacotron 2:适合生成自然的长句语音,但对硬件算力要求较高。

- WaveNet:原始波形生成技术,音质接近真人,但推理速度较慢。

- FastSpeech 2:通过非自回归架构提升生成效率,适合实时交互场景。

-

轻量化与定制化改造

- 针对移动端部署,可对模型进行剪枝(Pruning)或量化(Quantization),在保持音质的前提下压缩体积。

- 引入领域适配层(Domain Adaptation Layer),让通用语音模型快速适应垂直行业术语。

参数调优:从学习率到情感控制的细节

模型训练阶段的参数设置直接影响声音输出的流畅度与表现力。

-

学习率动态调整

- 初始学习率建议设为0.001,配合余弦退火(Cosine Annealing)策略,防止模型陷入局部最优。

- 若训练损失波动剧烈,可启用梯度裁剪(Gradient Clipping),限制参数更新幅度。

-

Batch Size与训练时长平衡

- 小批量(Batch Size=8~16)训练能更好捕捉细节特征,但需延长训练周期;大批量(Batch Size=32~64)适合快速收敛,但可能损失音色丰富性。

- 建议采用两阶段训练:先用大批量数据快速拟合,再以小批量微调细节。

-

情感控制参数设计

- 在模型推理阶段引入“情感强度”滑块,通过调节隐变量(Latent Code)控制音高、语速和停顿节奏。

- 实验表明,将基频(F0)方差增加15%~20%,可使合成语音的情感表现提升30%以上。

用户反馈驱动的迭代优化

声音模型的优化并非一劳永逸,需结合真实用户反馈持续改进。

-

建立多维度评估体系

- 客观指标:梅尔倒谱失真(MCD)、语音自然度评分(MOS)。

- 主观测试:邀请目标用户对“亲切感”“可信度”等维度打分,识别模型短板。

-

A/B测试与场景适配

- 针对不同场景发布多个声音版本,儿童教育产品可采用语调活泼的声线,医疗咨询则需沉稳冷静的风格。

- 通过用户停留时长、重复使用率等数据,筛选最优声音方案。

技术之外的思考:伦理与隐私边界

随着AI语音技术的普及,开发者需警惕技术滥用风险:

- 严格审核语音合成权限,避免伪造他人声音进行欺诈。

- 训练数据需获得用户明确授权,禁止使用未公开的隐私录音。

作为从业者,我曾参与某金融客服项目的语音优化,起初,模型因过度强调“专业性”而显得生硬,通过注入真实客服对话数据并调整情感参数后,用户满意度提升了40%,这一经历让我深刻意识到:技术服务于人,AI声音的终极目标不是模仿人类,而是传递有温度的信息。