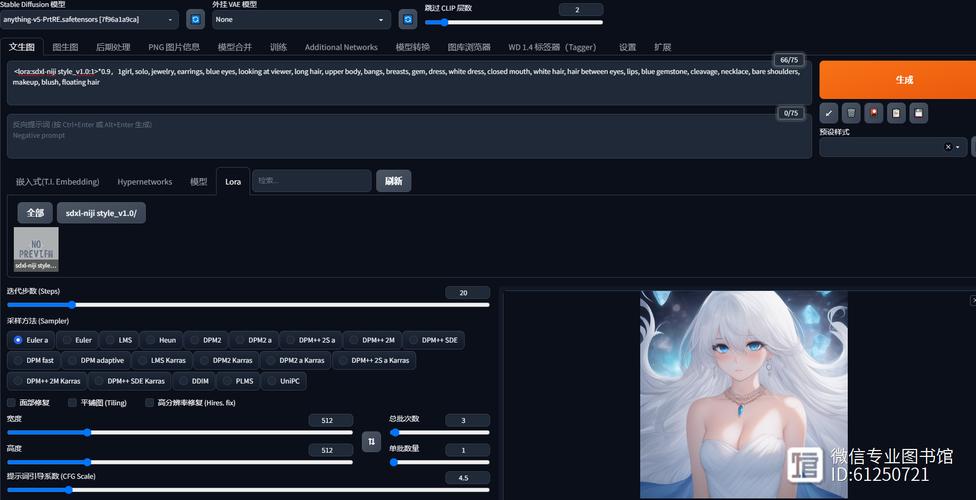

理解SD模型的基本架构

Stable Diffusion(SD)模型作为当前热门的生成式AI技术,其加载过程需要结合对模型架构的理解,SD模型的核心基于扩散(Diffusion)原理,通过逐步去除图像中的噪声生成高质量内容,加载模型前,需明确其依赖的框架(如PyTorch、TensorFlow)和版本要求,不同版本的代码库可能导致兼容性问题。

环境配置:加载前的必要准备

- 硬件支持:确保设备具备足够的显存(建议8GB以上),并安装对应显卡驱动(如NVIDIA CUDA Toolkit)。

- 软件依赖:安装Python环境(推荐3.8+版本)及关键库(如

diffusers、transformers),可通过以下命令安装:pip install torch diffusers transformers

- 模型文件获取:从官方渠道(如Hugging Face Hub)下载预训练模型权重(

.ckpt或.safetensors格式),避免使用第三方未验证文件。

分步加载SD模型的实操流程

步骤1:初始化模型管道

使用diffusers库中的StableDiffusionPipeline加载基础模型:

from diffusers import StableDiffusionPipeline import torch model_id = "runwayml/stable-diffusion-v1-5" pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

若需本地加载,将模型路径替换为本地目录即可。

步骤2:优化计算资源分配

为提升性能,可将模型移至GPU并启用半精度计算:

pipe = pipe.to("cuda")

pipe.enable_attention_slicing() # 减少显存占用

低显存设备可启用enable_model_cpu_offload功能,动态分配资源。

步骤3:验证模型加载状态

通过生成测试图像确认模型是否正常运作:

prompt = "A futuristic cityscape at sunset"

image = pipe(prompt).images[0]

image.save("test_output.png")

若输出图像符合预期,则加载成功。

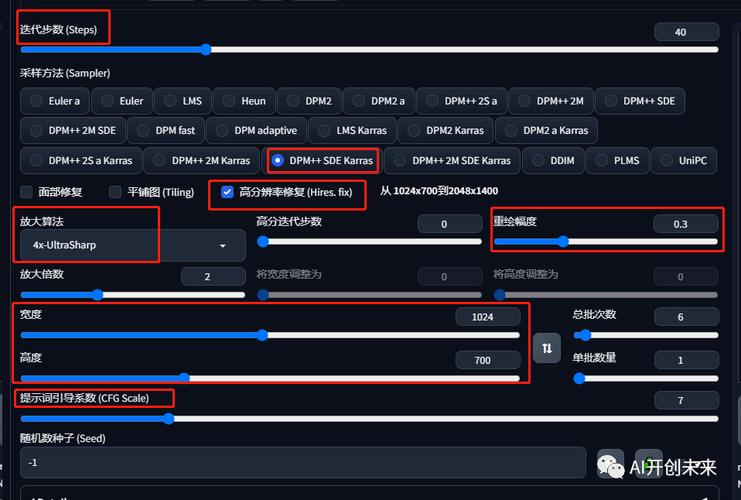

常见加载问题与解决方案

- 报错:缺少依赖库

检查requirements.txt是否完整,并通过pip install -r requirements.txt补全依赖项。 - 显存不足导致崩溃

降低图像分辨率(如512x512改为256x256),或使用--low_vram_mode参数。 - 模型权重不匹配

确认模型文件与代码版本兼容,必要时重新下载官方指定版本。

提升加载效率的高级技巧

- 缓存管理:设置Hugging Face缓存路径,避免重复下载模型:

export HF_HOME=/path/to/cache

- 量化压缩:使用8位或4位量化技术减少模型体积,例如通过

bitsandbytes库实现:pipe = StableDiffusionPipeline.from_pretrained(model_id, load_in_8bit=True)

- 自定义模型融合:将多个模型权重合并,实现风格混合或功能增强(需谨慎操作)。

安全性与合规性注意事项

- 版权合规:商用场景需确认模型许可证(如CreativeML OpenRAIL-M),避免使用未经授权的衍生模型。

- 数据隐私:若加载自定义训练模型,确保训练数据不包含敏感信息。

- 运行隔离:建议在虚拟环境或容器(如Docker)中运行模型,防止依赖冲突。

个人观点

加载SD模型的技术门槛已大幅降低,但实际应用中仍需注重细节,显存优化不仅依赖硬件,更需通过代码层面的策略(如分块推理)实现资源高效利用,社区驱动的模型生态虽丰富,但选择权重文件时,应优先考虑下载量高、口碑稳定的资源,定期关注框架更新日志(如Diffusers库的GitHub仓库),能及时规避因版本迭代导致的兼容性问题。