数据准备:AI模型的“营养基础”

AI模型的训练本质上是一个数据驱动过程,就像为植物提供养分才能生长一样,数据质量直接影响模型的最终表现,优质数据需满足三个核心要求:多样性、准确性和平衡性。

多样性指数据需覆盖模型可能遇到的不同场景,训练一个识别动物的模型,需要包含不同品种、光照条件、拍摄角度的图片。准确性则要求数据标注正确,错误标签会导致模型学习错误规律。平衡性强调数据分布合理,若数据集中90%是猫的图片,模型可能对狗的分类能力极差。

实际应用中,数据来源通常包括公开数据集(如ImageNet)、用户行为日志(如电商平台的点击记录)或第三方合作数据(如医疗影像),需注意数据合规性,避免使用涉及隐私或版权争议的内容。

数据预处理:从原始数据到“可消化食材”

未经处理的原始数据无法直接用于训练,必须通过预处理转化为结构化信息,这一过程包括以下关键步骤:

- 数据清洗:剔除重复、噪声或异常值,自动驾驶数据中模糊的图像、传感器误报的极端数值需被过滤。

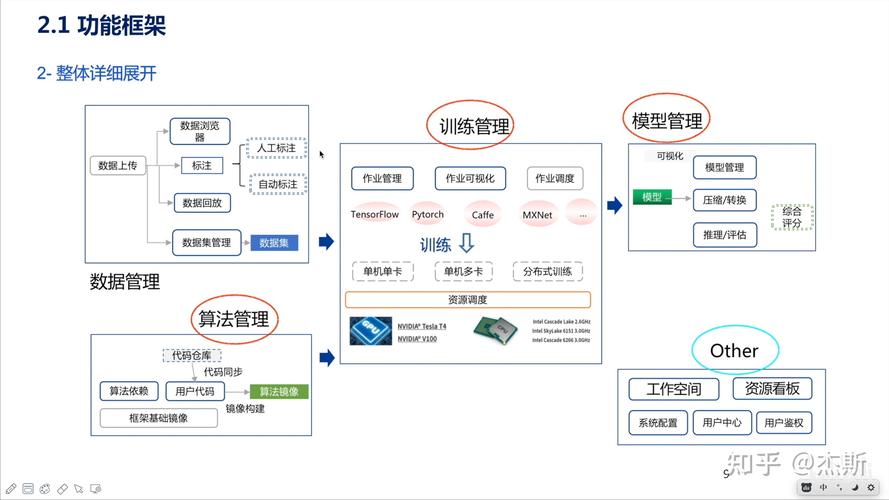

- 数据标注:根据任务类型选择标注方式,监督学习需人工标注标签(如为图片打“猫/狗”标签),无监督学习则依赖聚类或降维提取特征。

- 数据增强:通过旋转、裁剪、添加噪声等方式扩充数据量,提升模型泛化能力,一张人脸图片可生成20种变体,模拟不同拍摄条件。

- 标准化与归一化:将数据缩放到统一范围(如0-1之间),避免某些特征因数值过大主导模型训练。

模型训练:搭建“消化系统”的核心阶段

当数据准备就绪后,需选择合适的算法架构与训练策略,常见技术包括:

- 监督学习:输入数据与标签一一对应,适用于分类、回归任务(如预测房价)。

- 无监督学习:从无标签数据中发现规律,典型应用是聚类(如用户分群)。

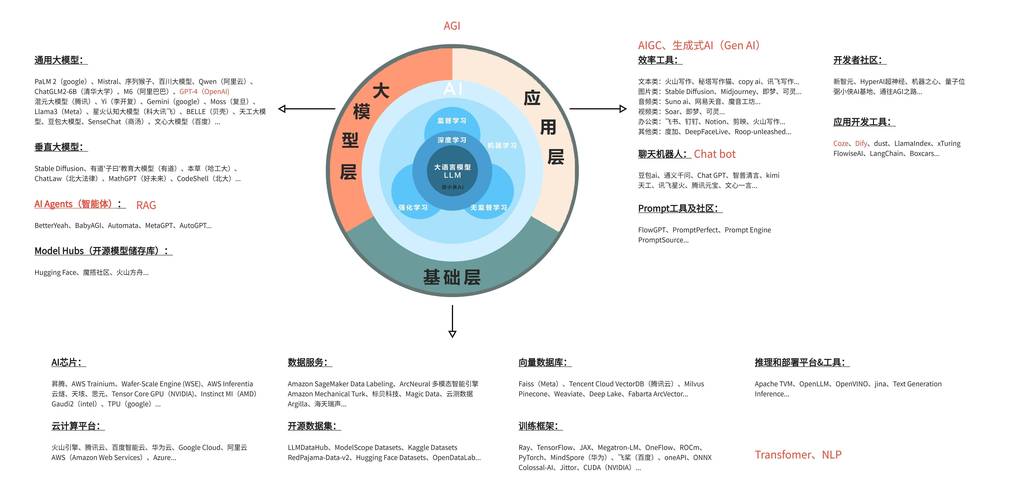

- 迁移学习:复用预训练模型(如BERT、ResNet)的参数,通过微调适配新任务,可节省90%以上训练资源。

关键参数设置直接影响训练效果:

- 学习率:决定模型参数更新幅度,过高会导致震荡,过低则收敛缓慢。

- 批次大小:单次训练使用的样本量,需根据硬件性能平衡速度与稳定性。

- 损失函数:定义模型预测值与真实值的差异,如交叉熵损失用于分类,均方误差用于回归。

现代训练常采用分布式计算框架(如TensorFlow、PyTorch),利用GPU集群加速迭代,训练过程中需监控损失曲线,若验证集误差持续上升,可能出现过拟合,需及时终止(早停法)或引入正则化。

评估与调优:验证模型的“健康状态”

训练完成后,需通过多维度指标评估模型表现:

- 准确率/精确率/召回率:分类任务的黄金标准,需根据场景选择侧重点(如医疗诊断更关注召回率)。

- AUC-ROC曲线:衡量二分类模型整体性能,避免单一阈值下的偏差。

- BLEU或ROUGE分数:自然语言处理任务中,评估生成文本与参考答案的相似度。

若模型未达预期,可从以下方向调优:

- 数据层面:增加稀缺类别样本,或通过SMOTE算法生成合成数据。

- 模型层面:调整网络深度(如增加卷积层)、引入注意力机制优化特征提取。

- 超参数优化:使用网格搜索、贝叶斯优化等算法自动寻找最佳参数组合。

未来趋势:AI训练的进化方向

随着技术发展,AI训练方法正经历三大变革:

- 自动化机器学习(AutoML):通过算法自动完成特征工程、模型选择与调参,降低人工干预成本。

- 多模态学习:融合文本、图像、语音等多种数据类型,训练更接近人类认知的通用模型。

- 隐私保护训练:联邦学习、差分隐私等技术实现在不共享原始数据的前提下联合建模,满足合规需求。

个人观点

AI模型的训练既是一门科学,也是一门艺术,数据质量的重要性常被低估,但实践中,80%的模型效果提升来自数据优化而非算法改进,未来的竞争将逐渐从“拼算力”转向“拼数据治理能力”,谁能更高效地挖掘数据价值,谁就能在AI赛道上占据先机。

结束**