AI模型的“喂养”逻辑与实践

人工智能模型的训练过程常被形象地称为“喂养”,这一过程并非简单地堆砌数据或套用算法,而是需要系统性思维、精准的数据管理以及对技术原理的深度理解,本文将围绕AI模型训练的核心环节,解析如何高效“喂养”模型,使其在实际应用中发挥最大价值。

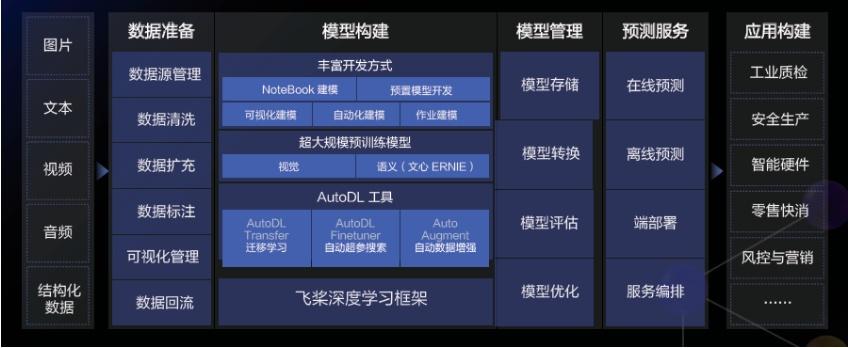

数据:模型成长的“养分”

数据是AI模型的基础“食物”,其质量直接决定模型的表现。优质数据需满足三个条件:多样性、代表性和准确性。

-

数据收集

数据来源需覆盖模型可能遇到的所有场景,训练一个识别动物的模型,需包含不同品种、姿态、光照条件下的图片,开放数据集(如ImageNet)、行业数据库或用户行为日志均可作为数据源,但需确保合法合规。

-

数据清洗

原始数据往往包含噪声,需通过去重、缺失值填补、异常值剔除等方式优化,在自然语言处理任务中,需过滤广告文本、无意义符号;在图像识别中,需统一分辨率并标注关键特征。 -

数据标注

监督学习依赖精准标注,标注规则需明确且一致,可采用众包平台或专业团队完成,对于复杂任务(如医学影像分析),需引入领域专家参与标注,以提升可靠性。

模型训练:从“消化”到“成长”

数据准备完成后,需通过算法框架将其转化为模型能力,这一阶段的核心在于平衡“学习效率”与“泛化能力”。

-

选择算法框架

根据任务类型选择合适模型,卷积神经网络(CNN)适用于图像处理,Transformer架构更擅长序列建模(如文本生成),初学者可借助开源工具(如TensorFlow、PyTorch)快速搭建原型。 -

参数初始化与超参数调优

参数初始化影响模型收敛速度,常用方法包括随机初始化、Xavier初始化等,超参数(如学习率、批量大小)需通过网格搜索或贝叶斯优化反复调整,学习率过高可能导致模型震荡,过低则收敛缓慢。 -

训练过程监控

使用验证集实时评估模型表现,避免过拟合或欠拟合,工具如TensorBoard可可视化训练曲线,帮助开发者及时调整策略,若验证集准确率持续低于训练集,可能需增加数据量或引入正则化技术。

优化与迭代:模型的“健康管理”

模型初步训练完成后,需通过精细化调整提升其鲁棒性。

- 正则化技术

- Dropout:随机屏蔽部分神经元,强制模型学习冗余特征。

- L1/L2正则化:约束权重参数,防止过度依赖少数特征。

- 数据增强:通过旋转、裁剪、噪声注入等方式扩充数据集,提升泛化能力。

-

模型压缩与加速

对于部署至移动端或边缘设备的模型,可采用剪枝、量化、知识蒸馏等技术减少计算量,BERT模型经蒸馏后可保留90%性能,但体积缩小60%。 -

持续学习

模型上线后需定期更新,适应数据分布变化,电商推荐系统需根据用户行为动态调整推荐策略,可通过增量学习或在线学习实现模型的“终身成长”。

避开常见误区

-

盲目追求数据量

数据规模并非越大越好,低质量数据会引入噪声,反而降低模型性能,需优先确保数据代表性,再逐步扩展规模。 -

忽视偏差与公平性

训练数据中的隐性偏见可能导致模型歧视,人脸识别系统若缺乏深肤色样本,可能影响识别准确率,需通过数据平衡和伦理审查规避风险。 -

过度依赖自动化工具

AutoML等技术可降低训练门槛,但若缺乏对业务场景的理解,可能导致模型“水土不服”,开发者需深入参与关键决策,如特征工程设计、评估指标选择等。

个人观点

AI模型的“喂养”本质是技术与艺术的结合,它不仅需要严谨的工程能力,还需对业务需求有敏锐洞察,当前,行业竞争逐渐从“拼算力”转向“拼数据质量”与“拼迭代效率”,随着多模态学习、小样本学习等技术的发展,模型的“喂养”方式将更加智能化,但核心逻辑不会改变:理解数据、敬畏算法、持续迭代。

(全文约1350字)