AI本地部署模型实战指南:释放私有化智能的完整路径

当数据成为新时代的石油,AI模型便是精炼厂的核心引擎,将这座“引擎”搬进自家机房——AI本地部署,正成为企业掌控数据主权、优化响应效率的关键策略,不同于云端调用,本地部署将模型完整运行在自有硬件上,实现数据不出域、响应零延迟、定制无上限的智能闭环,本文将系统拆解本地部署全流程,助您安全高效驾驭私有AI。

为何选择本地部署?超越云端的三大核心价值

- 数据安全屏障

金融病历、研发代码、商业策略... 敏感数据无需上传第三方,彻底规避云端泄露风险,满足GDPR等严苛合规要求。 - 极致性能体验

模型推理在本地服务器完成,网络延迟归零,工业质检、实时翻译等高并发场景,毫秒级响应成为现实。 - 深度定制自由

基于私有数据微调模型,打造贴合业务场景的专属AI,可自由修改架构、调整参数,突破通用模型能力边界。

部署实战四步曲:从硬件到应用

第一步:夯实硬件地基 - 算力与内存的精准匹配

- GPU选择

- 入门级 (7B以下小模型):NVIDIA RTX 3090/4090 (24GB显存) 可流畅运行Llama 3、Phi-3等模型。

- 企业级 (70B+大模型):需A100/H100 集群,或消费级多卡并联(如4*RTX 4090)。

- 内存与存储

- 模型加载需大内存:建议至少32GB RAM(7B模型),百亿级模型需128GB+。

- 高速固态硬盘(NVMe SSD)大幅加速模型加载与数据读取。

避坑提示:显存容量是硬指标!务必确认模型大小(如Llama3-70B需约140GB显存),显存不足时考虑量化(INT4/INT8)或CPU卸载方案。

第二步:构建软件生态 - 环境配置与工具选型

- 基础环境

- 操作系统:Linux (Ubuntu 22.04 LTS 首选) 或 Windows WSL2。

- Python环境:Anaconda/Miniconda 创建独立虚拟环境(Python 3.10+)。

- 核心框架安装

# 示例:安装PyTorch (CUDA 12.1版本) conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia # 安装Hugging Face生态库 pip install transformers accelerate bitsandbytes

- 部署工具推荐

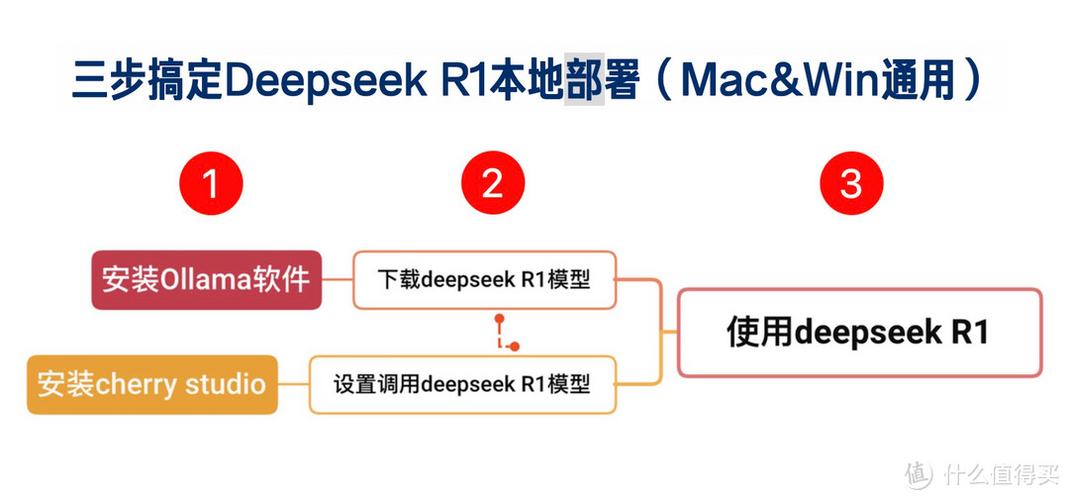

- Ollama: 极简命令行工具,一键下载运行Llama/Mistral等主流模型。

- LM Studio: 图形化神器,拖拽式管理本地模型,支持OpenAI兼容API。

- Text Generation WebUI: 开源Web界面,集成模型加载、聊天、参数调整。

第三步:获取与加载模型 - 从仓库到本地推理

- 模型下载源

- Hugging Face Hub:最大开源模型库(需注册)。

- 官方发布渠道(如Meta的Llama、Microsoft的Phi)。

- 社区镜像站(国内加速推荐)。

- 模型格式与加载

- 常见格式:GGUF(通用高效)、PyTorch Binaries (.bin)、Safetensors。

- Hugging Face 加载示例:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "meta-llama/Meta-Llama-3-8B-Instruct" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name, device_map="auto") # 自动分配GPU/CPU

第四步:运行与优化 - 让模型高效服务业务

- 基础推理测试

使用所选工具(如LM Studio)或编写脚本进行对话/文本生成测试,验证基础功能。 - API服务暴露

通过工具内置API或框架(如FastAPI)构建HTTP服务:from fastapi import FastAPI app = FastAPI() @app.post("/generate") async def generate_text(prompt: str): inputs = tokenizer(prompt, return_tensors="pt").to(model.device) outputs = model.generate(**inputs, max_new_tokens=200) return {"response": tokenizer.decode(outputs[0])} - 关键性能调优

- 量化压缩:使用

bitsandbytes加载4/8位量化模型,显存占用直降50-70%。 - 提示词工程:设计清晰指令模板(如System Prompt),显著提升输出质量。

- 批处理优化:合理设置

batch_size,充分利用GPU并行能力。

- 量化压缩:使用

典型场景与进阶路线

- 企业知识库问答:微调模型(如Llama3)接入内部文档,构建智能客服助手。

- 代码生成辅助:部署DeepSeek-Coder,实现IDE内联级编程支持。

- 自动化报告撰写:定制模型读取数据库,生成周报/分析摘要。

- 下一步探索:

- 私有数据微调:使用LoRA/P-Tuning技术低成本适配业务语料。

- 多模型协作:构建本地Model Router,按任务调度最优模型。

- 硬件深度优化:集成vLLM/TensorRT-LLM实现吞吐量倍增。

当全球科技巨头竞逐云端AI霸权时,本地部署悄然开辟了一条更安全、更自主、更高效的智能化路径,它不仅是技术选择,更是企业掌控数字命运的战略能力——数据在自有算力上流动,价值在封闭环境中沉淀,每一次本地模型的成功推理,都在加固您的竞争护城河,这项能力,终将成为未来十年企业智能化生存的标配。

关键提示:持续关注开源社区动态(如Hugging Face、GitHub),模型优化技术与工具迭代极快,保持更新方能占据效率制高点。