高效AI模型系统:解锁智能应用的核心方法论

在数字化浪潮席卷全球的今天,高效AI模型系统已成为驱动企业创新与个人效率跃升的关键引擎,如何真正驾驭这股力量,使其精准服务于目标而非沦为技术摆设?这需要我们掌握科学的理念与方法。

高效AI模型系统的核心要素

理解高效AI模型的本质是应用前提,其核心在于三个维度的协同优化:

- 模型效能: 衡量模型在特定任务上的精度、速度及泛化能力,高精度模型如GPT-4、Claude或行业专用微调模型,能更可靠地处理复杂问题。

- 资源效率: 关注模型训练与推理过程对算力、内存和能耗的消耗,轻量化技术(模型压缩、知识蒸馏)及硬件加速(专用AI芯片)是提升方向。

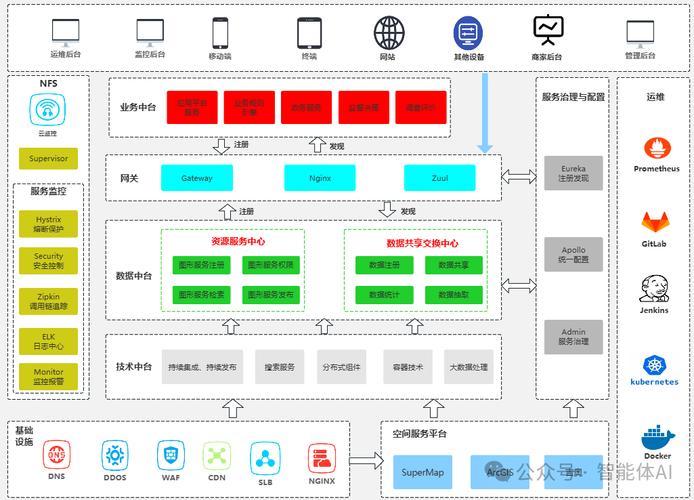

- 部署敏捷性: 模型需能快速集成至现有工作流,支持云端、边缘端灵活部署,并易于维护更新,容器化(Docker)和模型服务框架(如TensorFlow Serving)至关重要。

高效应用的核心步骤

将强大模型转化为实际生产力,需遵循结构化路径:

-

精准定义任务与目标:

- 痛点聚焦: 明确要解决的具体业务问题或效率瓶颈(如客服响应慢、报告生成耗时、图像分析需求)。

- 目标量化: 设定可衡量的成功指标(响应时间缩短X%、人力成本降低Y%、准确率提升至Z%)。

- 数据审视: 评估现有数据质量、数量及与任务的匹配度,这是模型表现的决定性因素。

-

模型选择与适配:

- 任务匹配: 文本生成选大语言模型,图像识别用卷积神经网络,时序预测考虑RNN或Transformer。

- 效率权衡: 资源有限场景优先考虑轻量模型或高效架构(如MobileNet, EfficientNet),云端大模型API(如OpenAI, 文心一言)提供强大即战力。

- 领域适配: 通用模型常需领域数据微调,显著提升专业场景表现,某电商平台通过微调模型处理海量商品描述,信息抽取准确率提升40%。

-

工程化部署与集成:

- 构建稳健服务: 利用API网关、负载均衡确保模型服务高可用、可扩展。

- 无缝对接系统: 通过标准化接口与企业CRM、ERP、数据分析平台集成,让AI能力融入现有血液。

- 资源监控: 实时跟踪GPU利用率、内存消耗、API延迟,保障服务稳定性。

-

持续迭代与优化:

- 反馈闭环: 建立用户反馈与结果评估机制,识别模型错误与不足。

- 数据驱动更新: 基于新数据、新反馈持续微调模型,适应变化。

- 性能调优: 探索量化、剪枝等技术压缩模型,优化推理引擎,降低成本提升速度。

提升应用效果的进阶策略

- 提示工程精研: 精心设计输入提示是激发大模型潜力的钥匙,清晰的任务描述、上下文示例、格式要求能极大提升输出质量。

- 人机协同智能: AI非万能替代者,复杂决策、创意构思、伦理判断仍需人类主导,建立AI辅助、人类审核的高效协作流程。

- 安全与伦理前置: 重视数据隐私保护,防范模型偏见与滥用风险,部署前进行严格的安全测试与伦理审查,建立透明可解释机制。

风险意识不可或缺

高效模型应用伴随挑战:数据隐私泄露风险、算法偏见可能加剧社会不公、过度依赖导致人类技能退化、“幻觉”输出影响决策,开发者与使用者需保持警惕,建立完善治理框架。

驾驭未来的关键

高效AI模型系统如同精密仪器,价值在于使用者的智慧,理解原理、清晰规划、工程落地、持续优化、人机共进,是释放其潜能的必经之路,AI技术发展日新月异,但核心方法论稳固:以解决实际问题为出发点,以创造真实价值为衡量标准,我观察到,最成功应用案例往往始于最朴素的效率提升需求,而非对技术潮流的盲目追逐,技术终将服务于人,而非定义人。