掌握AI模型部署核心:安全路径管理与无缝切换策略

在AI应用部署的实战场景中,"隐藏模型路径"与"无缝切换模型"是保障系统安全性与灵活性的关键技术,这绝非简单的文件隐藏操作,而是一套涉及安全、工程与运维的系统性解决方案。

模型路径为何需要"隐藏"?安全为先

- 防范恶意访问与窃取: 暴露模型文件存储路径如同敞开金库大门,攻击者可轻易定位并下载核心模型资产,导致知识产权被盗或模型遭恶意篡改注入后门。

- 规避未授权调用: 公开路径可能被未授权程序或用户直接调用,消耗计算资源、干扰服务,甚至被用于非法数据挖掘。

- 增强系统整体安全性: 隐藏路径是纵深防御策略的重要环节,缩小攻击面,增加攻击者渗透难度。

实现模型路径"隐藏"的工程实践

-

环境变量与配置文件(基础安全层):

- 绝对避免在代码中硬编码路径,使用环境变量 (

PATH_TO_MODEL_A) 或在严格权限控制的配置文件中指定路径。 - 部署时通过安全渠道(如Kubernetes Secrets、配置管理中心)注入这些值,确保生产环境路径不暴露于代码仓库。

- 绝对避免在代码中硬编码路径,使用环境变量 (

-

服务化接口封装(API网关):

- 核心策略:绝不允许外部直接访问模型文件存储位置(如NFS目录、云存储桶)。

- 构建稳固的API服务层(如Flask/FastAPI、gRPC服务),客户端仅能与定义良好的API端点交互,模型文件的加载、调用完全在服务内部完成。

- API网关提供额外安全层:认证、授权、限流、日志审计。

-

严格的文件系统与存储权限控制:

- 模型存储目录权限设置为仅允许运行模型服务进程的操作系统用户/组读写执行(如

chmod 750,chown modeluser:modelgroup)。 - 云存储方案(AWS S3, GCS, Azure Blob)使用精细的IAM策略,仅授予服务账户必要的最小权限(如

s3:GetObject),并通过预签名URL或访问密钥管理实现临时、可控的访问。

- 模型存储目录权限设置为仅允许运行模型服务进程的操作系统用户/组读写执行(如

-

容器化封装:

- 将模型文件打包进Docker镜像,路径在镜像内部固定,外部通过容器运行时映射或卷挂载访问,天然隔离了宿主机路径。

- 结合镜像仓库权限控制,进一步保护模型资产。

模型热切换:保障服务不中断的进化能力

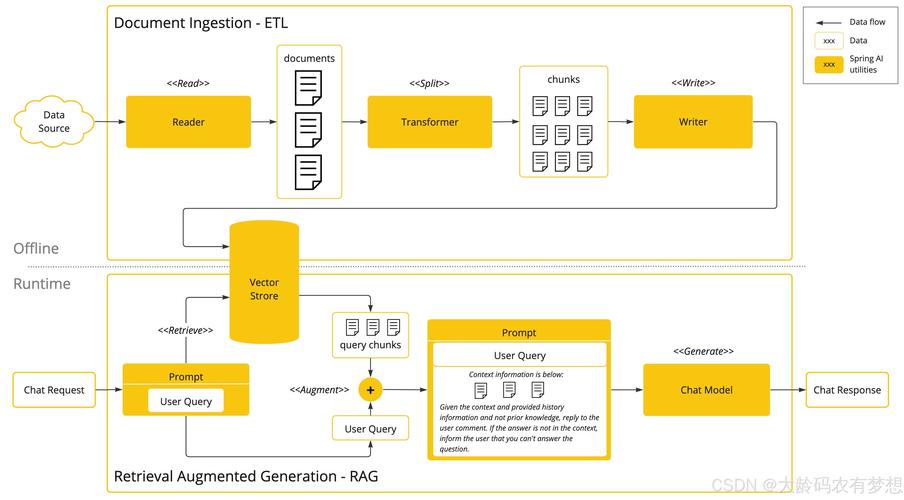

模型需要持续迭代(版本更新、AB测试、紧急回滚)。"热切换"指在不重启服务、不影响线上流量的前提下完成模型替换。

-

动态加载机制:

- 服务启动时不立即加载所有模型,维护一个模型注册表(Registry),记录模型名称、版本、对应加载器函数及当前内存中实例。

- 当需要切换或加载新模型时,服务根据指令动态调用加载器函数,从安全存储中读取模型文件到内存。

-

版本化存储与路由:

- 模型文件按清晰命名规则存储(如

model_name/v1/model.pt,model_name/v2/model.onnx)。 - 服务通过注册表管理多版本模型实例,API请求可携带版本号参数(如

/predict?model_version=v2),由路由层将请求分发至对应模型实例。

- 模型文件按清晰命名规则存储(如

-

流量迁移与影子测试:

- 金丝雀发布/渐进式流量切分: 新模型上线后,先分配极小比例(如1%)真实流量,监控效果与系统指标,逐步增加比例直至完全切换。

- 影子模式: 新模型并行处理请求但不返回结果,仅收集输出日志用于和旧模型对比验证,确认无误后再正式切换。

-

权重/参数热更新(高级场景):

- 某些框架支持直接更新内存中模型的权重参数(如PyTorch的

load_state_dict),这适用于模型结构不变仅需微调权重的情景,速度极快,需严格校验新权重兼容性。

- 某些框架支持直接更新内存中模型的权重参数(如PyTorch的

关键工具链与最佳实践

- 模型仓库: MLflow Model Registry, Kubeflow Pipelines, DVC,统一存储、版本管理、元数据追踪。

- 部署与编排: Kubernetes, Docker, KFServing, Seldon Core, TorchServe, TensorFlow Serving,提供弹性伸缩、健康检查、滚动更新。

- 配置管理: HashiCorp Vault, Kubernetes ConfigMaps/Secrets, 云服务商密钥管理服务(KMS),安全存储敏感信息。

- 监控与告警: Prometheus/Grafana(指标)、ELK Stack(日志)、分布式追踪(Jaeger, Zipkin),实时掌握模型性能、资源消耗、预测延迟与错误率。

- CI/CD for ML: 自动化模型测试、构建、部署流水线,确保切换过程可重复、可审计。

安全路径管理与模型热切换能力是现代AI工程化落地的基石,这要求开发者超越单纯算法层面,深入理解基础设施安全、软件工程实践和运维体系,通过服务化封装、严格权限控制、动态加载与智能流量管理,不仅能有效保护核心资产,更能实现模型的敏捷迭代与服务的持续可靠,选择适配的工具链并贯彻自动化、监控驱动的原则,是构建健壮、可信赖AI服务的关键路径。(本文约1250字)