人工智能(AI)开源模型框架正席卷全球,成为开发者、研究者和企业创新的核心引擎,无论你是新手还是经验丰富的专业人士,掌握如何使用这些工具,能加速项目落地,提升效率,作为网站站长,我亲身体验过多个框架的实战应用,深知其潜力与挑战,本文将带你深入浅出,一步步解析如何上手AI开源模型框架,聚焦实用性,避免常见陷阱。

理解AI开源模型框架

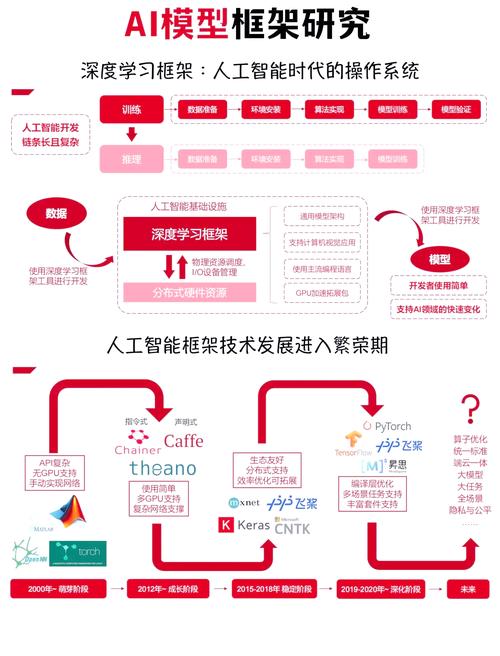

AI开源模型框架是软件库,提供构建、训练和部署机器学习模型的工具集,它们开源免费,社区驱动,意味着你无需从头造轮子,就能利用前沿技术,核心价值在于简化复杂流程,比如图像识别、自然语言处理或预测分析,TensorFlow由谷歌开发,强调工业级部署;PyTorch来自Facebook,以灵活性和研究友好著称;Hugging Face Transformers则专攻预训练模型,让NLP任务触手可及,这些框架共享一个理念:开放协作,推动AI民主化,选择时,考虑你的项目需求——TensorFlow适合大规模生产,PyTorch便于快速实验,而Hugging Face则简化了模型调用。

准备工作:环境设置与安装

上手前,需搭建稳定环境,第一步,安装Python——AI开发的通用语言,推荐Python 3.8或更高版本,通过官网下载安装包,配置包管理器pip,用于安装库,打开命令行,输入pip install --upgrade pip确保最新版,安装虚拟环境工具如venv或conda,隔离项目依赖,避免冲突,创建虚拟环境:python -m venv myenv,激活后安装框架。

针对具体框架:

- TensorFlow:运行

pip install tensorflow,若用GPU加速,加装CUDA和cuDNN。 - PyTorch:访问PyTorch官网(不提供链接),根据系统选择命令,如

pip install torch torchvision。 - Hugging Face:

pip install transformers,并安装配套库如datasets。

安装后,验证是否成功:启动Python解释器,输入import tensorflow as tf; print(tf.__version__),看到版本号,说明环境就绪,更新驱动和库是关键——过时组件导致错误频发,我建议定期运行pip list --outdated检查更新,养成习惯节省调试时间。

加载与使用预训练模型

预训练模型是开源框架的瑰宝,省去从头训练的精力,以Hugging Face为例,它托管数千模型,涵盖翻译、情感分析等,导入库:from transformers import pipeline,创建管道对象,指定任务,如classifier = pipeline("sentiment-analysis"),这自动下载并加载模型到本地,准备输入数据——文本、图像或数值,确保数据清洗:去除噪声、标准化格式,对文本情感分析,输入一句英文句子:result = classifier("I love this product!"),运行后,输出字典包含情感标签和置信度,如{'label': 'POSITIVE', 'score': 0.999}。

在TensorFlow中,加载模型类似,使用Keras API:model = tf.keras.models.load_model('path/to/model'),PyTorch则需model = torch.load('model.pth'),并结合model.eval()进入推理模式,关键点:模型文件需预先下载或训练保存,访问框架文档(不提供链接),查找模型库,如TensorFlow Hub或PyTorch Hub,下载后,存储本地路径,运行时,监控资源使用——大模型耗内存,用nvidia-smi(GPU)或任务管理器调整,个人经验:从小模型起步,比如BERT-base,避免硬件瓶颈,测试简单输入验证功能,逐步扩展。

运行模型与处理输出

模型就绪后,执行推理或训练,推理指应用模型预测新数据,以图像分类为例,用TensorFlow:加载图像,预处理为张量格式,代码片段:image = tf.keras.preprocessing.image.load_img('image.jpg', target_size=(224,224)),转为数组img_array = tf.keras.preprocessing.image.img_to_array(image),再归一化,输入模型:predictions = model.predict(np.expand_dims(img_array, axis=0)),输出概率分布,解析最高置信度类别。

若需训练自定义模型,流程稍复杂,收集数据集,划分训练/验证集,定义模型架构——TensorFlow中用Sequential或函数式API,添加层如tf.keras.layers.Dense(),编译模型,设置优化器和损失函数:model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy']),开始训练:model.fit(train_data, epochs=10, validation_data=val_data),监控指标如准确率,调整超参数,训练后,保存模型model.save('my_model')。

处理输出时,关注可解释性,NLP模型输出词向量,用可视化工具如Matplotlib绘制注意力图,PyTorch中,torch.topk()提取top预测,错误处理不可少——添加try-except块捕获异常,如维度不匹配,实践中,日志记录至关重要:用Python的logging模块追踪过程,便于复盘,我常遇到输出偏差问题,多源于数据质量;确保输入代表真实场景,减少偏见。

最佳实践与常见问题

高效使用框架,需遵循最佳实践,版本控制:用Git管理代码,记录变更,测试驱动开发——写单元测试验证模型行为,如PyTest框架,资源优化:云服务如Google Colab提供免费GPU,本地则用内存管理技巧,TensorFlow的tf.data.Dataset流式加载数据,避免内存溢出,安全方面,模型部署时隔离敏感数据,防止泄露。

常见挑战包括硬件限制——大模型需高性能GPU,预算不足可试量化技术压缩模型,兼容性问题频发:框架更新快,旧代码失效,解决方法:固定库版本pip install tensorflow==2.10.0,并查阅社区论坛,另一痛点是过拟合;训练中用早停(early stopping)或正则化控制,文档是盟友——深入阅读官方指南,参与GitHub讨论,我的教训:跳过文档直接编码,导致数小时调试;我坚持先读后写。

个人观点

作为网站站长,我坚信AI开源模型框架是技术民主化的里程碑,它们降低门槛,让个体和小团队也能撬动AI力量,框架会更智能化,集成AutoML减少手动编码,但核心不变:动手实践才能驾驭——别畏难,从一个小项目开始,比如用Hugging Face做个聊天机器人,积累经验后,你将发现创新无限,社区是你的后盾;贡献代码或分享心得,共同推动这场革命。(字数:约1150字)