想象一下:你需要预测下季度的销售额、量化广告投入对用户增长的影响,或是理解产品价格变动如何牵动市场需求,在这些常见又关键的商业场景里,线性模型往往是你的第一站,它结构清晰、易于解释,是理解变量间关系的强大工具,而如今,人工智能(AI)技术正以前所未有的方式赋能线性模型的构建与应用,让这个过程更智能、更高效,本文将一步步引导你,如何借助AI的力量,驾驭线性模型,从数据中挖掘真知灼见。

第一步:明确目标与理解数据——地基要打牢

任何模型构建都始于清晰的问题定义,你希望通过线性模型解决什么问题?是预测一个连续值(如销售额、房价),还是理解几个关键因素对某个结果的影响程度?明确目标是选择合适工具和方法的前提。

数据是基石,AI驱动的线性建模,其核心优势在于高效处理和分析海量数据,但前提是数据本身可靠、相关,你需要:

- 数据收集与整合: 将与问题相关的所有潜在变量数据收集起来,可能来自数据库、CRM系统、网站分析工具等,AI工具能辅助自动化部分数据抓取和整合流程。

- 数据清洗: 这是至关重要且常被低估的环节,处理缺失值(填充或删除)、识别并处理异常值、检查数据一致性,AI算法可以自动化识别异常模式,甚至基于数据分布智能填充缺失值,比传统手动方法更快更准。数据质量直接决定模型上限,数据质量不过关?再先进的算法也白搭。

- 探索性数据分析(EDA): 运用可视化工具(AI驱动的可视化平台可以自动生成关键图表)初步探索变量分布、变量间的关系(散点图、相关矩阵),这有助于初步判断线性关系是否合理,并筛选潜在的重要特征。

第二步:特征工程——让数据“说话”更清晰

原始数据往往不能直接用于模型,特征工程是提升模型性能的关键艺术,也是AI大显身手的地方:

- 特征选择: 并非所有变量都对预测目标有用,冗余或无关的特征会引入噪音,降低模型性能,AI算法(如基于L1正则化的Lasso回归本身具有特征选择功能,或使用随机森林、XGBoost等模型评估特征重要性)可以自动识别并筛选出最具预测力的特征。

- 特征变换: 对原始特征进行数学变换,使其更符合线性模型的假设(如正态分布)或揭示非线性关系的线性侧面(如取对数、平方),AI可以自动尝试多种变换并评估效果。

- 特征创造: 组合现有特征生成新的、更有意义的特征(如计算比率、差值、交互项),一些高级的AutoML工具能自动探索特征组合的可能性。

第三步:选择与训练模型——AI的核心舞台

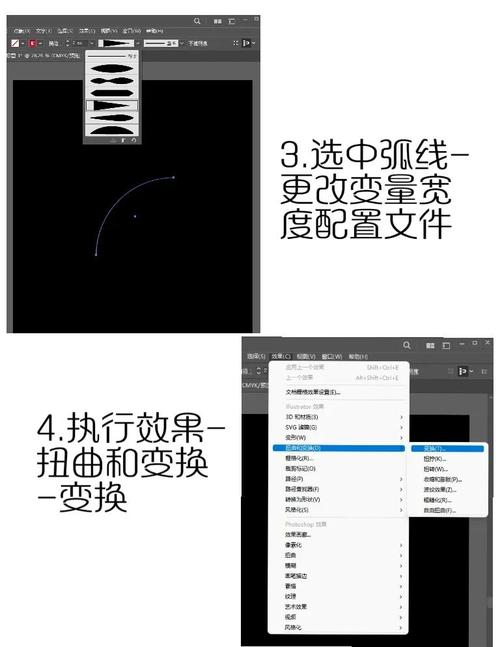

传统上,你需要手动编写代码(如Python的Scikit-learn库)来构建和训练线性回归模型,AI提供了更智能的途径:

- 自动化机器学习(AutoML)平台: 这是目前最便捷的方式,平台如Google Cloud AutoML Tables, H2O.ai, DataRobot, 甚至一些开源库(如TPOT, Auto-sklearn)将整个建模流程自动化,你只需上传清洗好的数据,指定目标变量,平台会自动:

- 尝试多种预处理方法(包括特征缩放、编码)。

- 构建并训练多种模型(包括线性回归及其变种如岭回归、Lasso回归,以及其他模型作为对比)。

- 进行超参数调优(自动寻找最优模型配置)。

- 评估模型性能并选择最佳模型。

- 提供模型解释(如特征重要性、部分依赖图)。

- 编程库(如Python): 对于追求更高控制力和透明度的用户,Python的Scikit-learn库依然是强大选择,AI的助力体现在:

- 智能超参数调优: 使用

GridSearchCV或RandomizedSearchCV进行网格搜索或随机搜索仍是主流,但更先进的优化库(如Optuna, Hyperopt)利用贝叶斯优化等AI算法,能更智能、更高效地找到最优超参数组合,大幅节省计算资源和时间。 - 模型诊断自动化: AI工具可以辅助自动分析残差图、检查异方差性、多重共线性等模型假设是否满足,并给出修正建议。

- 智能超参数调优: 使用

- 选择哪种? AutoML适合快速原型构建、缺乏深厚建模经验的用户,或需要高效处理大量建模任务的情况,手动编程则提供最大灵活性和控制力,适合深入理解模型细节和进行高度定制化开发。

第四步:模型评估与解读——知其然,更要知其所以然

模型训练完成后,绝不能只看训练集上的表现,严谨的评估至关重要:

- 核心评估指标:

- R-squared (R²): 模型解释数据变异性的比例,越接近1越好,但需谨慎,复杂模型在训练集上R²天然高。

- 调整后R²: 考虑了特征数量,惩罚过度复杂模型,更可靠。

- 均方误差/均方根误差: 预测值与实际值偏差的平均大小,RMSE与目标变量单位一致,更易解释。

- 平均绝对误差: 预测误差绝对值的平均值,对异常值不敏感。

- 交叉验证: 将数据分成多份,轮流用一部分做验证,其余做训练,这是评估模型泛化能力(在新数据上表现)的金标准,AI驱动的AutoML平台通常会内置严格的交叉验证。

- 模型诊断:

- 残差分析: 检查残差(预测误差)是否随机分布、是否符合正态性、同方差性假设,残差图是强大的诊断工具,AI可视化工具能高效生成并初步解读这些图。

- 多重共线性检查: 高相关性的特征会扭曲系数估计,计算方差膨胀因子。

- 模型解读(关键!): 线性模型的核心优势在于可解释性,重点关注:

- 系数: 每个特征的系数大小和符号,代表了在控制其他变量不变的情况下,该特征每单位变化对目标变量的平均影响。这是线性模型提供的宝贵业务洞见。

- 特征重要性: AutoML或特定方法提供的排序,帮助你理解哪些因素驱动了预测结果。

- P值/置信区间: 评估系数是否统计显著(即该特征的影响不太可能是偶然发生的),但不要盲目崇拜P值,需结合业务意义和效应大小判断。

第五步:优化、部署与监控——让模型创造价值

初步模型可能不完美,需要迭代优化:

- 优化方向:

- 回到特征工程: 根据模型表现和解读,增加新特征、删除冗余特征、尝试不同变换。

- 尝试不同正则化: 如果过拟合(训练集表现好,测试集差),使用岭回归(L2)或Lasso回归(L1)约束系数大小,Lasso还能做特征选择。

- 处理非线性: 如果关系明显非线性,考虑添加多项式项(如X²)或使用分段线性回归,或者评估是否需要转向更复杂的非线性模型(此时线性模型可能不再是首选)。

- 模型部署: 将训练好的模型集成到生产环境(如网站推荐系统、销售预测仪表盘),云平台通常提供便捷的API部署方式,确保部署流程可监控、可回滚。

- 持续监控: 数据会漂移,业务环境会变,定期用新数据评估模型性能是否下降,建立监控指标(如预测准确率、误差分布),一旦显著下滑,触发模型重训或更新流程,AI可以辅助自动化监控和预警。

提升模型效果的实用技巧

- 特征缩放: 对数值型特征进行标准化(均值为0,标准差为1)或归一化(缩放到[0,1]范围),特别是使用正则化或涉及距离计算时(虽然纯线性回归理论上不需要,但实践中常有益于数值稳定和加速收敛)。

- 理解业务: 再强大的AI工具也无法替代对业务逻辑的深刻理解,特征的选择、结果的解读、模型的优化都离不开业务知识,模型给出的系数,必须放在业务背景下才有意义。

- 可视化是利器: 多用散点图看关系,用残差图诊断问题,用系数图展示影响,好的可视化能直观呈现模型结果和问题。

- 交叉验证是保障: 务必使用交叉验证来估计模型的泛化误差,避免对单一训练/测试分割的过度乐观。

- 可解释性优先: 在商业决策中,一个能清晰解释“为什么”的模型(如线性模型),往往比一个精度略高但像黑盒子一样的复杂模型更有价值,在精度和可解释性间找到业务所需的平衡点。

人工智能并没有改变线性模型的核心原理,但它彻底革新了我们构建、优化和应用线性模型的方式,从自动化数据清洗和特征工程,到智能化的模型选择、超参数调优和严谨评估,再到便捷的部署与监控,AI工具显著降低了技术门槛,提升了效率与可靠性,这让你能将宝贵精力从繁琐的代码和参数调试中解放出来,更聚焦于理解业务问题、解读模型结果并做出明智决策,拥抱AI,让线性模型这个经典工具焕发出更强大的生命力,成为你数据驱动决策旅程中值得信赖的指南针,模型的终极价值不在于其复杂性,而在于它能否清晰、可信地揭示数据规律,并最终转化为可执行的商业洞见,在这个意义上,具备优秀解释力的线性模型,配合AI的赋能,始终是数据分析师和决策者手中不可或缺的利器。