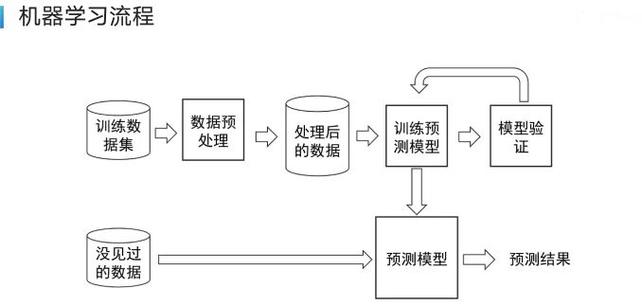

在当今数字化时代,人工智能(AI)已成为推动创新的核心引擎,许多人好奇如何让AI学会新技能,这源于模型训练——一个将原始数据转化为智能系统的过程,作为网站站长,我接触过不少AI项目,深知训练模型是技术的关键环节,下面,我将一步步解释AI模型训练的原理和方法,帮助您理解其核心机制,整个过程涉及数据准备、模型构建和优化评估,看似复杂,但遵循逻辑步骤便能掌握。

数据是AI训练的基石,没有高质量数据,模型如同无源之水,收集数据时,需确保来源可靠且多样化,训练一个图像识别模型,可能需要数千张标注图片,涵盖不同场景和对象,数据量不足会导致模型泛化能力差,容易过拟合现实世界,收集后,预处理必不可少,这包括清洗无效记录、处理缺失值,以及标准化格式,将文本数据转换为数值向量,便于模型处理,预处理能提升数据质量,避免噪声干扰训练结果,数据质量直接影响最终模型性能——垃圾进,垃圾出。

模型选择是关键一步,AI模型有多种类型,如决策树、神经网络或支持向量机,需根据任务需求匹配,对于复杂任务如自然语言处理,深度学习模型(如Transformer)往往更优;简单分类问题则可用线性回归,选择模型时,考虑因素包括计算资源、数据规模和预期精度,在资源有限的环境中,轻量级模型如MobileNet更适合移动设备,模型架构确定后,初始化参数是起点,参数如权重和偏置,通常随机设置,为训练过程奠定基础,这一步需要专业知识,错误选择可能浪费大量时间。

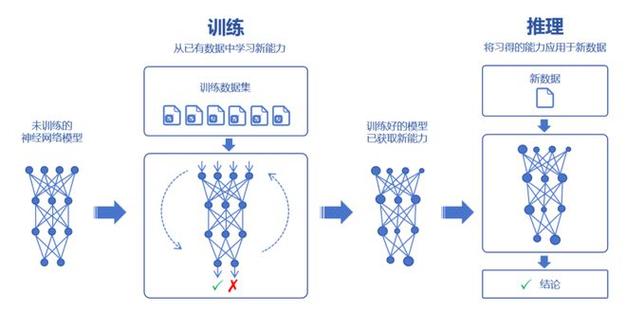

训练过程是AI学习的核心,模型通过迭代优化调整参数,以最小化预测误差,常用方法是监督学习,输入带标签的数据对(如“猫”图片和标签“猫”),模型输出预测,并与真实值比较,差异通过损失函数量化,如均方误差或交叉熵,优化算法如梯度下降,则逐步更新参数,减少损失,每次迭代,梯度下降计算损失函数的导数,并沿负梯度方向调整权重,训练中,超参数设置至关重要,包括学习率、批次大小和迭代次数,学习率过高可能导致震荡不收敛,过低则训练缓慢,实践中,采用小批次训练能平衡效率与稳定性,正则化技术如Dropout防止过拟合,确保模型在未见数据上表现良好。

评估和调优是训练后的必要环节,模型训练完毕,需用独立测试数据集验证性能,常见指标包括准确率、召回率和F1分数,反映模型泛化能力,若性能不佳,需调优超参数或增加数据量,在图像分类任务中,混淆矩阵可识别误分类区域,指导改进,模型部署前,还要进行A/B测试或交叉验证,确保鲁棒性,持续监控模型在真实环境的表现,并根据反馈迭代更新,这步强调AI的动态性——模型不是一成不变,需适应新数据。

从个人经验看,AI模型训练不仅是技术活,更是一场耐心与洞察的旅程,初学者往往急于求成,却忽略了数据质量或超参数细节,我建议从小项目入手,如使用开源框架TensorFlow或PyTorch训练简单分类器,逐步积累经验,关注伦理问题:训练数据需避免偏见,确保公平性,AI发展日新月异,但基础训练原则永恒——扎实的数据、明智的模型选择和严谨的优化,才能孕育出真正智能的系统,随着自动化工具普及,训练门槛将降低,但人类创造力仍是不可替代的核心。