本地运行AI模型:释放算力,掌控你的智能未来

你是否曾惊叹于AI工具的神奇,却又顾虑云端服务的隐私风险、高昂成本或网络依赖?强大的AI模型不再遥不可及,将它们部署在你自己的电脑上运行,正迅速成为一种高效、安全且经济的选择,这不仅是技术极客的玩具,更是摄影师离线精修图片、研究员处理敏感数据、开发者打造独特应用的实用方案。

为何选择本地部署?掌控与效能的双重优势

- 隐私与安全至上: 你的数据,尤其是敏感的商业文件、个人影像或研究资料,全程保留在自己的设备中,彻底规避了云端传输与存储带来的潜在泄露风险,满足最严格的合规要求。

- 成本效益显著: 摆脱按使用量付费的订阅模式,模型一旦部署,后续推理(使用模型生成结果)通常不再产生额外费用,尤其适合高频次或长期使用的场景,一次投入,持续受益。

- 极致响应速度: 本地运行彻底消除网络延迟,模型加载后,生成文本、分析数据或处理图像几乎在瞬间完成,极大提升工作效率和用户体验的流畅度。

- 完全自主可控: 无需依赖第三方服务可用性,断网环境?服务商宕机?这些都不再是阻碍,你拥有对模型版本、运行参数和整个流程的完全控制权。

- 释放离线潜能: 在缺乏稳定网络连接的野外作业、保密环境或移动场景中,本地AI模型是可靠的生产力伙伴,确保智能应用随时随地可用。

踏上本地AI之旅:硬件、软件与模型部署

-

硬件基石:算力决定可能

- GPU:加速核心: 现代大模型(尤其是图像、视频类)运行的关键,NVIDIA显卡凭借成熟的CUDA生态成为首选,显存容量(VRAM)至关重要:

- 入门级 (8GB-12GB VRAM): 可流畅运行7B参数量级的文本模型(如Llama 2 7B, Mistral 7B)或经过优化的扩散模型(Stable Diffusion 较小版本),适合基础文本生成、代码补全。

- 进阶级 (16GB-24GB VRAM): 能驾驭13B-20B参数模型及更大规模的Stable Diffusion版本,支持更高分辨率图像生成和更复杂任务。

- 专业级 (24GB+ VRAM): 挑战30B+参数量级的顶尖开源大模型(如Falcon 40B),处理高分辨率视频生成、复杂多模态任务游刃有余,显存不足时,系统会使用速度慢得多的内存(RAM)或硬盘,体验将大打折扣。

- CPU与内存:坚实后盾: 强大的多核CPU(如AMD Ryzen 9/Intel i7/i9及以上)和充足的内存(32GB是舒适起点,复杂模型或任务建议64GB+)对模型加载、数据处理及GPU协同至关重要。

- 存储空间:模型仓库: 大型模型文件动辄数十GB,高速NVMe固态硬盘(SSD)能显著加速模型加载过程,1TB或更大容量是明智之选。

- GPU:加速核心: 现代大模型(尤其是图像、视频类)运行的关键,NVIDIA显卡凭借成熟的CUDA生态成为首选,显存容量(VRAM)至关重要:

-

软件环境:搭建AI舞台

- Python:通用语言: 绝大多数AI框架和工具链的基础,通过

python.org或Miniconda安装推荐版本(如Python 3.10)。 - 深度学习框架:核心引擎:

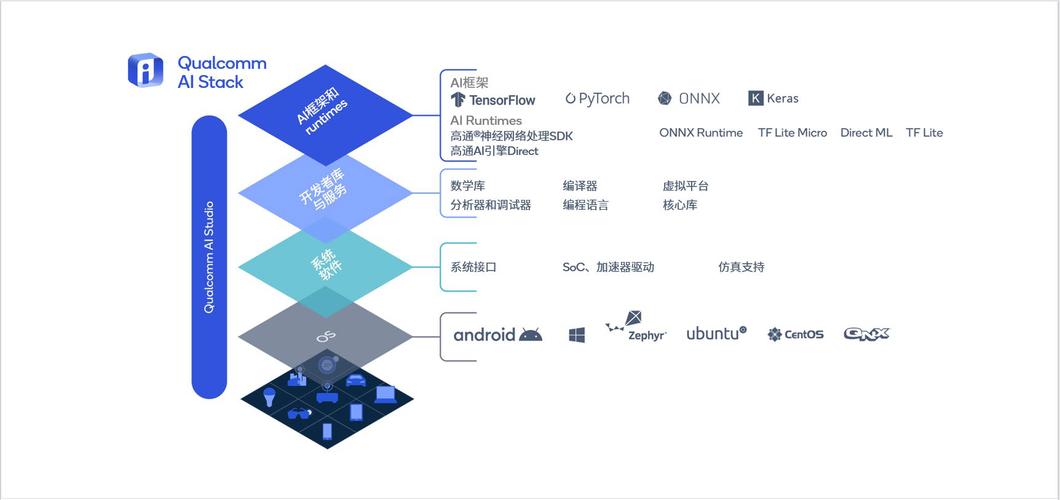

- PyTorch: 当前最活跃、生态最丰富的选择之一,Hugging Face模型库的默认支持框架,安装时务必选择与CUDA版本匹配的GPU版本(

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121以CUDA 12.1为例)。 - TensorFlow: 另一巨头,在特定领域(如生产部署)仍有优势。

- PyTorch: 当前最活跃、生态最丰富的选择之一,Hugging Face模型库的默认支持框架,安装时务必选择与CUDA版本匹配的GPU版本(

- 模型加载神器:Hugging Face

transformers: 这个Python库提供了数万种预训练模型的统一、便捷加载和调用接口,极大简化流程:pip install transformers accelerate(accelerate库用于优化资源利用)。 - 图形界面(可选但推荐): 开源工具提供了直观的操作方式:

- 文本生成:

text-generation-webui(原名oobabooga) 功能强大,支持多种后端和模型格式。 - 图像生成:

Automatic1111的Stable Diffusion WebUI 是事实标准,插件生态丰富。ComfyUI则以节点式工作流见长,适合高阶控制。 - 综合平台:

Ollama(侧重易用性,Mac友好),LM Studio(直观的桌面应用) 降低了命令行操作门槛。

- 文本生成:

- Python:通用语言: 绝大多数AI框架和工具链的基础,通过

-

模型获取与运行:赋予智能生命

- 探索宝库:Hugging Face Hub: 访问

huggingface.co,这是全球最大的开源AI模型社区,利用筛选功能(任务类型、参数量、许可证、所需GPU内存)找到心仪模型,注意查看模型的“Files”选项卡获取实际模型文件(常为.safetensors或.bin+ 配置文件)。 - 下载与配置: 通过

transformers库代码下载,或在GUI工具内直接搜索、下载、加载模型,首次加载特定模型可能需要较长时间(下载并转换)。 - 关键技巧:模型量化: 这是在有限显存下运行大模型的法宝,量化(Quantization)将模型权重从高精度(如32位浮点数)转换为低精度(如4位整数),显著减少内存占用和提升速度,通常只带来轻微质量损失。

bitsandbytes库(集成在text-generation-webui和transformers中)是实现4位量化的常用工具,一个原本需要24GB显存的13B模型,经4位量化后可能只需8GB左右即可运行。 - 发出指令: 在命令行工具或图形界面中输入你的提示词(Prompt),模型将开始生成文本、图片或其他结果,调整温度(Temperature)、最大生成长度等参数可优化输出。

- 探索宝库:Hugging Face Hub: 访问

给探索者的实用建议:高效启航

- 量力而行,由浅入深: 初次尝试,选择7B量级的文本模型(如Mistral 7B)或经过优化的Stable Diffusion 2.1 768-v-ema.ckpt (约5GB),成功运行建立信心后再挑战更大模型。

- 善用量化: 面对显存瓶颈,4位量化是首选方案,务必在Hugging Face Hub确认模型是否提供现成的量化版本(GGML/GPTQ格式常见于

text-generation-webui)。 - 关注社区动态: 本地AI领域发展迅猛,活跃的社区(如Hugging Face论坛、Reddit的

LocalLLaMA、StableDiffusion板块)是获取最新工具、优化技巧和问题解答的宝贵资源。 - 管理期望: 本地运行的模型,尤其是经过量化的版本,其输出质量或速度可能无法完全匹敌顶尖云端API(如GPT-4, Claude 3),但在特定优化场景下,差距正在迅速缩小。

- 耐心调试: 环境配置、依赖冲突是常见挑战,仔细阅读文档、错误日志,善用搜索引擎和社区提问。

本地运行AI模型,意味着将尖端智能从云端“请下来”,真正嵌入到你熟悉的工作流和设备中,这过程虽有硬件门槛和学习曲线,但带来的隐私保障、成本节约和极致响应,是依赖云服务无法比拟的,无论是处理一份敏感的合同草案,还是在灵感迸发的深夜创作独特画作,本地AI都能成为你最可靠、最迅捷的智能伙伴,技术的本质是服务于人,当AI能在你手边自主运转时,创造力与效率的边界便被真正拓宽了。