华为AI模型进程的设置是许多开发者和技术管理者关注的重点,正确配置进程不仅能提升模型运行效率,还能保障系统稳定性与资源利用率,本文将系统介绍华为AI模型进程设置的方法与关键注意事项,帮助您更好地部署和管理AI应用。

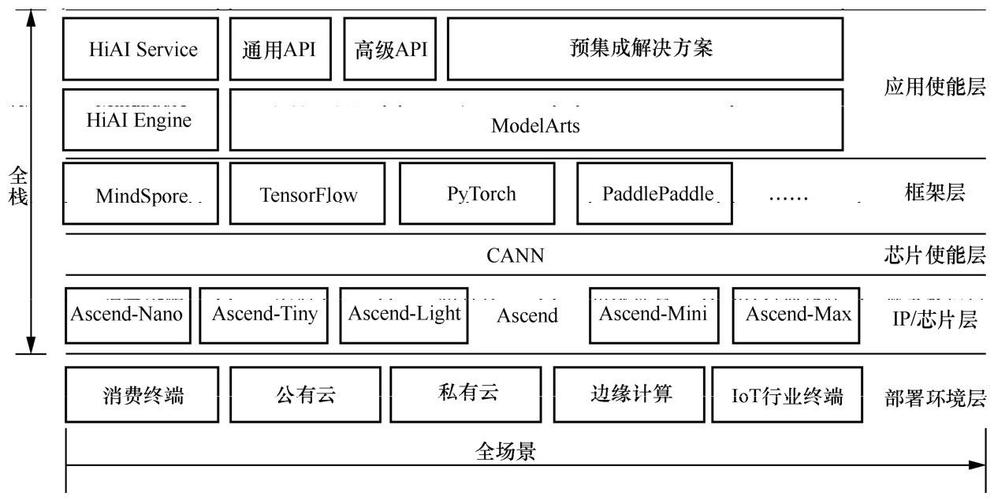

华为AI模型通常运行在昇腾芯片和MindSpore框架环境下,进程设置涉及环境配置、资源分配、模型加载与推理优化等多个环节,以下是具体操作步骤和要点:

环境准备与依赖安装

在开始之前,请确保系统已安装昇腾AI处理器驱动、CANN工具包以及MindSpore框架,这些组件是运行华为AI模型的基础,建议通过华为官方提供的安装脚本或文档进行部署,以避免环境冲突。

进程启动与资源分配

华为AI模型进程通常通过命令行或Python脚本启动,在MindSpore中,可以使用mindspore.context模块设置运行模式(如图模式或PyNative模式)、设备类型(如Ascend、GPU或CPU)及并行策略,以下代码片段展示了如何初始化进程上下文:

import mindspore.context as context context.set_context(mode=context.GRAPH_MODE, device_target="Ascend")

如果需要多进程训练或推理,可通过context.set_auto_parallel_context配置并行策略,包括数据并行、模型并行或混合并行,资源分配方面,建议通过npuratio工具分配计算核心与内存资源,避免进程间资源争用。

模型加载与推理配置

进程启动后,需加载预训练模型或训练脚本,华为提供了ModelZoo和MindSpore Hub等资源,可快速获取预训练模型,加载模型时,需注意输入数据格式与模型结构的匹配,以下是一个简单的模型加载示例:

from mindspore import load_checkpoint, load_param_into_net

param_dict = load_checkpoint("model.ckpt")

load_param_into_net(network, param_dict)

推理过程中,可通过设置Batch Size、开启内存复用等功能优化性能,华为还提供了Ascend平台特有的AOE(Ascend Optimization Engine)工具,可自动优化算子性能与进程调度。

监控与调试

进程运行期间,建议使用Ascend平台提供的Profiling工具监控性能瓶颈,通过日志分析、内存使用统计和算子性能数据,可进一步调整进程参数,可通过msprof工具生成性能报告,识别计算密集型算子并进行优化。

常见问题与解决方案

在实际部署中,可能会遇到进程卡死、内存溢出或计算错误等问题,这类问题通常源于资源分配不足或模型配置错误,建议通过以下方式排查:

- 检查日志文件中的错误信息;

- 验证模型输入数据的维度与类型;

- 调整进程的线程数或内存限制;

- 使用华为官方论坛或文档寻求支持。

华为AI生态正在快速发展,进程设置的工具链和最佳实践也在不断更新,作为开发者,保持与官方文档的同步至关重要,华为AI模型进程设置不仅关乎技术实现,更体现了对系统资源与性能的精细化管理,通过合理配置,AI应用能在昇腾硬件上发挥最大潜力,为业务创新提供坚实基础。