人工智能大模型正逐渐改变我们的生活和工作方式,从智能助手到内容生成,它们的应用无处不在,如果你对搭建自己的AI大模型感兴趣,这篇文章将为你提供一个清晰的指南,帮助你从零开始理解整个过程,构建大模型需要耐心和专业知识,但通过系统化的步骤,任何人都能掌握基本方法。

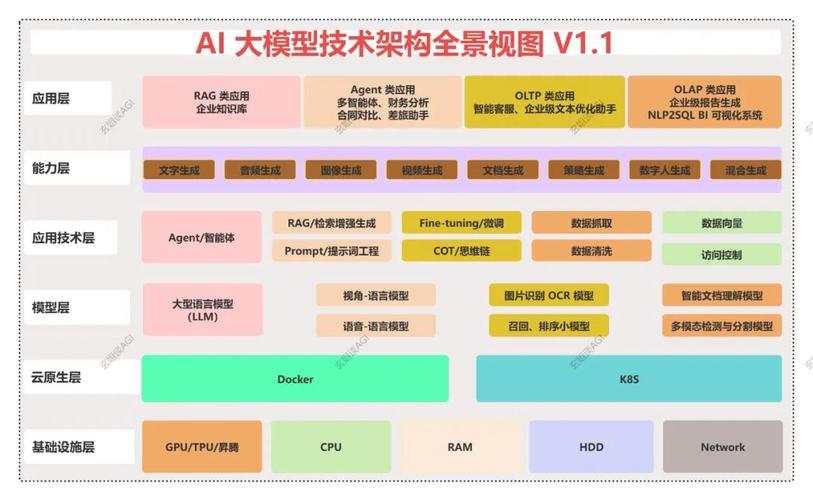

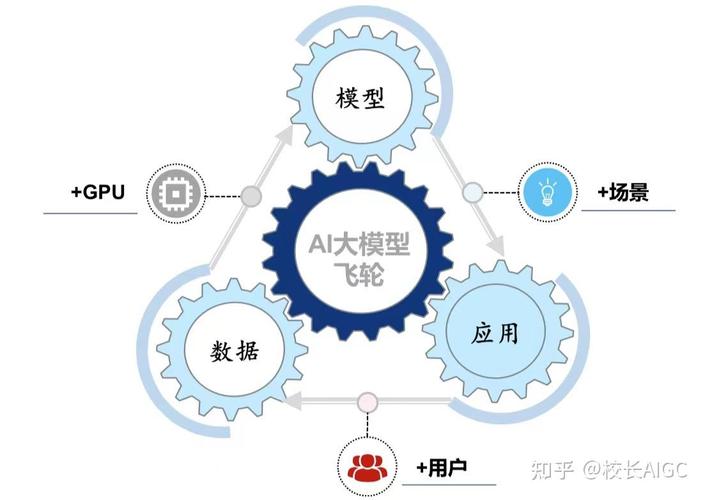

我们需要明确什么是AI大模型,它是一种基于深度学习的模型,能够处理海量数据并执行复杂任务,比如语言理解或图像识别,搭建这样一个模型,不仅仅是技术活,还涉及资源规划、数据管理和持续优化,在开始之前,建议你评估自己的目标:是用于研究、商业应用还是个人项目?这将决定后续步骤的复杂度和投入。

准备工作是搭建AI大模型的基础,你需要收集和清理数据,因为数据质量直接影响模型性能,选择多样化的数据集,确保它们代表真实场景,并进行预处理,比如去除噪声或标准化格式,硬件资源不可忽视;大模型通常需要强大的计算能力,例如GPU集群,以加速训练过程,软件工具方面,流行的框架如TensorFlow或PyTorch可以提供支持,但要根据你的熟悉程度选择,团队协作也很关键,尤其是涉及多学科知识时,确保有数据科学家和工程师参与。

选择适合的模型架构至关重要,常见的架构包括Transformer,它在自然语言处理领域表现突出,你可以从预训练模型开始,比如基于开源项目进行微调,这能节省时间和资源,但要注意,模型设计需平衡复杂度和效率;过于复杂的模型可能导致过拟合,而简单的模型可能无法捕捉数据中的模式,建议先从小规模实验入手,逐步调整参数,观察效果。

训练过程是核心环节,需要耐心和监控,将数据分为训练集、验证集和测试集,以确保模型泛化能力,使用合适的优化算法,如Adam,并设置学习率调度,避免训练不稳定,在训练中,定期检查损失函数和准确率,及时调整超参数,如果遇到性能瓶颈,可以考虑数据增强或迁移学习技术来提升效果,训练大模型可能耗时数天甚至数周,因此要确保系统稳定,并备份中间结果。

评估和优化阶段帮助验证模型是否达到预期,使用多种指标,如准确率、F1分数或困惑度,具体取决于任务类型,如果模型在测试集上表现不佳,可能需要回顾数据质量或架构选择,优化可以通过剪枝、量化或蒸馏等方法,减少模型大小并提高推理速度,考虑伦理和偏差问题,确保模型公平可靠,避免产生负面社会影响。

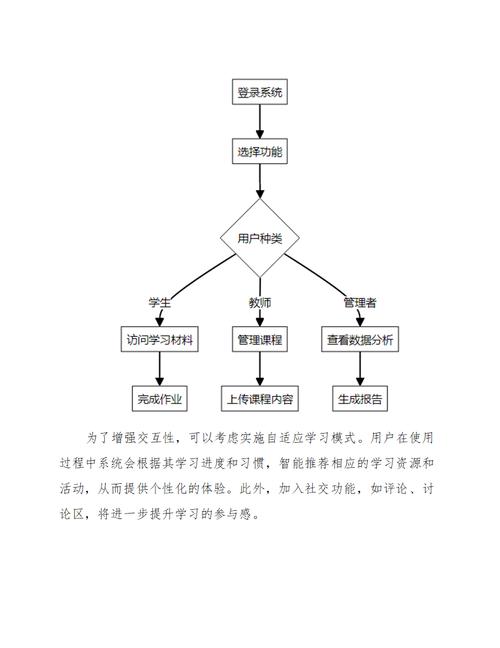

部署模型后,维护是长期任务,监控模型在生产环境中的表现,及时更新以应对数据分布变化,用户反馈是宝贵的资源,能帮助你持续改进,我想分享一个观点:AI大模型的搭建不仅是技术挑战,更是创新机会,随着技术发展,个人和小团队也能参与其中,推动行业进步,关键在于保持学习心态,勇于尝试,并从实践中积累经验,我相信AI将更普及,但我们需要负责任地使用它,确保技术服务于人类福祉。