在数字化转型浪潮中,人工智能模型正逐渐从云端下沉至边缘设备,这种转变不仅提升了响应速度,也降低了云端依赖带来的延迟与成本,对于企业和技术团队而言,将AI模型有效部署至边缘端已成为提升竞争力的关键路径。

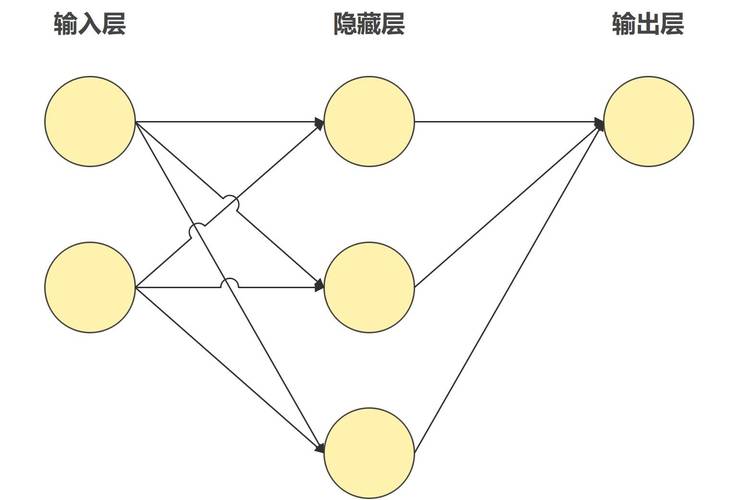

边缘计算的核心在于将数据处理和分析能力迁移到数据产生的源头,例如智能手机、工业传感器、车载设备或智能家居终端,这种架构的优势显而易见:低延迟、高隐私性、弱网络依赖以及更强的实时性,将AI模型推向边缘并非简单地将云端模型压缩后移植,而是一项涉及模型设计、硬件适配、软件部署和持续优化的系统工程。

要实现这一目标,首先需从模型优化入手,常见的做法包括模型剪枝、量化、知识蒸馏等轻量化技术,通过剪枝去除模型中冗余的参数,通过量化将浮点计算转为整型计算,大幅降低计算量和存储需求,选择适合边缘设备的模型架构也至关重要,如MobileNet、SqueezeNet等轻量网络在设计之初就考虑了边缘部署的需求。

硬件选择同样不容忽视,不同的边缘设备具有不同的算力、功耗和内存限制,目前市面上已有多种专为边缘AI设计的芯片,如谷歌的Edge TPU、英伟达的Jetson系列、华为的Ascend系列等,这些芯片在提供足够推理能力的同时,也兼顾了能效比,适合长期部署在资源受限的环境中。

在软件层面,成熟的推理框架能显著降低部署难度,TensorFlow Lite、ONNX Runtime、OpenVINO等工具链支持多种硬件后端,并提供模型转换、优化和调试功能,容器化技术如Docker结合边缘管理平台(如KubeEdge或K3s),可实现模型的大规模远程部署与版本管理,提高运维效率。

数据隐私与安全性也是边缘AI的重要考量,由于数据在本地处理,不必全部上传至云端,用户隐私得到更好保护,但同时也需注意边缘设备本身的安全防护,包括模型加密、访问控制和异常检测等措施,防止模型被恶意篡改或数据泄露。

实际部署过程中,还需考虑模型更新与监控机制,边缘设备分布广泛,传统的手动升级方式难以适用,采用OTA(空中下载)技术结合差分更新方案,可以在不占用过多带宽的情况下实现模型的迭代与优化,建立完善的日志收集与性能监控系统,能够及时发现并处理设备异常,保障服务稳定性。

尽管边缘AI具备诸多优势,但也面临一些挑战,设备异构性强导致标准化难度高,模型在不同硬件上的表现可能存在差异,边缘节点的资源限制使得模型必须严格控制在一定的计算预算内,这对算法设计提出了更高要求。

从技术发展趋势来看,边缘AI正在向更通用、更自适应方向发展,联邦学习等新兴技术允许在保护隐私的前提下,利用边缘数据协同训练模型;而自适应推理技术则使模型能够根据当前设备状态动态调整计算量,平衡精度与效率。

我们认为,将AI模型推向边缘不仅是技术演进的必然,更是构建下一代智能系统的核心,随着芯片算力的提升、算法效率的优化以及工具链的成熟,边缘AI将在智能制造、智慧城市、自动驾驶等领域发挥越来越重要的作用,边缘与云协同的计算模式将成为常态,而掌握边缘部署能力,无疑是企业和开发者在人工智能时代保持领先的关键。