在当今全球化的数字时代,语言不再应该是沟通的障碍,越来越多的企业和个人希望拥有自己的AI翻译模型,以满足特定领域、特定需求下的高质量翻译任务,相比于直接使用现成的翻译服务,自建模型能够更好地控制数据隐私、适应垂直领域术语、并进行深度定制,如何从零开始搭建一个属于自己的AI翻译模型呢?这个过程并没有想象中那么复杂,只要掌握正确的步骤和方法,完全可以实现。

我们需要明确目标,你是希望做一个通用领域的翻译模型,还是针对某个专业领域(如医疗、法律、科技)进行优化?确定方向后,才能更有针对性地准备数据和选择模型结构。

第一步是数据准备,高质量的训练数据是模型成功的基础,你需要准备大量的双语平行语料,即源语言和目标语言一一对应的句子对,数据的质量直接决定了模型的上限,可以通过公开数据集(如OPUS、Tatoeba等)获取,如果是专业领域,可能需要自己收集和整理,重要的是,数据必须经过清洗和预处理,包括去除重复、错误标注和无关内容,并进行分词或子词划分(如BPE、WordPiece),以减少词汇表大小并改善模型泛化能力。

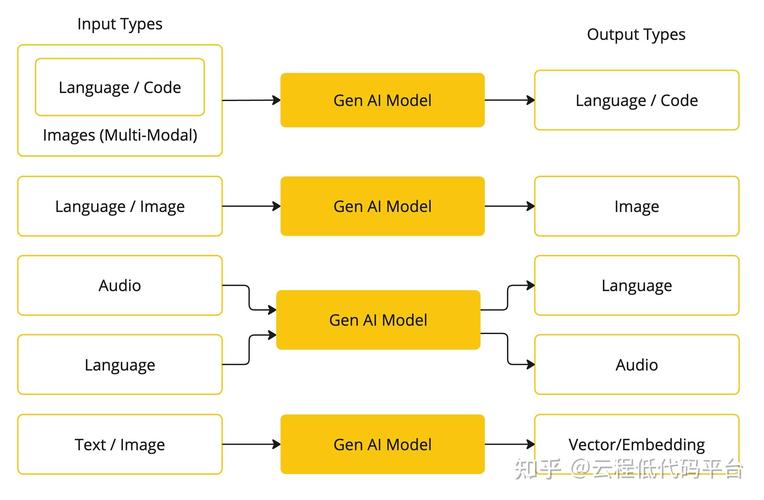

接下来是模型选择,目前主流的是基于Transformer结构的神经机器翻译模型(NMT),Transformer凭借其自注意力机制,能够有效捕捉长距离依赖关系,在翻译任务上表现显著优于之前的循环神经网络(RNN)模型,你可以选择使用开源框架(如TensorFlow、PyTorch)从头编写模型结构,也可以直接使用Hugging Face等平台提供的预训练模型(如mBART、T5)进行微调,后者可以大幅降低训练成本和时长。

然后进入模型训练阶段,你需要配置合适的硬件环境,推荐使用GPU或TPU进行加速,在训练过程中,要合理设置超参数,包括学习率、批次大小、训练轮数等,损失函数通常选择交叉熵,优化器常用Adam,为了避免过拟合,可以使用早停(early stopping)、丢弃(dropout)等技术,训练过程中要持续验证模型在开发集上的表现,监控BLEU等评价指标的变化。

训练完成后,必须对模型进行充分评估,不仅要用BLEU、TER等自动评价指标,最好还能进行人工评价,检查译文在准确性、流畅度和专业性上的表现,针对发现的问题,可能需要回溯调整数据、模型结构或超参数。

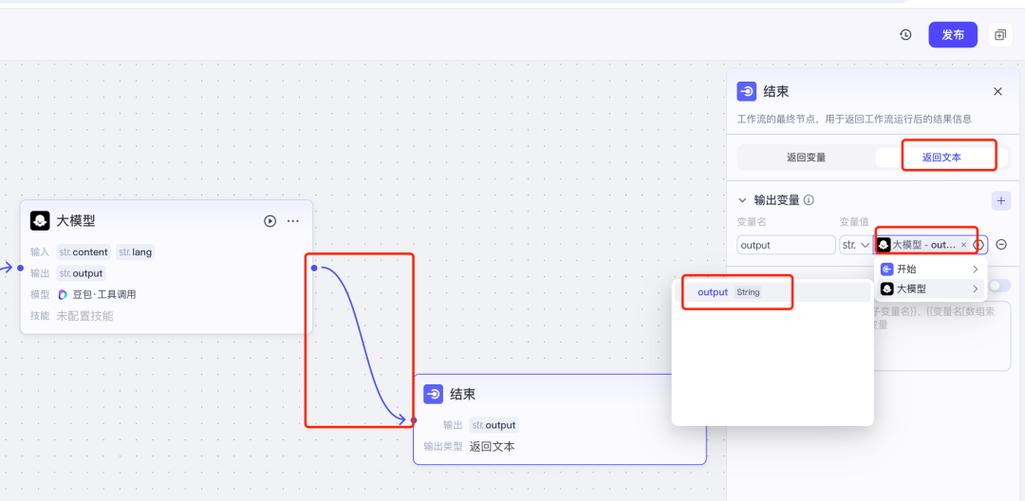

部署与应用,你可以将训练好的模型集成到Web服务、移动应用或本地程序中,提供API接口或用户界面,在部署时,要考虑模型压缩、量化等技术,以提升推理速度并降低资源消耗,建立持续学习机制,随着新数据的积累不断更新模型,保持其性能和市场竞争力。

自建AI翻译模型虽然需要投入一定的时间和资源,但带来的控制力和灵活性是通用服务无法比拟的,从数据清洗到模型优化,每一个环节都能体现你的专业性和独特需求,随着技术工具越来越成熟,相关的门槛也在逐渐降低,只要保持耐心和持续学习的态度,完全可以构建出一个强大而高效的专属翻译系统。

人工智能翻译技术的发展日新月异,作为实践者,最重要的是保持对新技术的好奇与探索,不断迭代和优化自己的方案,真实的应用场景和用户反馈将是推动模型进化的重要动力。