在探索人工智能的浪潮中,AI语音模型以其逼真的合成效果和广泛的应用场景,吸引了无数开发者和技术爱好者的目光,你可能好奇,这样一个能够“开口说话”的模型,究竟是如何从无到有被构建出来的?我们就来深入探讨一下生成一个AI语音模型的核心流程与关键考量。

奠定基石:数据采集与预处理

任何优秀的模型都离不开高质量数据的滋养,对于语音模型而言,数据更是其灵魂所在。

-

数据采集:这是第一步,也是最关键的一步,需要收集大量、高质量的语音录音,这些录音通常需要满足以下条件:

- 高保真度:录音环境安静,音频清晰,无杂音。

- 多说话人:为了模型的泛化能力,通常会收集成百上千名不同年龄、性别、口音说话人的声音。

- 文本覆盖广:对应的文本内容应尽可能覆盖各种发音、词汇和句式,确保模型能学习到丰富的语言特征。

- 时长充足:总时长可能从几十小时到数千小时不等,取决于模型的目标复杂度。

-

数据预处理:原始数据无法直接使用,必须经过精细的清洗和标注。

- 音频清理:去除背景噪声、静音段、口水音等干扰因素。

- 音频分割:将长音频切割成适合模型训练的短句片段。

- 文本转录:为每一段音频提供精确的文本内容,形成“音频-文本”配对数据,这一步的准确性至关重要。

- 文本规范化:将文本中的数字、缩写、特殊符号等转换为标准读音的词汇。

模型架构的选择:核心技术解析

数据准备就绪后,便进入了模型设计的核心环节,目前主流的AI语音生成模型主要基于以下几种技术路径:

-

参数合成与拼接合成:早期技术中,拼接合成通过组合真人录音的小片段来生成语音,自然但灵活性差,参数合成则通过数学模型生成语音参数,再转换为波形,灵活性高但自然度稍逊,现代模型大多基于更先进的参数化思想。

-

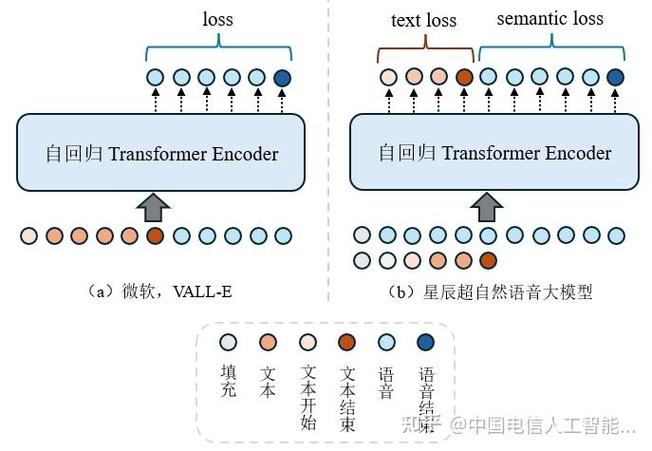

深度学习模型的崛起:当前,基于深度学习的端到端模型已成为绝对主流。

- Tacotron系列:经典的序列到序列模型,能直接将文本映射为声学特征(如梅尔频谱),再通过声码器将特征转换为可听的波形音频。

- WaveNet / WaveRNN:作为强大的声码器,它们能够根据声学特征生成高质量、高保真的原始音频波形,WaveNet效果出众但计算成本高,WaveRNN则在速度与质量间取得了更好平衡。

- FastSpeech系列:为了解决Tacotron系列合成速度慢和稳定性问题,FastSpeech引入了Transformer架构和时长预测器,实现了高质量、高稳定性的并行语音合成,大大提升了生成效率。

训练与迭代:让模型“学会”说话

拥有了数据和模型架构,训练过程就是模型学习与成长的过程。

- 特征提取:从预处理好的音频中提取关键声学特征,如梅尔频谱图、基频、能量等,这些特征是模型需要学习预测的目标。

- 模型训练:将文本序列和对应的声学特征输入模型,模型会不断尝试预测声学特征,并通过损失函数计算预测值与真实值之间的差距,利用反向传播算法,逐步调整模型内部的数百万甚至数十亿个参数,使得预测越来越准确。

- 声码器训练:在端到端流程中,声码器通常需要单独训练,其任务是学习如何将梅尔频谱等特征还原为逼真的音频波形。

- 迭代优化:训练并非一蹴而就,需要根据验证集上的表现,不断调整超参数、增加数据、或优化模型结构,以提升语音的自然度、清晰度和情感表现力。

评估与优化:衡量模型的表现

一个模型训练完成后,如何判断其好坏?这需要一套科学的评估体系。

- 主观评测:组织人力进行听感测试,常用的指标有:

- MOS平均意见分:评测者从语音的自然度、清晰度等方面进行1-5分打分。

- ABX测试:让评测者对比两个模型生成的语音,选择更喜欢的一个。

- 客观评测:通过算法自动计算指标,如:

- 梅尔倒谱失真:衡量合成频谱与真实频谱的差异。

- 字符错误率:将合成语音用ASR识别,与原始文本对比,评估清晰度。

根据评估结果,开发团队会进行针对性的优化,例如针对特定发音不准的问题进行数据增强,或调整模型以改善语速和韵律。

挑战与未来方向

尽管AI语音技术已取得长足进步,但依然面临诸多挑战,生成带有丰富情感和语调变化的语音,实现不同风格的自由切换,以及在低资源语言上的应用,都是当前研究的重点,如何有效防止技术被滥用,例如制造虚假音频进行欺诈,也是行业必须严肃对待的伦理与安全问题。

个人看来,构建一个高质量的AI语音模型是一个系统性工程,它融合了数据科学、信号处理与深度学习的尖端技术,整个过程环环相扣,从最初的数据清洗到最终的模型调优,每一步都需要极大的耐心和严谨的态度,随着技术的不断演进,我们有理由相信,未来的AI语音将不仅仅是信息的传递者,更能成为富有表现力和共鸣的交流伙伴。