部署AI识别模型是许多企业和开发者面临的关键任务,随着人工智能技术的普及,将训练好的模型应用到实际场景中,如图像识别、语音分析或文本分类,能够显著提升效率和创新性,部署过程涉及多个环节,需要仔细规划和执行,本文将逐步介绍如何高效部署AI识别模型,涵盖从模型准备到生产环境的全流程。

模型准备与优化

在部署之前,首先需要确保AI识别模型已经训练完成并经过优化,选择一个合适的模型架构至关重要,例如卷积神经网络(CNN)用于图像识别,或循环神经网络(RNN)用于序列数据,如果使用预训练模型,可以节省大量时间和资源,但必须根据具体需求进行微调。

模型优化包括压缩和加速,以减少推理时间和资源消耗,常见方法包括量化(将浮点数转换为整数)、剪枝(移除冗余参数)和知识蒸馏,这些步骤能提升模型在边缘设备或云端的性能,验证模型的准确性和泛化能力,通过测试数据集确保其在实际应用中表现稳定。

选择部署环境

部署环境的选择直接影响模型的可用性和成本,常见的选项包括云端、本地服务器和边缘设备。

云端部署适合需要高可扩展性和弹性的场景,主流云服务提供商如AWS、Google Cloud和Azure提供了专门的AI工具,可以快速集成模型,这种方式便于管理更新和监控,但可能涉及持续费用。

本地部署适用于数据隐私要求高的企业,例如医疗或金融行业,它需要自建服务器和网络基础设施,确保数据不离开内部环境,尽管初始投资较高,但能提供更好的控制力。

边缘部署将模型部署到设备端,如智能手机或物联网设备,实现低延迟推理,这对于实时识别应用非常关键,例如自动驾驶或安防监控,边缘部署通常需要优化模型以适应有限的硬件资源。

部署方法与工具

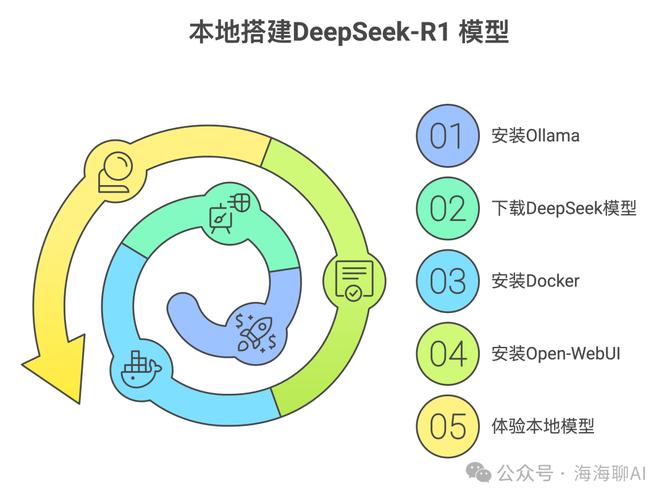

部署AI识别模型时,有多种方法和工具可供选择,容器化技术如Docker和Kubernetes能简化环境管理,确保一致性,将模型打包为Docker镜像后,可以在不同平台上无缝运行。

API集成是另一种流行方式,通过RESTful或gRPC接口暴露模型功能,允许其他应用程序调用,这适用于Web或移动应用集成,框架如TensorFlow Serving或TorchServe专门设计用于高性能模型服务。

对于快速原型,可以使用无服务器架构,例如AWS Lambda,它自动处理资源分配,适合突发性负载,但需注意冷启动延迟问题。

在工具选择上,开源库像OpenVINO或TensorRT能加速推理过程,尤其针对特定硬件优化,版本控制工具如Git帮助跟踪模型变更,确保部署的可靠性。

测试与验证

部署后,必须进行全面的测试和验证,以确保模型在生产环境中稳定运行,功能测试检查模型是否能正确执行识别任务,例如输入样本数据并验证输出,性能测试评估响应时间、吞吐量和资源使用情况,使用工具如Apache JMeter模拟高负载场景。

安全测试不可忽视,防止对抗性攻击或数据泄露,实施输入验证和加密措施,确保模型接口不被滥用,A/B测试可以帮助比较不同模型版本的性能,选择最优方案。

监控和日志记录是持续运营的关键,集成监控工具如Prometheus或Grafana,实时跟踪模型指标,如准确率下降或异常请求,这有助于快速发现问题并迭代优化。

维护与迭代

AI模型部署不是一次性任务,而是需要持续维护,随着数据分布变化,模型可能出现性能衰减,因此定期重新训练是必要的,建立自动化流水线,使用MLOps工具如Kubeflow或MLflow,简化模型更新和部署流程。

用户反馈和业务需求变化也应纳入迭代计划,如果识别模型在特定场景下误判率高,可以收集新数据并重新微调,保持与团队沟通,确保模型与整体系统协同工作。

从个人视角看,部署AI识别模型是一个融合技术和战略的过程,它不仅要求扎实的工程能力,还需要对业务场景的深入理解,随着自动化和标准化工具的进步,部署将变得更高效,但核心仍在于平衡速度与质量,每个组织都应根据自身需求,选择适合的路径,避免盲目跟风,成功的部署能推动创新,为用户带来实实在在的价值。