在当今人工智能技术飞速发展的时代,AI生成模型已成为许多开发者和研究者的重要工具,无论是用于文本生成、图像创作,还是其他创意任务,正确导入模型是使用这些强大功能的第一步,对于初学者来说,这个过程可能显得有些复杂,但只要掌握基本方法,就能轻松上手,本文将详细介绍如何导入AI生成模型,涵盖常见框架和实用技巧,帮助您快速集成模型到自己的项目中。

了解AI生成模型的基本概念是关键,AI生成模型通常指经过训练后能够生成新内容的机器学习模型,例如语言模型或图像生成器,这些模型以文件形式存储,包含权重和架构信息,导入模型意味着将这些文件加载到编程环境中,以便进行推理或进一步训练,常见的框架包括TensorFlow、PyTorch和Hugging Face的Transformers库,每种框架都有其独特的导入方式。

在开始导入前,您需要准备好开发环境,确保已安装所需的Python库,例如TensorFlow或PyTorch,如果您使用预训练模型,Hugging Face的Transformers库是一个极佳选择,它提供了大量现成模型,安装这些库通常通过pip命令完成,例如运行“pip install transformers”来获取相关工具,环境配置完成后,下一步是获取模型文件,模型文件可能来自官方仓库、社区分享或自定义训练结果,对于开源模型,您可以直接从Hugging Face Hub或其他平台下载;如果是私有模型,则需确保文件路径正确。

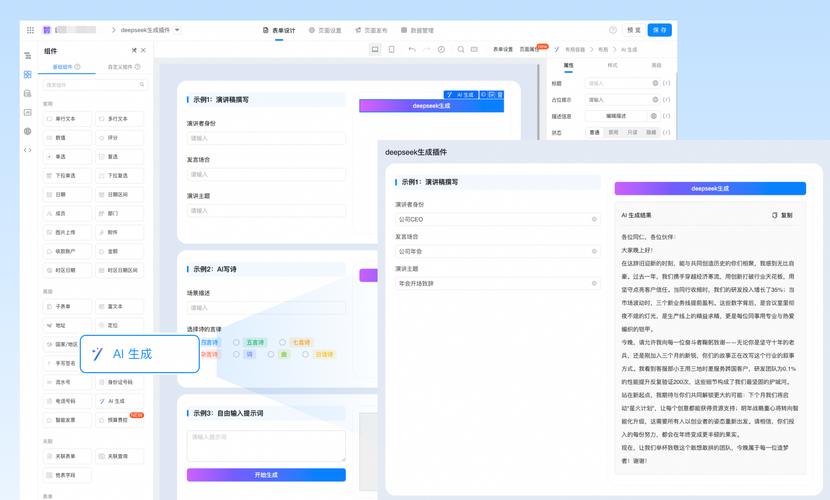

我们以PyTorch为例,演示导入模型的具体步骤,导入必要的模块,例如torch和transformers,使用库提供的函数加载模型和分词器,对于GPT-2模型,您可以这样写代码:

from transformers import GPT2LMHeadModel, GPT2Tokenizer

model = GPT2LMHeadModel.from_pretrained('gpt2')

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

这段代码会自动下载并加载预训练模型和分词器,如果您有本地模型文件,可以指定路径代替模型名称,类似地,在TensorFlow中,使用tf.keras.models.load_model函数或相关方法导入模型,无论哪种框架,核心原则是确保模型文件与代码兼容,并处理可能的依赖问题。

导入过程中,常见问题包括版本冲突、内存不足或文件损坏,为避免这些问题,建议在虚拟环境中操作,并检查库的版本兼容性,某些模型可能需要特定版本的PyTorch或TensorFlow,如果模型较大,确保您的设备有足够内存来加载权重,您可以使用分批加载或量化技术来优化资源使用。

除了代码层面的导入,还需考虑模型的安全性和伦理问题,AI生成模型可能涉及偏见或隐私风险,因此在导入前,评估模型来源的可靠性至关重要,选择知名机构或社区验证的模型,可以降低潜在问题,测试模型的输出是否符合预期,通过简单输入验证其功能。

从个人经验来看,导入AI生成模型不仅是技术操作,更是对整体项目规划的考验,我建议初学者从简单模型开始,逐步尝试复杂架构,同时记录每一步的细节,在团队协作中,文档化导入流程能大大提高效率,关注框架的更新和社区动态,可以帮助您及时适配新功能。

随着AI技术的普及,模型导入过程正变得越来越简化,我们可能会看到更多自动化工具,让非专业人士也能轻松使用,但无论如何,理解底层原理仍是避免错误的关键,通过实践和不断学习,您将能高效地利用AI生成模型,推动创新项目的发展。