数据采集:高质量语音库的构建基础

语音数据的质量直接决定最终模型的输出效果,采集环节需遵循三个原则:完整性、清晰度和多样性,建议录制时长不低于10小时的原始音频,包含不同场景下的发音特征。

-

录音环境标准化

选择隔音效果良好的空间,使用专业麦克风进行录制,保持与麦克风30厘米左右的距离,避免呼吸声和杂音干扰,若需模拟特定场景(如户外通话),需在后期标注环境特征。

-

设计

覆盖常见字词、成语、专业术语及情感表达语句,建议采用《现代汉语常用词表》作为基础,加入20%个性化语句以捕捉发音习惯。 -

多维度信息标注

对音频文件进行分层标注,包括:

- 基础文本内容

- 情感标签(愉悦/严肃/惊讶等)

- 语速与停顿标记

- 特殊发音注释(方言/口癖)

预处理流程:提升模型训练效率的关键

未经处理的原始数据可能包含影响模型训练的噪声,预处理环节可将数据可用性提升40%以上。

核心处理步骤:

- 降噪处理:使用Audacity或Adobe Audition消除环境噪音

- 音频分割:按语句切分音频,单片段时长控制在3-10秒

- 特征提取:提取梅尔频谱图作为模型的输入特征

- 数据增强:通过变速、变调生成扩展样本

技术提示:采用Praat语音分析软件可精准检测基频特征,对特殊发音片段进行二次校准。

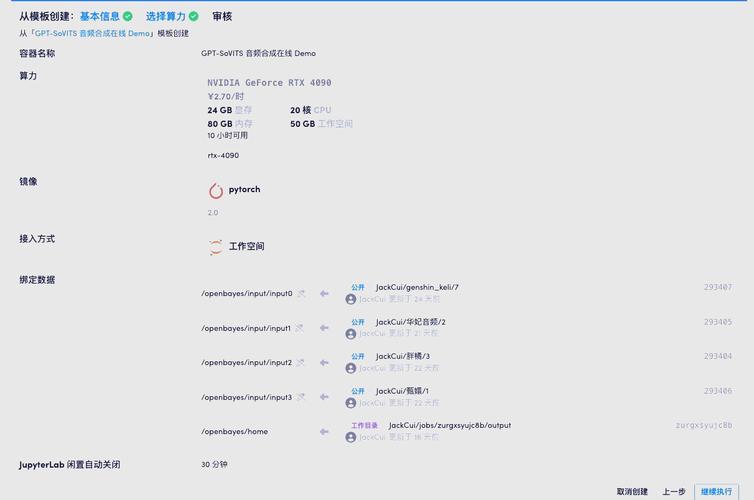

模型架构选择:平衡效果与成本的决策

根据应用场景选择合适的模型架构:

| 模型类型 | 训练耗时 | 硬件需求 | 适用场景 |

|---|---|---|---|

| Tacotron2 | 30-50小时 | 单GPU | 基础语音合成 |

| FastSpeech2 | 20-40小时 | 多GPU | 实时合成系统 |

| VITS | 50-80小时 | 专业算力 | 高拟真情感语音 |

推荐方案:

- 个人开发者:基于PaddleSpeech框架快速部署

- 企业级应用:采用NVIDIA Riva定制化训练

训练参数优化:提升模型表现的核心技巧

-

学习率动态调整

采用warmup策略,前5000步将学习率从0逐步提升至0.001,避免初期震荡 -

批次大小设置

根据显存容量选择最大批次,通常建议:

- 8GB显存:batch_size=8

- 24GB显存:batch_size=32

- 正则化配置

添加L2正则化(λ=0.01)和Dropout(rate=0.2)防止过拟合

典型案例:某有声书平台通过调整音素对齐损失函数权重,使合成语音的自然度提升27%。

合成效果评估与迭代

建立多维度的评估体系,结合客观指标与主观体验:

量化指标:

- MCD(梅尔倒谱失真):低于6.5为优质输出

- F0 MSE(基频误差):控制在20Hz以内

人工评测维度:

- 发音准确度(错误字数占比)

- 情感表现力(5分量表评分)

- 场景适配性(特定环境下的自然程度)

建议每迭代3个版本进行一次ABX测试,通过用户盲测选择最优模型。

伦理规范与法律风险规避

开发过程中需特别注意:

- 训练数据需获得说话人书面授权

- 商业应用前完成《深度合成服务算法备案》 需添加可识别标识(如特定频率水印)

- 建立使用日志留存系统,满足60天可追溯要求