AI模型的运行与使用:从入门到实践

在人工智能技术快速发展的今天,AI模型已成为许多领域的核心工具,但对于普通用户或刚入门的开发者来说,“如何打开AI模型”这一问题可能令人困惑,本文将深入浅出地解释AI模型的使用流程,帮助读者理解其背后的逻辑,并掌握实际操作的关键步骤。

理解AI模型的本质

AI模型并非传统意义上的“文件”或“软件”,而是一套由数据和算法构成的逻辑框架,它通过训练学习特定任务(如图像识别、文本生成等),最终形成可预测或决策的能力。“打开”AI模型的本质是调用其功能,而非简单地双击某个程序。

常见的AI模型类型包括:

- 预训练模型:如GPT、ResNet等,由大型机构训练并公开,用户可直接调用。

- 自定义模型:用户根据需求自行训练,适用于特定场景。

运行AI模型的准备工作

在调用模型前,需搭建适合的环境和工具,以下是核心步骤:

环境配置

- 编程语言支持:大多数AI模型依赖Python环境,需安装Python(推荐3.8及以上版本)。

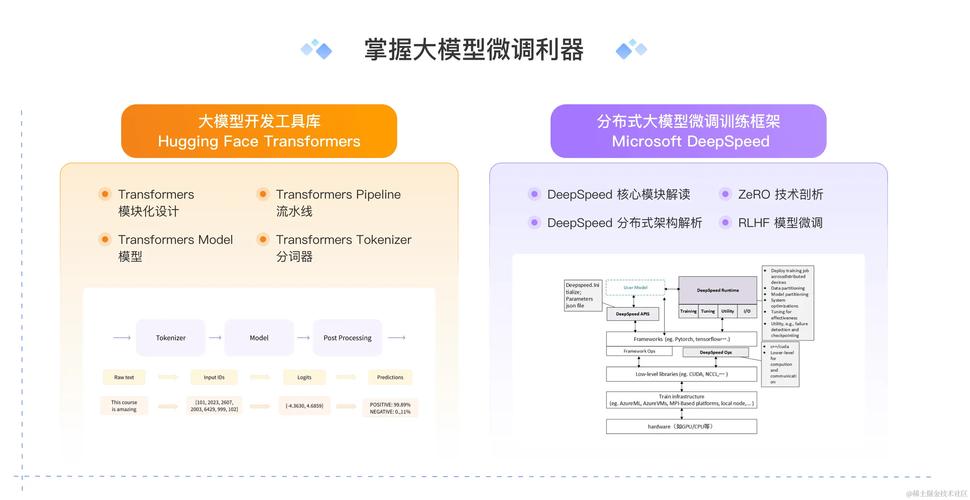

- 深度学习框架:根据模型类型选择框架,如TensorFlow、PyTorch或Keras。

- 依赖库安装:通过

pip或conda安装模型所需的库(如NumPy、Pandas)。

示例代码(安装PyTorch):

pip install torch torchvision

获取模型文件

- 官方渠道下载:从Hugging Face、TensorFlow Hub等平台获取预训练模型。

- 自定义模型加载:若自行训练过模型,需保存为特定格式(如

.pt、.h5)。

调用AI模型的核心步骤

以图像分类模型为例,演示从加载到使用的完整流程。

加载模型文件

模型文件通常包含架构(模型结构)与权重(训练后的参数),需通过代码将其载入内存。

示例代码(PyTorch加载模型):

import torch

model = torch.load('model.pth')

model.eval() # 设置为评估模式

预处理输入数据

AI模型对输入格式有严格要求,以图像分类为例,需将图片转换为张量(Tensor),并进行归一化、尺寸调整等操作。

示例代码(图像预处理):

from PIL import Image

import torchvision.transforms as transforms

image = Image.open('input.jpg')

preprocess = transforms.Compose([

transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

input_tensor = preprocess(image).unsqueeze(0)

运行模型并获取结果

将处理后的数据输入模型,执行推理(Inference)并解析输出。

示例代码(执行预测):

with torch.no_grad():

output = model(input_tensor)

probabilities = torch.nn.functional.softmax(output[0], dim=0)

结果后处理

根据任务需求,将模型输出转化为可读信息,图像分类需匹配标签,文本生成需解码为自然语言。

常见问题与解决方案

- 环境报错:检查Python版本、库的兼容性,使用虚拟环境(如venv)隔离依赖冲突。

- 模型加载失败:确认模型文件完整,且框架版本与训练时一致。

- 输入格式错误:严格遵循模型的输入规范(如尺寸、数据类型)。

提升使用效率的技巧

- 使用GPU加速:若设备支持,启用CUDA可大幅提升推理速度。

- 模型轻量化:通过剪枝、量化等技术压缩模型,降低资源消耗。

- 借助API服务:若本地运行困难,可调用云端AI接口(如百度AI、阿里云)。

AI模型的安全与伦理

在调用模型时,需注意:

- 数据隐私:避免输入敏感信息,尤其在使用第三方API时。

- 版权合规:确保使用的预训练模型符合开源协议。

- 结果验证:AI可能存在偏见或错误,需结合人工审核。

个人观点

AI模型的“打开”不仅是技术操作,更是对逻辑的理解与应用,对于普通用户,从简单的预训练模型入手,逐步熟悉框架和代码,是快速上手的有效路径;对于开发者,深入掌握模型原理与优化方法,才能释放AI的真正潜力,技术的门槛正在降低,但核心仍在于持续学习与实践。