第一步:精准定义需求与目标

在开始编写任何代码前,需明确三个核心问题:

- 模型解决什么具体问题?

图像分类需明确识别类别(如医学影像中的肿瘤检测),自然语言处理需确定任务类型(如情感分析或文本摘要)。 - 性能指标如何量化?

准确率、召回率或F1值的选择直接影响模型优化方向,工业场景中常需平衡推理速度与精度,如自动驾驶系统要求毫秒级响应。 - 资源限制有哪些?

硬件条件(是否使用GPU集群)、数据规模(百万级或千级样本)将决定技术选型。

案例:某电商公司搭建推荐系统时,发现用户点击率提升5%即可带来千万级营收增长,因此将“CTR预估”作为核心目标,并优先选择轻量级模型以适应实时推荐需求。

第二步:构建高质量数据集

数据质量直接决定模型上限,需遵循“采集-清洗-标注-增强”四步法则:

- 数据采集:优先使用公开数据集(如Kaggle、UCI),若需自建数据,可通过爬虫工具(Scrapy)或传感器(物联网设备)获取。

- 异常值处理:利用Pandas库识别缺失值(

df.isnull().sum()),采用中位数填充或直接删除噪声样本。 - 标注规范:图像标注推荐使用LabelImg,文本分类可使用Prodigy工具提升标注效率。

- 数据增强:CV领域可通过旋转、裁剪增加图片多样性,NLP可采用同义词替换(TextAttack库)或回译技术扩充文本数据。

避坑提示:避免将测试集信息泄露到训练过程,建议使用Scikit-learn的train_test_split函数严格划分数据。

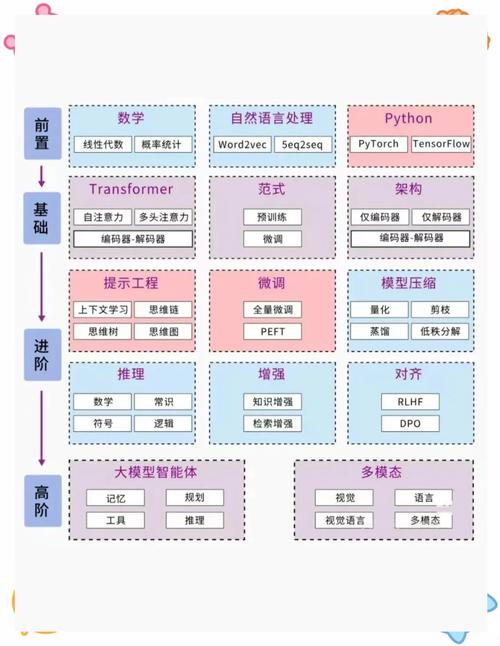

第三步:模型架构设计与工具选型

根据任务类型选择成熟框架降低开发难度:

- 深度学习首选:TensorFlow适合生产环境部署,PyTorch在科研领域更灵活(动态计算图优势)。

- 快速验证方案:Hugging Face的Transformer库提供数百种预训练模型,只需修改顶层网络即可适配新任务。

- 传统机器学习:Scikit-learn的SVM、随机森林算法在小数据集上表现优异,适合计算资源有限场景。

关键决策点:

- 是否采用迁移学习?例如使用ResNet-50的预训练权重加速医疗图像分类任务。

- 模型复杂度是否匹配数据规模?防止过拟合需遵循“参数数量不超过训练样本数10%”的经验法则。

第四步:模型训练与调优技巧

- 超参数设置

- 学习率:使用Cyclical Learning Rates(CLR)动态调整,避免手动调参的低效性。

- 批次大小:GPU显存充足时增大batch size可提升训练速度(通常设置为32/64/128)。

- 训练监控

- 可视化工具:TensorBoard实时跟踪损失曲线,Detectron2提供目标检测任务的交互式看板。

- 早停机制(Early Stopping):当验证集损失连续3个epoch未下降时自动终止训练。

- 模型压缩

- 知识蒸馏:用大模型(Teacher)指导小模型(Student)训练,在移动端部署时可减少75%体积。

- 量化处理:将FP32权重转换为INT8格式,推理速度提升2-3倍(TensorRT工具链支持)。

第五步:部署与持续迭代

- 生产环境部署

- 服务化封装:使用Flask或FastAPI将模型包装为RESTful API,Docker容器化保证环境一致性。

- 边缘计算优化:TensorFlow Lite、ONNX Runtime可在手机/嵌入式设备运行模型。

- 监控与更新

- 性能衰减检测:当线上A/B测试显示准确率下降3%时触发模型重训练。

- 数据闭环构建:收集用户反馈数据自动进入标注系统,形成迭代正循环。

某智能客服系统的实战经验显示,通过每周更新对话模型,用户满意度从68%提升至89%,关键在于建立了自动化数据回流管道。

个人观点

AI模型开发如同搭建乐高积木——既需要标准化模块(框架/工具)缩短工期,更依赖工程师对业务逻辑的深度理解,初学者常陷入“追求最新模型”的误区,而实际项目中,合理的数据处理流程比复杂算法更能提升效果,建议从Kaggle竞赛案例入手,先复现经典方案,再针对具体场景做减法优化,技术的价值不在于复杂度,而在于解决真实问题的效率。